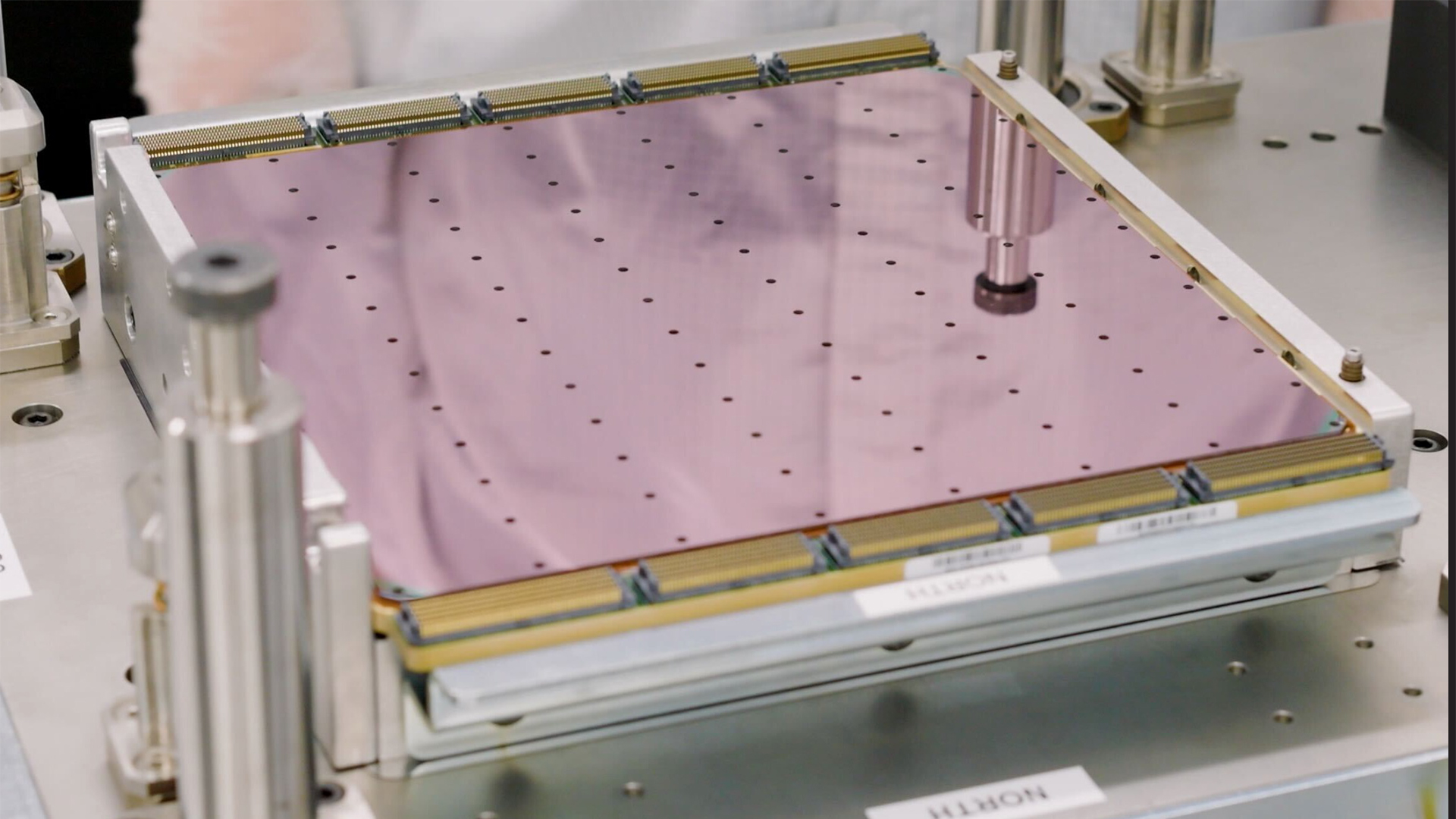

Cerebras Systems ha presentado su Wafer Scale Engine 3 (WSE-3), un innovador chip de IA a escala de oblea con el doble de rendimiento que su predecesor, el WSE-2. Este nuevo dispositivo incluye 4 billones de transistores fabricados con el proceso de fabricación de clase 5 nm de TSMS; 900.000 núcleos de IA; 44 GB de SRAM en chip; y tiene un rendimiento máximo de 125 FP16 PetaFLOPS. El WSE-3 de Ceberas se utilizará para entrenar algunos de los modelos de IA más grandes de la industria. El WSE-3 impulsa la supercomputadora CS-3 de Cerebras, que puede usarse para entrenar modelos de IA con hasta 24 billones de parámetros, un salto significativo con respecto a las supercomputadoras impulsadas por el WSE-2 y otros procesadores de IA modernos. La supercomputadora puede admitir 1,5 TB, 12 TB o 1,2 PB de memoria externa, lo que le permite almacenar modelos masivos en un único espacio lógico sin particiones ni refactorización, lo que agiliza el proceso de capacitación y mejora la eficiencia de los desarrolladores. (Crédito de la imagen: Cerebras) En términos de escalabilidad, el CS-3 se puede configurar en clústeres de hasta 2048 sistemas. Esta escalabilidad le permite ajustar 70 mil millones de modelos de parámetros en solo un día con una configuración de cuatro sistemas y entrenar un modelo Llama 70B desde cero en el mismo período de tiempo a escala completa. El último Cerebras Software Framework ofrece soporte nativo para PyTorch 2.0 y también admite escasez dinámica y no estructurada, lo que puede acelerar el entrenamiento, hasta ocho veces más rápido que los métodos tradicionales. Imagen 1 de 2 (Crédito de la imagen: Cerebras) (Crédito de la imagen: Cerebras) Cerebras ha enfatizado la eficiencia energética superior y la facilidad de uso del CS-3. A pesar de duplicar su rendimiento, el CS-3 mantiene el mismo consumo de energía que su predecesor. También simplifica el entrenamiento de modelos de lenguaje grandes (LLM), que requieren hasta un 97 % menos de código en comparación con las GPU. Por ejemplo, un modelo de tamaño GPT-3 requiere sólo 565 líneas de código en la plataforma Cerebras, según la empresa. La compañía ya ha visto un interés significativo en el CS-3 y tiene una importante acumulación de pedidos de varios sectores, incluidos el empresarial, el gubernamental y el de nubes internacionales. Cerebras también colabora con instituciones como el Laboratorio Nacional Argonne y la Clínica Mayo, destacando el potencial del CS-3 en el ámbito sanitario. (Crédito de la imagen: Cerebras) Una asociación estratégica entre Cerebras y G42 también se expandirá con la construcción del Condor Galaxy 3, una supercomputadora de inteligencia artificial con 64 sistemas CS-3 (con la friolera de 57,600,000 núcleos). Juntas, las dos compañías ya han creado dos de las supercomputadoras de inteligencia artificial más grandes del mundo: la Condor Galaxy 1 (CG-1) y la Condor Galaxy 2 (CG-2), que tienen su sede en California y tienen un rendimiento combinado de 8 ExaFLOP. Esta asociación tiene como objetivo ofrecer decenas de exaFLOP de computación de IA a nivel mundial. «Nuestra asociación estratégica con Cerebras ha sido fundamental para impulsar la innovación en el G42 y contribuirá a la aceleración de la revolución de la IA a escala global», afirmó Kiril Evtimov, director del Grupo. CTO del G42. «Condor Galaxy 3, nuestra próxima supercomputadora de IA con 8 exaFLOP, se encuentra actualmente en construcción y pronto llevará la producción total de computación de IA de nuestro sistema a 16 exaFLOP».

Source link

Deja una respuesta