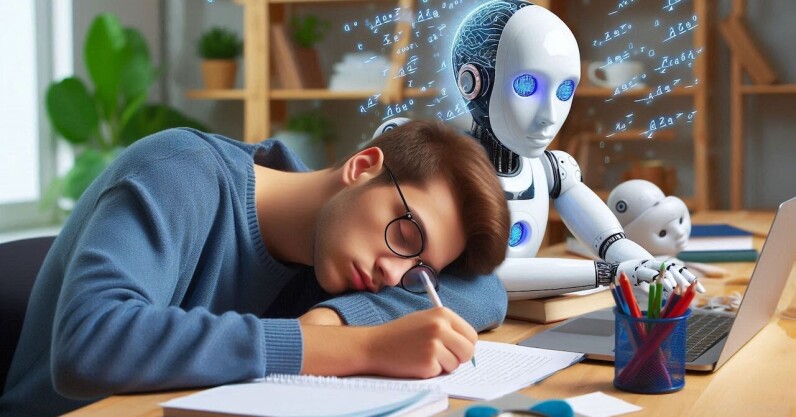

Desde el debut de Chatgpt en 2022, la IA generativa ingresó rápidamente a nuestro trabajo, estudio y vidas personales, ayudando a acelerar la investigación, la creación de contenido y más a un ritmo sin precedentes. El entusiasmo por las herramientas generativas de IA ha ganado tracción experimentando una tasa de adopción aún más rápida que Internet o PCS, pero los expertos advierten que debemos proceder con precaución. Al igual que con todas las nuevas tecnologías, la IA generativa puede lanzar a la sociedad hacia adelante de varias maneras, pero también puede traer consecuencias si no se controla. Una de esas voces es Natasha Govender-Ropert, jefe de IA por delitos financieros en Rabobank. Se unió al fundador de TNW, Boris Veldhuijzen Van Zanten, en el último episodio de «Kia’s Next Big Drive» para hablar de ética de IA, sesgo y si estamos subcontratando nuestros cerebros a las máquinas. Echa un vistazo a la entrevista completa, grabada en ruta a TNW2025 en el EV9 totalmente eléctrico de Kia: el 💜 de la tecnología de la UE los últimos rumores de la escena tecnológica de la UE, una historia de nuestro sabio fundador Boris y algunos cuestionables arte de IA. Es gratis, cada semana, en su bandeja de entrada. ¡Regístrese ahora! Una pregunta que debería estar en nuestras mentes es, a medida que recurrimos a la IA generativa cada vez más para respuestas, ¿qué impacto podría tener esta dependencia en nuestra propia inteligencia? Un estudio reciente realizado por el MIT sobre el uso de ChatGPT para escribir ensayos se ha convertido en una serie de titulares sensacionalistas, desde «los investigadores dicen que usar chatgpt puede pudrir su cerebro» hasta «chatgpt podría estar haciendo que sea flojo y tonto». ¿Ese es realmente el caso? Su cerebro en Gen AI Esto es lo que realmente sucedió: los investigadores dieron a 54 estudiantes de Boston-Suding una tarea de ensayo. Un grupo usó ChatGPT, otro usó Google (sin la ayuda de IA), y el tercero tuvo que escribir usando nada más que sus cerebros. Mientras escribieron, su actividad cerebral se midió usando electrodos. Después de tres sesiones, el grupo solo cerebral mostró los niveles más altos de conectividad mental. ¿Usuarios de chatgpt? El más bajo. Parecía que la gente asistida de AI estaba navegando en piloto automático, mientras que los otros tenían que pensar más para obtener palabras en la página. Para la cuarta ronda, los roles se invirtieron. El grupo solo por cerebro pudo usar ChatGPT esta vez, mientras que el grupo de IA tuvo que ir solo. El resultado? El primero mejoró sus ensayos. Este último luchó para recordar lo que habían escrito en primer lugar. En general, el estudio encontró que durante los cuatro meses durante los cuales se llevó a cabo, los participantes solo por cerebro superaron a los otros grupos en términos de niveles neuronales, lingüísticos y de comportamiento, mientras que aquellos que usaron ChatGPT pasaron menos tiempo en sus ensayos, simplemente golpeando la copia/peatilla. Los profesores de inglés que revisaron su trabajo dijeron que carecía de pensamiento original y «alma». Suena alarmante, ¿verdad? Quizás, pero la verdad es más complicada de lo que sugieren los titulares sensacionalistas. Los hallazgos fueron menos sobre la descomposición del cerebro y más sobre los atajos mentales. Mostraron que la sobreventa en los LLM puede reducir el compromiso mental. Pero con un uso activo y reflexivo, se pueden evitar esos riesgos. Los investigadores también enfatizaron que, si bien el estudio planteó algunas preguntas interesantes para futuras investigaciones, también era demasiado pequeño y simple sacar conclusiones definitivas. La muerte del pensamiento crítico? Si bien los hallazgos (que aún no se han revisado por pares) ciertamente requieren una mayor investigación y una reflexión más profunda sobre cómo deberíamos usar esta herramienta en contextos educativos, profesionales y personales, tal vez lo que realmente podría estar pudriendo nuestros cerebros es los titulares de TLDR diseñados para hacer clics sobre la precisión. Los investigadores parecen compartir estas preocupaciones. Crearon un sitio web con una página de preguntas frecuentes donde instaron a los reporteros a no usar un lenguaje inexacto y sensacionalizar los hallazgos. Fuente: Preguntas frecuentes para «su cerebro en chatgpt: acumulación de deuda cognitiva Cuando se usa un asistente de IA para la tarea de redacción de ensayos» https://www.brainonllm.com/faq irónicamente, atribuyeron el «ruido» resultante a los reporteros que usan LLM para resumir el documento y agregado, «su retroalimentación humana es muy bienvenida, si usted lee el artículo o las partes de la misma. Enumeramos muy claramente tanto en el documento como en la página web «. There are two conclusions that we can safely draw from this study: More research into how LLMs should be used in educational settings is essential Students, reporters, and the public at large need to remain critical about the information we receive, whether from the media or generative AI Researchers from the Vrije Universiteit Amsterdam are concerned that, with our increasing reliance on LLMs, what might really be at risk is critical thinking, or our ability and willingness to question and change social normas. «Los estudiantes pueden tener menos probabilidades de llevar a cabo procesos de búsqueda extensos o integrales en sí mismos, porque difieren al tono autorizado e informado de la producción de Genai. Es menos probable que cuestionen, o incluso identifiquen, las perspectivas no declaradas subyacentes a la producción, sin considerar cuyas perspectivas están siendo pasadas y las supuestas de otorgadas a favor informadas». Estos riesgos apuntan a un problema más profundo en la IA. Cuando tomamos sus salidas al valor nominal, podemos pasar por alto sesgos integrados y suposiciones sin resolver. Abordar esto requiere no solo soluciones técnicas, sino una reflexión crítica sobre lo que queremos decir con sesgo en primer lugar. Estos problemas son fundamentales para el trabajo de Natasha Govender-Ropert, jefe de IA para delitos financieros en Rabobank. Su papel se centra en construir una IA responsable y confiable al desarrayar el sesgo. Pero como señaló al fundador de TNW, Boris Veldhuijzen, Van Zanten en «Kia’s Next Big Drive», el sesgo es un término subjetivo y debe definirse para cada individuo y cada empresa. «El sesgo no tiene una definición consistente. Lo que considero sesgado o imparcial puede ser diferente a otra persona. Esto es algo que nosotros, como humanos y como individuos, necesitamos decidir. Necesitamos elegir y decir que este es el estándar de principios que aplicaremos al mirar nuestros datos», dijo Govender-Ropert. Las normas y prejuicios sociales no son fijos sino siempre cambiantes. A medida que la sociedad evoluciona, los datos históricos en los que capacitamos a nuestros LLM no lo hacen. Necesitamos seguir siendo críticos y desafiar la información que recibimos, ya sea de nuestros compañeros humanos o nuestras máquinas, para construir una sociedad más justa y equitativa.

Deja una respuesta