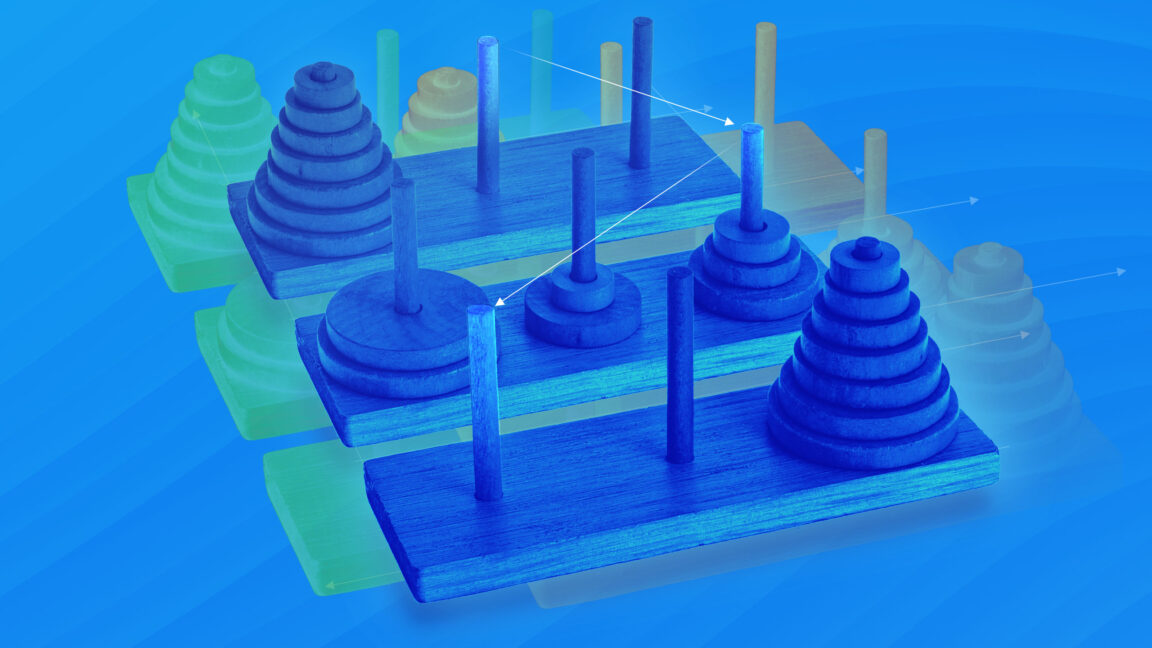

En un artículo reciente, Benj Edwards de Ars Technica exploró algunas de las limitaciones de los modelos de razonamiento entrenados con aprendizaje de refuerzo. Por ejemplo, un estudio «reveló inconsistencias desconcertantes en cómo fallan los modelos. El soneto Claude 3.7 podría realizar hasta 100 movimientos correctos en la Torre de Hanoi, pero falló después de solo cinco movimientos en un rompecabezas de cruce de río, a pesar de este último que requiere menos movimientos totales». Conclusión: el aprendizaje de refuerzo hizo que los agentes posibles una de las aplicaciones más discutidas para LLM en 2023 fue crear chatbots que entienden los documentos internos de una empresa. El enfoque convencional de este problema se llamaba RAG: Short para la generación aumentada de recuperación. Cuando el usuario hace una pregunta, un sistema RAG realiza una búsqueda basada en palabras clave o vectores para recuperar los documentos más relevantes. Luego inserta estos documentos en la ventana de contexto de un LLM antes de generar una respuesta. Los sistemas de trapo pueden ser demostraciones convincentes. Pero tienden a no funcionar muy bien en la práctica porque una sola búsqueda a menudo no puede surgir los documentos más relevantes. Hoy en día, es posible desarrollar sistemas de recuperación de información mucho mejores al permitir que el modelo mismo elija consultas de búsqueda. Si la primera búsqueda no extrae los documentos correctos, el modelo puede revisar la consulta e intentarlo nuevamente. Un modelo puede realizar cinco, 20 o incluso 100 búsquedas antes de proporcionar una respuesta. Pero este enfoque solo funciona si un modelo es «agente», si puede permanecer en la tarea en múltiples rondas de búsqueda y análisis. Los LLM fueron terribles en esto antes de 2024, como lo demostraron los ejemplos de AutoGpt y Babyagi. Los modelos de hoy en día son mucho mejores, lo que permite que los sistemas modernos de estilo trapo produzcan mejores resultados con menos andamios. Puede pensar en las herramientas de «investigación profunda» de Operai y otros como sistemas de trapo muy poderosos que se hacen posible por el razonamiento de contexto a largo plazo. El mismo punto se aplica a las otras aplicaciones de agente que mencioné al comienzo del artículo, como agentes de codificación y uso de computadora. Lo que estos sistemas tienen en común es una capacidad para el razonamiento iterado. Piensan, toman medidas, piensan en el resultado, toman otra acción, etc. Timothy B. Lee estuvo en el personal de ARS Technica de 2017 a 2021. Hoy, escribe Entender AI, un boletín que explora cómo funciona la IA y cómo está cambiando nuestro mundo. Puedes suscribirte aquí.

Deja una respuesta