La actualización de primavera de OpenAI del 13 de mayo trajo tres anuncios importantes de la compañía de IA: Un nuevo modelo insignia de IA llamado GPT-4o. Una aplicación ChatGPT de escritorio para macOS. Los usuarios de ChatGPT que no pagan una suscripción ahora pueden acceder a más funciones de forma gratuita. Los próximos cambios en ChatGPT «brindan inteligencia de nivel GPT-4 a todos, incluidos nuestros usuarios gratuitos», dijo la directora de tecnología de OpenAI, Mira Murati, durante la transmisión en vivo. Mira Murati, CTO de OpenAI, habla en una transmisión en vivo el 13 de mayo. Imagen: Captura de pantalla de TechRepublic GPT-4o mejora las capacidades de voz y video de GPT-4 Turbo Murati dijo que el próximo modelo insignia de OpenAI, GPT-4o, es «más rápido» y «mejora sus capacidades en todo el mundo». texto, visión y audio” en comparación con GPT-4. La «o» significa «omni». En cambio, GPT-4o responde más rápido que su predecesor GPT-4 Turbo y ha aumentado su dominio de idiomas, video y audio distintos del inglés. GPT-4o será 2 veces más rápido, 50% más barato y tendrá límites de velocidad 5 veces más altos que GPT-4 Turbo, dijo Murati. El director ejecutivo de OpenAI, Sam Altman, dijo hoy en X que GPT-4o es «nativamente multimodal», lo que significa que puede cambiar más rápido entre análisis de voz, texto y video. Se podrá acceder a GPT-4o de forma gratuita dentro de ChatGPT y se implementará durante las próximas semanas para los usuarios de todo el mundo. Los usuarios de ChatGPT Plus y Team podrán usar GPT-4o primero, mientras que la disponibilidad para los usuarios empresariales «llegará pronto», dijo Open AI. Los usuarios pagos de ChatGPT tendrán hasta cinco veces los límites de capacidad. GPT-4o también estará disponible en la API ChatGPT. Más sobre innovación La demostración de las capacidades de voz de GPT-4o en la aplicación ChatGPT en la transmisión en vivo sonó bastante natural, incluyendo varios ejemplos de cómo el modelo responderá sin problemas cuando sea interrumpido. A ChatGPT a veces le costaba distinguir qué imágenes se suponía que debía estar mirando, pero su capacidad de respuesta era notable. La compañía señaló que no lanzaría GPT-5, el rumoreado modelo de próxima generación, durante la actualización de primavera. Murati dijo que puede haber más noticias sobre los próximos lanzamientos “pronto”. Las consideraciones de seguridad en torno a GPT-4o OpenAI aseguraron a las personas que GPT-4o tiene «nuevos sistemas de seguridad para proporcionar barreras de seguridad en las salidas de voz», además de una extensa capacitación posterior y filtrado de los datos de capacitación para evitar que ChatGPT diga algo inapropiado o inseguro. GPT-4o se construyó de acuerdo con el marco de preparación interno y los compromisos voluntarios de OpenAI. Más de 70 investigadores de seguridad externos formaron un equipo rojo con GPT-4o antes de su lanzamiento. VER: Organizaciones de todo el mundo adoptan estándares como Credenciales de contenido para intentar reducir la información errónea y los deepfakes creados con IA. (TechRepublic) La nueva aplicación de escritorio ChatGPT llega a macOS Los usuarios de MacOS pronto podrán descargar una aplicación de escritorio ChatGPT. Los usuarios de ChatGPT Plus pueden acceder a la aplicación de escritorio hoy, mientras que otros usuarios gratuitos y de pago pueden esperar obtener acceso a ella «en las próximas semanas», dijo OpenAI. Esta interfaz de usuario para la aplicación de escritorio ChatGPT para macOS muestra ChatGPT escuchando mientras un usuario trabaja en el código. Imagen: Interfaz de usuario actualizada de OpenAI Simultáneamente con la nueva aplicación de escritorio ChatGPT, las aplicaciones ChatGPT y la versión de escritorio recibirán una interfaz de usuario nueva y más limpia destinada a mejorar la facilidad de uso. La interfaz de usuario actualizada para ChatGPT en un navegador cambia la posición del menú de configuración del usuario y limpia parte de la iconografía. Tenga en cuenta la adición de un lugar para adjuntar archivos dentro de la barra de mensajes. Imagen: OpenAI GPT Store y otras capacidades ahora abiertas para los usuarios de ChatGPT de forma gratuita. A partir del 13 de mayo, los usuarios de ChatGPT verán la siguiente implementación para las personas que no se suscriben a planes pagos: Use GPT-4 en lugar de GPT-3.5. GPT-4o puede extraer datos tanto del modelo ChatGPT como de la web. ChatGPT puede analizar datos en gráficos y crear nuevos gráficos. ChatGPT puede chatear sobre fotos cargadas por el usuario. Los usuarios del nivel gratuito pueden cargar archivos de texto que ChatGPT luego puede resumir, analizar o crear contenido nuevo. Los usuarios de la capa gratuita pueden explorar y utilizar GPT en la Tienda GPT. Los usuarios del nivel gratuito pueden aprovechar la función Memoria de ChatGPT, que permite al modelo recordar conversaciones anteriores con el mismo usuario. TechRepublic cubrió la actualización de primavera de OpenAI de forma remota.

Etiqueta: chatear Página 1 de 3

El motor de búsqueda de Google prácticamente ha dominado el panorama desde sus inicios hace tantos años. Dudamos que sean destronados pronto, pero OpenAI podría hacer que Google se detenga. Un informe reciente de Reuters ha revelado que OpenAI podría lanzar su competidor de Búsqueda de Google la próxima semana. Ahora, a principios de mes, hubo un informe de que OpenAI estaba planeando su propio motor de búsqueda impulsado por ChatGPT. Ahora bien, este informe sugiere que el lanzamiento podría tener lugar el 13 de mayo. Esto es muy interesante porque Google I/O se lleva a cabo el 14 de mayo, por lo que el anuncio de OpenAI tiene el potencial de eclipsar el evento de Google. La compañía se negó a comentar sobre el informe, por lo que tendremos que esperar y ver si tiene éxito. OpenAI no es ajeno a la búsqueda. La compañía se ha asociado con Microsoft para integrar su tecnología de inteligencia artificial en Bing, pero este motor de búsqueda podría ser un esfuerzo independiente. Google ya está probando la integración de la IA en la búsqueda, por lo que será interesante ver cómo les irá a los esfuerzos de OpenAI. Una de las ventajas de la búsqueda con IA generativa es que los usuarios no necesitan perder tiempo revisando sitios web para encontrar lo que necesitan. Las capacidades de rastreo web de Google fueron lo que les dio una ventaja sobre sus competidores a lo largo de los años, pero el uso de la IA podría desafiar eso. Tómelo con cautela, pero vuelva a consultarnos el lunes para conocer más detalles.

Anthropic presentó Claude Team, su plan empresarial para Claude AI, el 1 de mayo. Claude Team llega en un momento interesante en el que las empresas luchan por encontrar usos generadores de dinero para la IA generativa. Con Claude Team, Anthropic incluye IA generativa que podría usarse para iterar proyectos, analizar documentos o explorar posibles aumentos de productividad, además de herramientas administrativas adecuadas para las empresas. Además, ahora hay una aplicación Claude disponible para iOS. «El plan Claude Team y la aplicación iOS son parte de un cambio de paradigma más amplio en cómo las empresas utilizan y colaboran con la IA», dijo Scott White, líder de producto de Anthropic, en un correo electrónico a TechRepublic. «Con un mayor uso, controles administrativos y acceso a la avanzada familia de modelos Claude 3, las empresas ahora pueden ofrecer a cada empleado las capacidades de Claude». Los productos de Anthropic con tecnología Claude están disponibles en todo el mundo. ¿Qué es el equipo Claude de Anthropic? Claude Team de Anthropic es un plan de suscripción que permite a los administradores y equipos empresariales acceder a la IA generativa de Claude 3 y, en el futuro, podrá conectarla a CRM. Claude Team está destinado a proporcionar a las empresas un banco de trabajo de IA generativa. Imagen: Anthropic Claude Team agrega lo siguiente a las ofertas habituales de Claude: Mayor uso (hasta una ventana de contexto de 200 000), lo que significa que Claude puede tener más chats y digerir documentos más largos que en el plan Pro. Acceso a los tres tamaños de los modelos Claude 3: el Opus grande, el Sonnet mediano y el Haiku pequeño. Herramientas de administración para gestionar usuarios y facturación. Todas las funciones Pro, incluida la alta prioridad durante los momentos de mucho tráfico. Anthropic planea agregar pronto integraciones con repositorios de datos como CRM y bases de código. Otras actualizaciones que se espera que lleguen a Claude Team en el futuro incluyen “citas de fuentes confiables para verificar las afirmaciones generadas por IA” y la capacidad de iterar con otras personas en proyectos generados por IA. El analista de Gartner, Arun Chandrasekaran, señaló en un correo electrónico a TechRepublic que Anthropic está tratando de dirigirse a «usuarios comerciales que desean una mejor previsibilidad, respuestas de mayor calidad y una capacidad de respuesta más rápida» con Claude Team. Señaló el momento del lanzamiento: unos meses después de que el equipo ChatGPT de OpenAI llegara al mercado. VER: Adobe agregó su Firefly AI y sus credenciales de contenido a la lista de objetivos para una recompensa por errores privada. (TechRepublic) ¿Cuánto cuesta una suscripción a Claude Team? Una suscripción a Claude Team cuesta $30 por mes para un mínimo de cinco usuarios. Puedes registrarte en Claude Team en la página de inicio de Claude. Más cobertura de IA de lectura obligada La aplicación Claude ahora está disponible en iOS La aplicación Claude en iOS estuvo disponible en la App Store de Apple a partir del 1 de mayo. La aplicación permite el acceso móvil al chatbot gratuito, así como a los planes Claude Pro y Team. En la aplicación, Claude puede interpretar fotografías, documentos o archivos. Si inicias sesión en varios dispositivos, Claude iOS podrá continuar con tus chats donde los dejaste en otro dispositivo. La aplicación Claude se puede utilizar para hacer preguntas y generar contenido con el chatbot de IA. Imagen: Las empresas de Anthropic Generative AI compiten por casos de uso empresarial Como Microsoft es para OpenAI, Amazon es para Anthropic: Amazon donó 4 mil millones de dólares a Anthropic durante el invierno de 2023-2024, y Google financió a Anthropic con 2 mil millones de dólares a partir de octubre pasado. Todos los hiperescaladores que trabajan en IA empresarial han promocionado con éxito la IA generativa como una nueva idea, pero monetizar los productos de IA generativa es difícil. «AWS y Google probablemente vean a Anthropic como su mejor opción para competir con ChatGPT y Copilot y quitarles participación de mercado», dijo Gordon McKenna, vicepresidente de evangelización de la nube y alianzas de la empresa de gestión de servicios de TI Ensono, en un correo electrónico a TechRepublic. «El momento de este anuncio probablemente se coordinó con los recientes anuncios de ganancias de AWS y Google y tenía como objetivo reforzar su presencia en este mercado». Mientras que Claude Team cuesta $ 30 por mes por persona, el equipo ChatGPT de OpenAI cuesta $ 25 por mes por persona anualmente o $ 30 por mes por persona mensualmente. El número mínimo de usuarios del equipo ChatGPT es dos, mientras que el equipo Claude tiene un mínimo de cinco. «Él [Claude Team] Definitivamente indica una presión competitiva sobre el negocio de suscripción móvil de ChatGPT y también pondrá la capacidad de juzgar la eficacia y el rendimiento del modelo en manos de los usuarios diarios”, escribió Ricardo Madan, vicepresidente senior de la agencia de personal TEKsystems Global Services, en una declaración a TechRepublic por correo electrónico. . “Claude FM de Anthropic [foundation model] ya se ha utilizado a nivel empresarial a través del registro Model Garden de Google Cloud y es uno [of] Los principales FM de terceros de AWS se agregaron a su plataforma Bedrock”, escribió Madan. «Sin embargo, Anthropic esencialmente y eventualmente disminuirá la necesidad de cualquier empresa de usarlos como una herramienta de terceros (a través de los hiperescaladores) ahora que están plantando una bandera de acceso directo en el juego del modelo corporativo».

Una investigación realizada en 2023 por la iniciativa Grandes modelos europeos de IA encontró que el 73% de los modelos básicos de IA desde 2017 eran de EE. UU. y el 15% de China. Advirtió que a Alemania le faltaba un “cambio de paradigma” de IA que podría “poner en peligro la soberanía digital de Europa”. El dominio del modelo de base de IA de EE. UU. y China está generando preocupaciones similares en los países de APAC. Existen algunos temores de que esto pueda afectar a los ciudadanos y empresas de la región en áreas que incluyen la seguridad y la gobernanza de los datos, así como el riesgo geopolítico o de la cadena de suministro. Estados-nación como Singapur, Japón y Australia están respondiendo desarrollando o considerando modelos de bases soberanas de IA. Por ejemplo, el organismo científico nacional de Australia, la Organización de Investigación Científica e Industrial de la Commonwealth, publicó recientemente un documento preguntando si Australia debería invertir en sus propios modelos de fundaciones. Las empresas podrían beneficiarse de modelos que sean más sensibles a los matices de su cultura o idioma y prometan mantener los datos seguros y conformes dentro de las fronteras de su propio país. La creación de modelos soberanos de IA también podría ayudar a desarrollar ecosistemas locales de computación y habilidades de IA. Descargue estos 10 casos de uso principales de inteligencia artificial de TechRepublic Premium El dominio de la IA de EE. UU. y China estimula el interés en la IA soberana El dominio de los EE. UU. en IA continuó durante 2023. El informe del índice de IA de Stanford publicado en 2024 encontró que se habían lanzado 61 modelos notables en los EE. UU. en 2023; esto estuvo por delante de los 15 nuevos modelos de China y de Francia, el mayor contribuyente de Europa con ocho modelos (Figura A). La Unión Europea en su conjunto produjo 21 modelos notables, mientras que Singapur, con tres modelos, fue el único otro productor de modelos lingüísticos grandes notables en APAC. Figura A Estados Unidos está superando a China y otros países en el desarrollo de modelos de IA. Imagen: Epoch EE. UU. y China están creando muchos de los LLM más populares de la actualidad. Muchos LLM utilizados ampliamente en APAC se originan en los EE. UU., incluidos ChatGPT 3.5 y GPT-4 de OpenAI, Llama de Meta, Google Gemini, Claude de Anthropic y Copilot de Microsoft, así como open- Modelos fuente como BERT. VER: Cómo ve el gobierno australiano que la IA acelera la productividad China es el mayor desafío para los EE. UU., y algunas empresas utilizan Llama 1 de código abierto para capacitar a nuevos LLM. Los modelos notables de China incluyen Ernie Bot estilo ChatGPT de Baidu, que ahora tiene 200 millones de usuarios, y un LLM desarrollado por Alibaba adaptado a los idiomas del sudeste asiático llamado SeaLLM. Los líderes de la industria centran el debate en las capacidades soberanas de la IA. Las partes interesadas clave de la industria están abogando por una IA más soberana. El director ejecutivo de NVIDIA, Jensen Huang, dijo durante una reciente Cumbre Mundial de Gobiernos que cada país necesitaba «ser dueño de la producción de su propia inteligencia», recomendando que «codifiquen su idioma, datos y cultura» en su propio LLM. Como informó Business Standard, el director ejecutivo de IBM, Arvind Krishna, dijo: «Todos los países deberían tener capacidad soberana en materia de inteligencia artificial, incluidos grandes modelos de lenguaje e IA generativa», para «utilizarla para fines en los que el resto del mundo no quiere invertir». en, o que tal vez no quiera exponer a otros «. Más cobertura de IA de lectura obligada La concentración del mercado de Foundation LLM tiene riesgos para las empresas Muchas empresas en APAC están personalizando los modelos de IA existentes y implementando medidas para proteger la propiedad intelectual de ser absorbida por modelos de capacitación en el extranjero. Sin embargo, la falta de modelos soberanos de IA y el dominio de algunos Estados-nación exponen a las empresas a riesgos. En el documento de CSIRO publicado en marzo de 2024, se señalaron factores clave que Australia debería sopesar al considerar si construir su propio modelo soberano de IA; Estos factores también se aplican a otros países de la región APAC. Mercados y precios competitivos: las empresas pueden terminar dependiendo de un pequeño número de proveedores de modelos de IA dominantes en mercados extraterritoriales, con el poder de fijar precios para cosas como el acceso a API. En abril de 2024, la Autoridad de Mercados y Competencia del Reino Unido señaló “preocupaciones reales” sobre una red interconectada ya existente de 90 asociaciones e inversiones estratégicas que involucran a las mismas empresas, a saber, Google, Apple, Microsoft, Meta, Amazon y NVIDIA. Fiabilidad y estabilidad: la dependencia de LLM de propiedad privada expone a las empresas a cambios inesperados. Dos ejemplos son el despido y reinstalación del director ejecutivo Sam Altman por parte de OpenAI o la adquisición de Twitter por parte de Elon Musk, que provocó que muchos usuarios institucionales cambiaran sus estrategias digitales. Relevancia y sensibilidad cultural: los países asiáticos están viendo la importancia de tener LLM construidos a partir de conjuntos de datos locales. Esto garantizaría que los resultados integren normas culturales y matices lingüísticos o brinden asesoramiento correcto sobre las leyes, requisitos y procesos locales. Confidencialidad, privacidad y seguridad de la información: todavía existen preocupaciones sobre la introducción de datos privados o sensibles en modelos de IA en el extranjero; esto está impidiendo que las instituciones del sector público adopten plenamente los LLM. Sin una protección adecuada de los datos, la propiedad intelectual de una organización podría estar en riesgo. Riesgos geopolíticos: siempre existe el riesgo de que un evento geopolítico importante pueda poner en riesgo a las organizaciones o agencias si dependen de modelos de IA extraterritoriales. El CSIRO añadió que es posible que se utilicen para influir en la opinión pública de otras naciones soberanas. Ética y moderación de contenidos: la ética puede ser importante para las organizaciones privadas que utilizan diferentes modelos. Por ejemplo, OpenAI es objeto de varias demandas por los datos de capacitación utilizados para construir sus modelos, lo que deja a las organizaciones potencialmente en riesgo si los usan. El riesgo soberano debe equilibrarse con las oportunidades para las empresas El CSIRO dijo que si bien la IA generativa representa importantes oportunidades para las empresas, “la dependencia de modelos básicos de IA fabricados y operados en el extranjero (o corporaciones tecnológicas privadas) también crea riesgos de capacidad soberana y preocupaciones sobre la equidad y mercados abiertos para el desarrollo de productos”, algo que los países y las empresas tratarían de evitar. Países de Asia y el Pacífico que trabajan en sus propios LLM personalizados. Los países de APAC están considerando la falta de capacidades soberanas de IA. Singapur, Japón y Australia ya están invitando a debatir o implementar políticas para comenzar el proceso de reequilibrio de la hegemonía de la IA que existe en el mercado mundial de modelos de bases. Singapur Singapur inició un programa de 51 millones de dólares (80 millones de dólares australianos), denominado Programa Nacional Multimodal LLM (NMLP), para desarrollar un modelo base con contexto regional que pueda comprender las características lingüísticas únicas y el entorno multilingüe. La Autoridad de Desarrollo de Medios de Infocomm dijo que se basaría en los primeros resultados del modelo SEA-LION (Lenguajes del Sudeste Asiático en una Red) de AI Singapur, un LLM de código abierto de menor escala que es más representativo del contexto cultural y los idiomas de la región. Cuando se entregó, la IMDA dijo que sería el LLM regional inaugural del sudeste asiático. Se espera que los modelos y casos de uso estén disponibles a partir del proyecto en los próximos dos años. Japón El Partido Liberal Democrático Japonés recomendó a principios de 2023 que la nación “construya y fortalezca capacidades de desarrollo de modelos de IA, incluidos los modelos básicos”, destacando el deseo de habilidades y experiencia, conjuntos de datos y recursos computacionales para un ecosistema de IA. El gobierno señaló una preocupación particular con los recursos informáticos. En septiembre de 2023, se reveló que Japón se está asociando con empresas como NEC, Fujitsu y SoftBank para desarrollar sus propios LLM como ChatGPT, que se adaptarían a las complejidades del idioma y la cultura japonesa. Australia El documento de CSIRO analizó una serie de medidas de mitigación que podrían respaldar una posición australiana fortalecida en el orden global de la IA. Estos incluyeron la construcción de la infraestructura informática necesaria asegurando chips aceleradores de IA de alto rendimiento, o GPU, en medio de una alta demanda global. El CSIRO también planteó la posibilidad de identificar, validar y poner a disposición conjuntos de datos para entrenar modelos básicos de IA y aumentar las habilidades de IA de la fuerza laboral a través de la capacitación, la educación y un mejor acceso a los grupos de talentos. VER: Cómo el CSIRO está impulsando la inversión en IA en Australia a través de la competencia Además, el CSIRO preguntó si Australia podría negociar colaboraciones internacionales bilaterales o multilaterales para compartir experiencia y recursos en IA o invertir en la construcción, el ajuste y la aplicación de modelos soberanos de bases de IA para mejorar. funciones gubernamentales, entre otras medidas.

TL;DR: Descubra cómo las herramientas de inteligencia artificial orientadas al consumidor pueden ayudar a su empresa en el título electrónico avanzado completo ChatGPT y Gemini AI de 2024, ahora por solo $ 29,99. Según un estudio reciente, el 35% de las empresas de todo el mundo ya utilizan la IA, mientras que el 50% planea utilizarla de alguna manera en 2024. Las empresas utilizan la IA para automatizar tareas tediosas, crear contenido, inspirarse para campañas de marketing, gestionar las relaciones con los clientes y mucho más. No es necesario que incorpores la IA a tu negocio, pero puede ayudarte en más formas de las que imaginas. Con el título electrónico avanzado completo de ChatGPT y Gemini AI de 2024, obtendrá un desglose completo de algunas de las herramientas de inteligencia artificial más asequibles y orientadas al consumidor de la actualidad para ayudarlo a descubrir cómo podrían tener sentido para su negocio. Lo que aprenderá Este curso de 10 horas es impartido por Eduonix Learning Solutions (calificación de instructor de 4.0/5 estrellas), líder en educación en línea. Le ayudará a comprender la importancia de la IA generativa y a profundizar en una serie de herramientas de IA, incluidas ChatGPT, Gemini AI, GPT 3.5, GPT 4, Bard, DALL-E 2 y más. Aprenderá cómo aprovechar estas herramientas para impulsar la creatividad, mejorar la productividad y mucho más. A través de los cursos, obtendrás práctica con cada una de las herramientas, explorando las vastas posibilidades en la generación de texto, imágenes, video y audio. Comprenderá las técnicas y metodologías involucradas en la generación de contenido basada en IA y aprenderá cómo aprovechar adecuadamente los modelos para obtener los resultados deseados. Algunos de los proyectos que explorará incluyen marketing de contenidos con IA, generación de imágenes con IA para redes sociales y diseño web, audio y vídeo con IA para fines educativos e informativos, automatización de tareas y más. Vea lo que la IA puede hacer por su negocio. En este momento, puede obtener el título electrónico avanzado 2024 Complete ChatGPT y Gemini AI a la venta por solo $ 29,99 (precio regular: $ 790). Precios y disponibilidad sujetos a cambio.

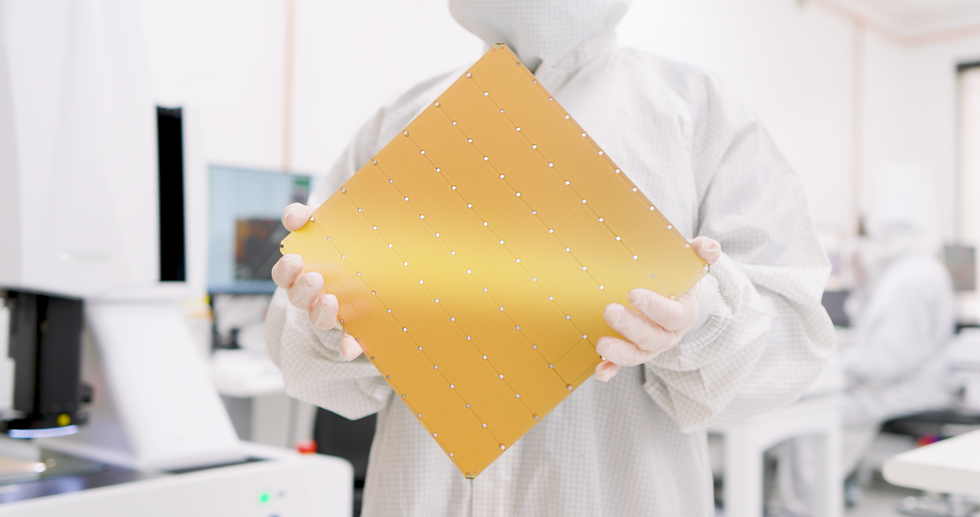

Cerebras, la empresa de supercomputadoras de inteligencia artificial de Sunnyvale, California, dice que su próxima generación de chips de inteligencia artificial en escala de oblea puede duplicar el rendimiento de la generación anterior y consumir la misma cantidad de energía. El Wafer Scale Engine 3 (WSE-3) contiene 4 billones de transistores, un aumento de más del 50 por ciento con respecto a la generación anterior gracias al uso de tecnología de fabricación de chips más nueva. La compañía dice que utilizará el WSE-3 en una nueva generación de computadoras con inteligencia artificial, que ahora se están instalando en un centro de datos en Dallas para formar una supercomputadora capaz de realizar 8 exaflops (8 mil millones de billones de operaciones de punto flotante por segundo). Por otra parte, Cerebras ha firmado un acuerdo de desarrollo conjunto con Qualcomm que tiene como objetivo aumentar diez veces una métrica de precio y rendimiento para la inferencia de IA. La compañía dice que el CS-3 puede entrenar modelos de redes neuronales con un tamaño de hasta 24 billones de parámetros, más de 10 veces el tamaño de los LLM más grandes de la actualidad. Con WSE-3, Cerebras puede mantener su pretensión de producir el chip individual más grande del mundo. De forma cuadrada y 21,5 centímetros de lado, utiliza casi una oblea entera de silicio de 300 milímetros para fabricar un chip. Los equipos de fabricación de chips suelen limitarse a producir matrices de silicio de no más de unos 800 milímetros cuadrados. Los fabricantes de chips han comenzado a escapar de ese límite mediante el uso de integración 3D y otras tecnologías de embalaje avanzadas. Integración 3D y otras tecnologías de embalaje avanzadas para combinar múltiples matrices. Pero incluso en estos sistemas, el número de transistores es de decenas de miles de millones. Como es habitual, un chip tan grande viene con algunos superlativos alucinantes. Transistores 4 billones de milímetros cuadrados de silicio 46.225 núcleos de IA 900.000 cálculos de IA 125 petaflops Memoria en el chip 44 gigabytes Ancho de banda de la memoria 21 petabytes Ancho de banda de la estructura de red 214 petabits Puede ver el efecto de la Ley de Moore en la sucesión de chips WSE. El primero, que debutó en 2019, se fabricó utilizando la tecnología de 16 nanómetros de TSMC. Para WSE-2, que llegó en 2021, Cerebras pasó al proceso de 7 nm de TSMC. WSE-3 está construido con la tecnología de 5 nm del gigante de la fundición. El número de transistores se ha más que triplicado desde el primer megachip. Mientras tanto, el uso que se les da también ha cambiado. Por ejemplo, el número de núcleos de IA en el chip se ha estabilizado significativamente, al igual que la cantidad de memoria y el ancho de banda interno. Sin embargo, la mejora del rendimiento en términos de operaciones de punto flotante por segundo (flops) ha superado todas las demás medidas. CS-3 y Condor Galaxy 3 La computadora construida alrededor del nuevo chip AI, el CS-3, está diseñada para entrenar nuevas generaciones de modelos de lenguaje gigantes, 10 veces más grandes que el GPT-4 de OpenAI y el Gemini de Google. La compañía dice que el CS-3 puede entrenar modelos de redes neuronales de hasta 24 billones de parámetros de tamaño, más de 10 veces el tamaño de los LLM más grandes de la actualidad, sin recurrir a un conjunto de trucos de software que necesitan otras computadoras. Según Cerebras, eso significa que el software necesario para entrenar un modelo de mil millones de parámetros en el CS-3 es tan sencillo como entrenar un modelo de mil millones de parámetros en GPU. Se pueden combinar hasta 2.048 sistemas, una configuración que permitiría entrenar el popular LLM Llama 70B desde cero en solo un día. Sin embargo, no se está preparando nada tan grande, dice la compañía. La primera supercomputadora basada en CS-3, Condor Galaxy 3 en Dallas, estará compuesta por 64 CS-3. Al igual que sus sistemas hermanos basados en CS-2, el G42 de Abu Dhabi es propietario del sistema. Junto con Condor Galaxy 1 y 2, esto forma una red de 16 exaflops. «La red Condor Galaxy existente ha entrenado algunos de los modelos de código abierto líderes en la industria, con decenas de miles de descargas», dijo Kiril Evtimov, CTO del grupo G42 en un comunicado de prensa. «Al duplicar la capacidad a 16 exaflops, esperamos ver la próxima ola de innovación que las supercomputadoras Condor Galaxy pueden permitir». Un acuerdo con Qualcomm Si bien las computadoras Cerebras están diseñadas para capacitación, el director ejecutivo de Cerebras, Andrew Feldman, dice que la inferencia, la ejecución de modelos de redes neuronales, es el límite real para la adopción de la IA. Según estimaciones de Cerebras, si cada persona en el planeta usara ChatGPT, costaría 1 billón de dólares al año, sin mencionar una cantidad abrumadora de energía procedente de combustibles fósiles. (Los costos operativos son proporcionales al tamaño del modelo de red neuronal y la cantidad de usuarios). Por eso, Cerebras y Qualcomm se han asociado con el objetivo de reducir el costo de la inferencia en un factor de 10. Cerebras dice que su solución implicará aplicar Técnicas de redes neuronales como la compresión de datos de peso y la escasez: la poda de conexiones innecesarias. Las redes entrenadas por Cerebras luego se ejecutarían eficientemente en el nuevo chip de inferencia de Qualcomm, el AI 100 Ultra, afirma la compañía. Artículos de su sitioArtículos relacionados en la Web

Source link

Después de demandar a OpenAI este mes, alegando que la empresa se ha vuelto demasiado cerrada, Elon Musk dice que publicará su respuesta de “búsqueda de la verdad” a ChatGPT, el chatbot Grok, para que cualquiera pueda descargarla y usarla. “Esta semana, @xAI abrirá el código fuente Grok”, escribió Musk hoy en su plataforma de redes sociales X. Eso sugiere que su empresa de inteligencia artificial, xAI, publicará el código completo de Grok y permitirá que cualquiera pueda usarlo o modificarlo. Por el contrario, OpenAI ofrece una versión de ChatGPT y el modelo de lenguaje detrás de él disponible para su uso de forma gratuita, pero mantiene su código privado. Musk había dicho poco anteriormente sobre el modelo de negocio de Grok o xAI, y el chatbot estuvo disponible solo para suscriptores Premium. a X. Después de haber acusado a sus cofundadores de OpenAI de incumplir una promesa de regalar la inteligencia artificial de la compañía a principios de este mes, Musk puede haber sentido que tenía que abrir su propio chatbot para demostrar que está comprometido con esa visión. OpenAI respondió a la pregunta de Musk. demanda la semana pasada al publicar mensajes de correo electrónico entre Musk y otros en los que parecía respaldar la idea de hacer que la tecnología de la compañía fuera más cerrada a medida que se volviera más poderosa. Musk finalmente invirtió más de 40 millones de dólares en OpenAI antes de separarse del proyecto en 2018. Cuando Musk anunció por primera vez que Grok estaba en desarrollo, prometió que tendría menos sesgo político que ChatGPT u otros modelos de IA, que él y otros tienen derechos. Las opiniones inclinadas han sido criticadas por ser demasiado liberales. Las pruebas realizadas por WIRED y otros demostraron rápidamente que, aunque Grok puede adoptar un estilo provocativo, no está muy sesgado en un sentido u otro, lo que tal vez revela el desafío de alinear los modelos de IA de manera consistente con un punto de vista particular. El abastecimiento abierto de Grok podría ayudar a Musk a generar interés en la IA de su empresa. Limitar el acceso de Grok solo a suscriptores pagos de X, una de las plataformas sociales globales más pequeñas, significa que aún no tiene la tracción de ChatGPT de OpenAI o Gemini de Google. El lanzamiento de Grok podría atraer a los desarrolladores a utilizar y desarrollar el modelo y, en última instancia, podría ayudarlo a llegar a más usuarios finales. Eso podría proporcionar a xAI datos que puede utilizar para mejorar su tecnología. La decisión de Musk de liberar a Grok lo ve alinearse con el enfoque de Meta hacia la IA generativa. Los modelos de código abierto de Meta, como Llama 2, se han vuelto populares entre los desarrolladores porque pueden personalizarse y adaptarse completamente a diferentes usos. Pero adoptar una estrategia similar podría arrastrar a Musk aún más a un creciente debate sobre los beneficios y riesgos de dar a cualquiera acceso a los modelos de IA más potentes. Muchos expertos en IA sostienen que los modelos de IA de código abierto tienen importantes beneficios, como una mayor transparencia y un mayor acceso. «Los modelos abiertos son más seguros y robustos, y es fantástico ver más opciones de empresas líderes en el espacio», dice Emad Mostaque, fundador de Stability AI, una empresa que construye varios modelos de IA de código abierto.

Source link

Temasek Holdings de Singapur está en conversaciones para invertir en OpenAI, la empresa de inteligencia artificial (IA) respaldada por Microsoft detrás de ChatGPT. Citando a dos personas familiarizadas con el asunto, el Financial Times informó el martes (5 de marzo) que los altos ejecutivos de Temasek se han reunido con el director ejecutivo de OpenAI, Sam Altman, varias veces durante los últimos meses. La empresa de inversión estatal inicialmente estaba interesada en invertir en el fondo de capital riesgo Hydrazine Capital de Altman, sin embargo, las conversaciones más recientes incluyeron a la empresa de inteligencia artificial. El informe añade que las conversaciones fueron preliminares pero continúan, sin acuerdo sobre el tamaño de ninguna inversión. OpenAI no respondió de inmediato a las solicitudes de comentarios de Vulcan Post, mientras que Temasek se negó a comentar sobre el informe. Las negociaciones con Temasek son las primeras desde que surgieron informes el mes pasado de que Altman buscaba recaudar entre 5 y 7 billones de dólares para lanzar un negocio de semiconductores y reducir la dependencia de OpenAI de los chips de IA fabricados por Nvidia. “Construir una infraestructura de IA a gran escala y una cadena de suministro resiliente es crucial para la competitividad económica”, publicó Altman en X el mes pasado. A pesar de que sus ingresos superaron los 2.000 millones de dólares anuales en diciembre, la empresa sigue generando pérdidas debido a los enormes costos de construcción y funcionamiento de sus modelos. Creemos que el mundo necesita más infraestructura de IA (capacidad fabulosa, energía, centros de datos, etc.) de la que la gente planea construir actualmente. La construcción de una infraestructura de IA a gran escala y una cadena de suministro resiliente es crucial para la competitividad económica. Openai intentará ayudar !— Sam Altman (@sama) 7 de febrero de 2024 Altman también ha hablado de recaudación de fondos con inversores con mucho dinero en Oriente Medio y Asia, incluido el jeque Tahnoon bin Zayed al-Nahyan, una de las figuras más ricas e influyentes de Abu Dabi, y SoftBank. fundador Masayoshi Son. Actualmente, OpenAI cuenta con el respaldo de 13 mil millones de dólares de Microsoft, su mayor inversor, así como de varios grupos de capital de riesgo, incluidos Thrive Capital, Sequoia Capital, Tiger Global Management y Andreessen Horowitz. En los últimos meses, OpenAI completó un acuerdo que permite a los empleados vender participaciones en la empresa. La oferta pública le dio a OpenAI una valoración de 86 mil millones de dólares (o aproximadamente tres veces su valor en abril pasado), lo que la convierte en una de las startups más valiosas del mundo. La inversión en IA de Singapur Con una cartera valorada en 284 mil millones de dólares, la IA es actualmente un foco clave para las inversiones de Temasek, según la dirección del fondo. Sus inversiones existentes en el espacio incluyen la empresa de tecnología legal con sede en el Reino Unido Robin AI, la empresa surcoreana de chips de IA sin fábrica Rebellions y el diseñador de chips de IA generativa con sede en Silicon Valley d-Matrix. Tras el auge de la IA en los últimos años, las nuevas empresas de IA han experimentado un aumento notable en la financiación, incluso en Singapur. En toda la ciudad-estado, el sector fue testigo de una importante inyección de fondos en 2023, que ascendió a 481,21 millones de dólares en 24 acuerdos. Para hacer avanzar aún más el ecosistema de IA de Singapur, el primer ministro Lee Hsien Loong y Jacqueline Poh, directora general de la Junta de Desarrollo Económico de Singapur (EDB), se reunieron a principios de diciembre con el director ejecutivo de NVIDIA, Jensen Huang, para discutir posibles «grandes inversiones» en IA aquí. Singapur siempre ha abrazado la innovación y su compromiso inquebrantable con el avance tecnológico ha solidificado su posición como centro global de negocios e innovación, pero el viaje no siempre ha sido fácil. Durante la anterior corrida alcista de las criptomonedas, las empresas de inversión de Singapur, incluidas GIC y Temasek, invirtieron en varias empresas de criptomonedas, algunas de las cuales fracasaron. Con su cambio de enfoque, aún está por verse si el actual auge de la IA es simplemente una tendencia pasajera. Crédito de la imagen destacada: Munshi Ahmed vía Bloomberg