El domingo, nuestro presidente reflexivo y reservado volvió a publicar en su sitio social de la verdad, un video generado por la inteligencia artificial que mostró falsamente al ex presidente Obama arrestado y encarcelado. Hay aquellos entre ustedes que piensan que esto es de gran humor; aquellos de ustedes que lo encuentran tan aburrido como ofensivo; Y aquellos de ustedes que no saben el pantano mental que es la verdad social. Independientemente del campamento en el que te encuentres, el video cruza toda la demografía al ser esperado: solo otro truco loco de Trump en un ciclo repetitivo de división y diversión tan frecuente que hace que el Día de la Marmota parezca fresco. Epstein ¿Quién? Pero hay tres razones por las cuales vale la pena señalar este video en particular, no hecho por el presidente sino que se amplificó a miles, y tal vez valga la pena temer. Primero, es racista. En él, Obama es arrancado de una silla en la Oficina Oval y forzado sobre sus rodillas, casi inclinándose, a una risa Trump. Esas imágenes no son difíciles de interpretar: el hombre negro más estimado de Estados Unidos, que recientemente advirtió que estamos al borde de perder la democracia, obligado a someterse ante nuestro líder. El video se produce cuando Trump afirma que Tulsi Gabbard, director de inteligencia nacional, ha descubierto una «conspiración traidora en 2016» en la que los altos funcionarios de Obama coludieron con Rusia para interrumpir las elecciones. Los demócratas dicen que la afirmación es errónea en el mejor de los casos. Si está inclinado a darle a Trump el beneficio de la duda, justo antes de que esta escena de Obama se vea obligada a arrodillarse, un meme de Pepe the Frog, una imagen icónica de la extrema derecha y la supremacía blanca, se destaca en la pantalla. No sutil. Pero también, no la primera vez que el racismo venga directamente de la Casa Blanca. El lunes, el reverendo Amos Brown, pastor de la tercera Iglesia Bautista de San Francisco y estudiante de Martin Luther King Jr., me recordó que no hace mucho tiempo, el entonces presidente Woodrow Wilson proyectó la película Pro-KKK «El nacimiento de una nación» en la mansión ejecutiva. Fue la primera proyección de películas que se realizó allí, y su punto de vista anti-negro provocó controversia y protestas. Eso se debió en gran parte a una verdad que Hollywood conoce bien: la ficción tiene un gran poder para influir en las mentes. Brown ve similitudes directas en cómo Wilson amplificó el anti-Blackness ficticio en ese momento, y cómo Trump lo está haciendo ahora, tanto para obtener ganancias políticas. «El Sr. Trump debería darse cuenta de que Obama no le ha hecho nada. Pero solo la idea, la idea de que una persona negra sea humana, es una amenaza para él y sus seguidores», me dijo Brown. Brown dijo que está rezando para que el presidente «detenga esta intolerancia» y vea el error de sus caminos. Rezaré a los grandes dioses que le den al reverendo buena suerte. Pero, en el plano terrenal, Brown dijo que «cuanto más cambian las cosas, más siguen siendo las mismas». Trump cortejó el voto negro y tiene sus partidarios entre personas de todos los colores y etnias, pero también ha jugado con tropos racistas para el éxito político, desde el miedo en el Central Park Five, ahora conocido como los exonerados, hace décadas, hasta el miedo a los inmigrantes negros que comen gatos y perros en Ohio durante las recientes elecciones. Es un viejo libro de jugadas, porque funciona. Repostar la imagen de Obama de rodillas da miedo porque es un duro recordatorio de que el racismo ya no es una corriente subterránea en nuestra sociedad, si alguna vez lo fue. Es un motivador y un poder para ser manejado abiertamente, tal como lo hizo Wilson en 1915. Pero las diferencias en los medios de comunicación en el pasado son lo que debería aumentar nuestro segundo miedo en torno a este video. Una película ficticia es una cosa. Un video generado por IA que para muchas personas parece representar la realidad es un nivel completamente nuevo de, bueno, realidad. El miedo a los profundos en la política no es nuevo. Es un problema global, y para ser justos, esta no es la primera vez (con mucho) Trump u otros políticos han usado Deepfakes. Trump el año pasado volvió a publicar una imagen de Taylor Swift respaldándolo (que nunca sucedió). También el año pasado, durante las elecciones y la altura del Bromance de Elon Musk-Trump, el multimillonario publicó una foto falsa del retador político Kamala Harris vestido con lo que parecía un uniforme militar comunista. El propio Trump no ha sido inmune. En 2023, Eliot Higgins, el fundador de la salida de investigación Bellingcat, dijo que estaba jugando con una herramienta de inteligencia artificial y creó imágenes de Trump arrestadas, nunca pensando que se volvería viral (especialmente porque una imagen le dio a Trump tres piernas). Por supuesto, lo hizo, y millones de personas miraron estas imágenes falsas, al menos algunas asumieron que eran reales. La lista de ejemplos políticos de Deepfake es larga y siniestra. Lo que nos lleva a la tercera razón por la cual el último uso de Trump de uno es inquietante. Claramente ve la efectividad de manipular la raza y la realidad para aumentar su propio poder y promover su propia agenda. Obama de rodillas golpea un acorde demasiado cerca de la imagen del senador latino Alex Padilla llevado al piso por las autoridades federales hace unas semanas durante una conferencia de prensa. Tiene un parecido escalofriante con las miles de imágenes que nos inundan diariamente de los inmigrantes que son derribados y detenidos por oficiales de inmigración de manera a menudo violenta. Videos como este de Obama son la normalización, la burla, la celebración de la erosión de los derechos civiles que estamos viendo actualmente dirigidos a los estadounidenses negros, marrones y vulnerables. No hay nada inocente o no planificado en este tipo de videos. Son un arma política que se usa para un propósito. Porque cuando la repetición le abre la conmoción de ellos, ¿cuánto tiempo antes de que ya no nos sorprenda imágenes reales de arrestos reales?

Etiqueta: profundo

Varios legisladores tienen rencor con los creadores detrás de esas imágenes sexualmente explícitas de IA de Taylor Swift que circularon en las redes sociales el jueves. Los representantes de Nueva York Joe Morelle e Yvette Clarke, ambos demócratas, centraron su atención en el último incidente de alto perfil de pornografía deepfake y condenaron la mayor creación y proliferación de imágenes generadas por inteligencia artificial que afectan abrumadoramente a mujeres y niños. «La difusión de imágenes explícitas de Taylor Swift generadas por IA es espantosa y, lamentablemente, les está sucediendo a las mujeres en todas partes, todos los días», dijo Morelle en un tweet. «Es explotación sexual», añadió Morelle, antes de promocionar su propuesta de Ley de Prevención de Deepfakes de Imágenes Íntimas, un proyecto de ley que haría ilegal compartir pornografía deepfake sin el consentimiento de las personas retratadas. En su tuit, Clarke señaló que las mujeres han sido sometidas a deepfakes no consensuales durante años y que los avances en la tecnología de inteligencia artificial están haciendo que sea más fácil y barato para las personas crear deepfakes. «Este es un problema que ambos lados del pasillo e incluso los Swifties deberían poder unirse para resolverlo», escribió Clarke. Los políticos publicaron sus declaraciones horas después de que los fanáticos de Swift expresaran su indignación en X (anteriormente Twitter). “Protect Taylor Swift” se convirtió en un grito de guerra para los Swifties el jueves mientras apoyaban a la ganadora del Grammy. Las imágenes manipuladas eran de naturaleza pornográfica y hacían referencia al romance de alto perfil del cantante de “Midnights” con el ala cerrada de los Kansas City Chiefs, Travis Kelce. Lo que le pasó a Taylor Swift no es nada nuevo. Durante años, las mujeres han sido blanco de deepfakes sin su consentimiento. Y con los avances en IA, crear deepfakes es más fácil y económico. Este es un problema que ambos lados del pasillo e incluso los Swifties deberían poder unirse para resolverlo. Yvette D. Clarke (@RepYvetteClarke) 25 de enero de 2024 Un número de Swifties se encargaron de denunciar las cuentas X que comparten los deepfakes de Swift. “Es realmente aterrador que existan. Por favor, informe y no preste más atención a esos tweets”, dijo el usuario @naboocoffee, quien compartió una captura de pantalla de su actividad de informes. “Tenemos que proteger a Taylor Swift de toda esta IA b-. ¡¡¡No me importa si ella no me conoce, es una decencia humana básica no permitir que tu imagen sea explotada haciendo porno con IA!!!”, publicó @everhero13. «Protégela, no hagas mal uso de la tecnología», escribió @WhyParker_. «La IA de Taylor Swift es repugnante». La publicación de imágenes de desnudos no consensuales (NCN) está estrictamente prohibida en X y tenemos una política de tolerancia cero hacia dicho contenido. Nuestros equipos están eliminando activamente todas las imágenes identificadas y tomando las medidas adecuadas contra las cuentas responsables de publicarlas. Estamos estrechamente…— Seguridad (@Safety) 26 de enero de 2024 Horas después de que circularan las imágenes, el equipo de seguridad de X recordó a los usuarios el jueves por la noche su “política de tolerancia cero” al compartir “imágenes de desnudos no consensuales (NCN)”. La declaración, que no menciona explícitamente a Swift, también dice que los usuarios que publicaron las imágenes serían responsables. «Estamos monitoreando de cerca la situación para garantizar que cualquier infracción adicional se aborde de inmediato y que el contenido se elimine», agregó la cuenta de seguridad de X. «Estamos comprometidos a mantener un entorno seguro y respetuoso para todos los usuarios». Un representante de Swift no respondió a las múltiples solicitudes de comentarios del Times. Las imágenes de IA provocaron la indignación pública un mes después de que una madre de Nueva Jersey instara a los legisladores a promulgar más protecciones contra la tecnología de IA después de que circularan en su escuela secundaria imágenes falsas de desnudos de su hija de 14 años y otras compañeras de clase. «Estamos luchando por nuestros hijos», dijo Dorota Mani, residente de Westfield. “No son republicanos ni demócratas. No les importa. Solo quieren ser amados y quieren estar a salvo”. El año pasado, los populares streamers de Twitch Imane “Pokimane” Anys, Maya Higa y QTCinderella se pronunciaron en contra de los deepfakes después de enterarse de que sus imágenes se utilizaban sin su consentimiento para un sitio web pornográfico de inteligencia artificial. . “Todos, joder, deténganse. Deja de difundirlo. Deja de publicitarlo. Detente”, tuiteó QTCinderella. “Ser visto ‘desnudo’ en contra de tu voluntad NO DEBE SER PARTE DE ESTE TRABAJO”. En los últimos años, la IA se ha convertido en un dolor de cabeza para Hollywood y otros creadores. En medio de la huelga de actores del año pasado, Tom Hanks advirtió a sus seguidores sobre un anuncio de un plan dental que utilizaba una “versión IA de mí”. “No tengo nada que ver con eso”, dijo en una publicación de Instagram. Puede que Swift sea una estrella de alto perfil que supuestamente se unió al club multimillonario el año pasado, pero sus fanáticos dicen que sigue siendo una “persona real” que merece respeto y dignidad. «‘Ella es una multimillonaria blanca’ nunca es una excusa para difundir imágenes de IA de mujeres sexualizando», dijo @jdjoshi60. “PROTEJA A TAYLOR SWIFT”. El redactor del Times, Brian Contreras, y Associated Press contribuyeron a este informe.

Source link

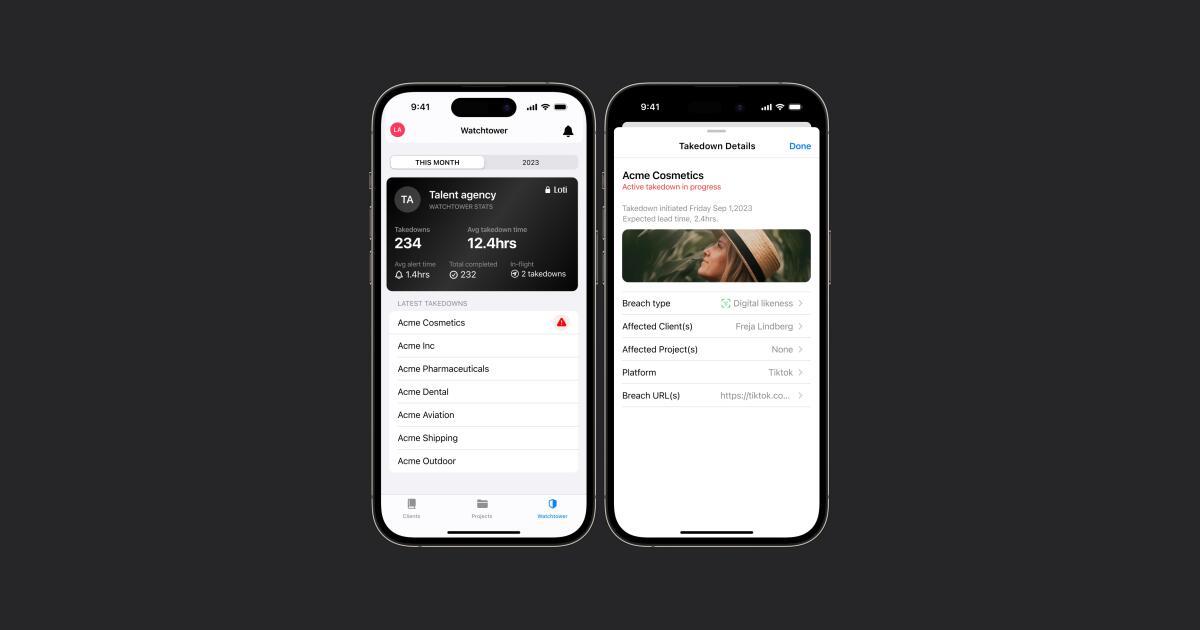

A medida que proliferan los avances en inteligencia artificial, las agencias de talentos están reforzando sus defensas para proteger a las estrellas de Hollywood contra imágenes o videos engañosos y manipulados que pueden poner en riesgo a sus clientes. El auge de la IA generativa y los “deepfakes”, o videos e imágenes que utilizan una la imagen de una persona de forma falsa, han dado lugar a una amplia proliferación de clips no autorizados que pueden dañar las marcas y los negocios de las celebridades. Estos clips pretenden mostrar a personajes famosos diciendo y haciendo cosas que nunca dijeron o hicieron. Por ejemplo: desnudos falsos de una persona famosa o vídeos elaborados para que parezca que una estrella de Hollywood promociona un producto que en realidad no ha utilizado. Y se espera que el problema crezca. Ahora existen herramientas tecnológicas que utilizan la IA para combatir esa amenaza, y la industria del entretenimiento ha llamado a su puerta. La agencia de talentos WME se ha asociado con Loti, una firma con sede en Seattle que se especializa en software utilizado para señalar contenido no autorizado publicado con imágenes de clientes en Internet. La compañía, que tiene 25 empleados, envía rápidamente solicitudes a plataformas en línea para que se eliminen las fotos y videos infractores. Los detalles financieros del acuerdo no fueron revelados. La inteligencia artificial ha sido vista como amiga y enemiga en Hollywood: una herramienta que potencialmente podría hacer que los procesos sean más eficientes e inspirar nuevas innovaciones, pero también es vista como una asesina de empleos y otra forma más de robar la propiedad intelectual. La necesidad de mejores protecciones contra la IA jugó un papel central en las huelgas del verano pasado del Writers Guild of America y el gremio de actores SAG-AFTRA. El martes, la organización sin fines de lucro Artist Rights Alliance publicó una carta abierta a las empresas de tecnología exigiendo que «dejen de devaluar» su trabajo, con firmas de 200 músicos, entre ellos Billie Eilish y Elvis Costello. A medida que se multiplican los deepfakes, las agencias esperan utilizar la IA para detener a los malos actores en línea. “El peor juego de golpear al topo que vas a jugar es lidiar con el problema de los deepfake sin un socio tecnológico que te ayude”, dijo Chris Jacquemin. , socio de WME y jefe de estrategia digital. El cofundador de Loti, Luke Arrigoni, lanzó la startup hace aproximadamente un año y medio. Anteriormente dirigió una empresa de inteligencia artificial llamada Arricor AI y antes fue científico de datos en Creative Artists Agency, el principal rival de WME. Arrigoni dijo que Loti comenzó a trabajar con WME hace unos cuatro o cinco meses. Los clientes de WME le dan a Loti algunas fotos de ellos mismos desde diferentes ángulos. También grabaron clips de audio cortos que luego se utilizan para ayudar a identificar contenido no autorizado. El software de Loti busca en la web e informa a los clientes sobre estas imágenes no autorizadas y envía solicitudes de eliminación a las plataformas. «Existe una sensación cada vez mayor de que éste es un problema imposible», dijo Arrigoni. “Ahora existe un refrán en el que la gente dice: ‘Una vez que está en Internet, estará en Internet para siempre’. Toda nuestra empresa disipa ese mito”. Arrigoni se negó a decir los términos financieros de la asociación o cuántos clientes de WME están utilizando la tecnología de Loti. Antes de utilizar la tecnología de Loti, dijo Jacquemin, su agencia tendría que luchar contra el problema de los deepfakes de forma mucho más ad hoc. Tendrían que pedir a las plataformas web, como YouTube y Facebook, que eliminen los materiales no autorizados basándose en lo que vieron mientras navegaban o en lo que escucharon a través de sus clientes, cuyos fanáticos señalarían el material manipulado. La tecnología de Loti proporciona más visibilidad sobre el tema. Puede haber circunstancias en las que no se elimine todo el contenido no autorizado, según los deseos del cliente. Pero al menos los artistas sabrán lo que hay ahí fuera. En 2022, plataformas como Meta y Google ya estaban lidiando con la eliminación de miles de millones de anuncios o cuentas publicitarias que violaban sus políticas de engaño, dijo Jacquemin. Ahora, cada vez más personas en Hollywood están preocupadas por cómo los nuevos modelos de IA, algunos de los cuales están entrenados en parte con datos disponibles públicamente, podrían potencialmente utilizar obras protegidas por derechos de autor. Estas tecnologías podrían desdibujar aún más la línea entre lo real y lo falso. Si el contenido falso dañino se mantuviera durante demasiado tiempo, podría perjudicar las oportunidades comerciales y los respaldos comerciales de un cliente. «Son tan realistas que a la mayoría de la gente le resultaría difícil notar la diferencia», dijo Arrigoni. Esta es la última asociación que WME y su empresa matriz Endeavor han realizado con una empresa relacionada con la IA. En enero, WME se asoció con la startup Vermillio, con sede en Chicago, para proteger a los clientes contra el robo de propiedad intelectual, detectando cuándo el contenido generativo de IA utiliza la imagen o la voz de un cliente. Endeavour es un inversor minoritario en Speechify, que fabrica tecnología de texto a voz. El director ejecutivo de Endeavor, Ari Emanuel, utilizó la herramienta Speechify para crear una versión sintética de su voz, que pronunció el discurso de apertura de una conferencia telefónica sobre resultados de Endeavor el año pasado. (El martes, Endeavor anunció que su mayor accionista, Silver Lake, privatizará la empresa en un acuerdo que la valorará en 13.000 millones de dólares). Hasta ahora, Loti se autofinancia, dijo Arrigoni. Dijo que él mismo invirtió 1 millón de dólares en la empresa. Actualmente, la empresa se encuentra en el proceso de recaudar una cantidad no revelada para una ronda de semillas.

Source link

Con el anuncio de NVIDIA de AI Enterprise 5.0 y NVIDIA Inference Microservices en la conferencia GTC, el CEO Jensen Huang planea comenzar una era para hacer que la implementación de AI empresarial sea más fácil y más aplicable que nunca, posiblemente mientras cambia la forma principal en que las personas interactúan con las computadoras. La idea de controlar y programar computadoras solo con indicaciones es similar a lo que Humane ha propuesto con su Ai Pin basado en indicaciones, pero Huang la extiende a los desarrolladores y TI, así como a los consumidores: “El trabajo de la computadora es no requerir C++ para será útil”, afirmó Huang durante la sesión de preguntas y respuestas de prensa de NVIDIA GTC celebrada el 19 de marzo en San José, California (Figura A). Figura A El director ejecutivo de NVIDIA, Jensen Huang, habla durante una sesión de preguntas y respuestas con la prensa durante el NVIDIA GTC en San José, California, el 19 de marzo. Imagen: Megan Crouse/TechRepublic El director ejecutivo de NVIDIA, Jensen Huang, habla durante una sesión de preguntas y respuestas con la prensa durante el NVIDIA GTC en San José, California, el 19 de marzo. Imagen: Megan Crouse/TechRepublic Huang: La ingeniería rápida está transformando la programación Cuando se le preguntó si la programación seguirá siendo una habilidad útil en la era de las indicaciones generativas de IA, Huang dijo: «Creo que la gente debería aprender todo tipo de habilidades» y comparó el código. hasta hacer malabares, tocar el piano o aprender cálculo. Sin embargo, Huang dijo: «La programación no será esencial para que usted sea una persona exitosa». VER: Huang anunció una amplia gama de productos NVIDIA para centros de datos, inteligencia artificial empresarial, criptografía y más durante el discurso de apertura de la conferencia GTC. (TechRepublic) La IA generativa, dijo Huang, está “cerrando la brecha tecnológica. No es necesario ser programador de C++ para tener éxito”, afirmó. “Solo hay que ser un ingeniero rápido. ¿Y quién no puede ser un ingeniero puntual? Cuando mi esposa me habla, rápidamente me manipula. … Todos necesitamos aprender a incitar a las IA, pero eso no es diferente a aprender a incitar a los compañeros de equipo”. Huang continuó diciendo: «Pero si alguien quiere aprender a hacerlo (programar), que lo haga porque estamos contratando programadores». PREMIUM: aprenda cómo convertirse en un ingeniero rápido en esta descarga Premium de TechRepublic La ingeniería rápida es una habilidad que cambia rápidamente. ¿La ingeniería rápida reemplazará la programación tradicional cuando se trata de crear IA generativa a partir de IA generativa como sugirió Huang? «No dejaría mi trabajo diario todavía para convertirme en un ingeniero rápido», dijo Chirag Dekate, analista de Gartner, en una llamada a TechRepublic el 19 de marzo. «Desafortunadamente, el mercado se está corrigiendo excesivamente». Y el mercado se está sobrecorregindo ante un aumento en la demanda de lo que solía ser la ingeniería rápida. En una industria que cambia rápidamente, optimizar las indicaciones para lograr que una IA genere el texto correcto puede que ya no sea la forma en que se realiza la ingeniería de indicaciones de IA; en cambio, las indicaciones pueden ser multimodales. Los NIM son notables, dijo Dekate, porque encajan perfectamente la IA generativa en el contexto de multinube híbrida en el que operan muchas empresas. «Lo que NVIDIA está construyendo ahora es una base para las empresas nativas de IA de próxima generación, donde donde quiera que vayan las empresas experimentarán NIM», dijo. Sin embargo, es posible que NVIDIA no sea la empresa que haga realidad la transformación. Dekate señaló a Cognition AI, que la semana pasada presentó a Devin, su “ingeniero de software de IA”, como una señal de que la forma en que se realiza la ingeniería de software puede cambiar en el futuro. Más cobertura de IA de lectura obligada No importa qué nombre termine en el software más común, Dekate dijo que la forma en que los desarrolladores interactúan con la IA generativa cambiará rápidamente. «El ritmo de innovación de la IA generativa continúa acelerándose», afirmó Dekate. “Lo más probable es que no interactuemos con ninguno de estos modelos utilizando nuestras percepciones heredadas. Me refiero a tecnología de hace tres o seis meses como legado. La IA generativa cambia así de rápido”. David Nicholson, director de investigación de The Futurum Group, dijo a TechRepublic por correo electrónico que en un futuro de IA generativa «una instalación con lenguaje humano se convierte en una habilidad informática importante». “Tu título en inglés (o) historia o derecho de repente te ayuda a convertirte en un ingeniero rápido, pero una especialización en ciencias de la computación nunca estará de más”, escribió Nicholson. “No es una exageración de NVIDIA. Es verdaderamente una revolución”. Descargo de responsabilidad: NVIDIA pagó mi pasaje aéreo, alojamiento y algunas comidas para el evento NVIDIA GTC que se llevó a cabo del 18 al 21 de marzo en San José, California.

McAfee, una empresa de ciberseguridad, ha lanzado el Proyecto Mockingbird. Esta es una tecnología de detección de audio Deepfake impulsada por IA. Con este proyecto, la empresa espera proteger a los consumidores contra la creciente amenaza de las estafas de audio generadas por IA. La tecnología utiliza una combinación de modelos de detección contextuales, conductuales y categóricos basados en IA para identificar si el audio de un vídeo probablemente haya sido generado por IA, con una tasa de precisión del 90%. Según el director de tecnología de McAfee, Steve Grobman, esta tecnología se anunciará oficialmente durante la exposición CES 2024. Steve Grobman dijo que combatir las «falsificaciones profundas» tiene una gran importancia técnica. «Es como el pronóstico del tiempo y puede ayudar a las personas a tomar decisiones informadas en la participación digital». En cuanto al precio de “Mockingbird”, Grobman dijo que el plan actual no es cobrar tarifas adicionales a los usuarios sino incluirlo en McAfee+. ¿Qué es el Proyecto Ruiseñor? Project Mockingbird es una tecnología de detección de audio Deepfake impulsada por IA. Fue desarrollado por McAfee para ayudar a defender a los consumidores contra la creciente amenaza del audio generado por IA. Estos audios se utilizan para realizar estafas que roban a las personas dinero e información personal. También permiten el ciberacoso y la manipulación de la imagen pública de figuras destacadas. ¿Por qué es importante el Proyecto Mockingbird? El uso de tecnología deepfake se ha convertido en una preocupación creciente. Esto se debe a que los ciberdelincuentes aprovechan la IA generativa para clonar las voces de celebridades, personas influyentes e incluso de sus seres queridos. El objetivo principal de esto es defraudar a personas desprevenidas. La tecnología también se puede utilizar para manipular vídeos auténticos, como noticieros o entrevistas con celebridades, añadiendo audio falso para cambiar las palabras que salen de la boca de alguien. Project Mockingbird está diseñado para mantener a los usuarios seguros en línea contra estafas engañosas de deepfake. Según la Comisión Federal de Comercio de EE. UU., en noviembre del año pasado, nuevas estafas basadas en tecnología de inteligencia artificial defraudaron a los ancianos locales de sus propiedades. A lo largo de 2022, las personas mayores en todo Estados Unidos perdieron 1.600 millones de dólares debido a estafas. Muchas de estas estafas utilizaron tecnología de inteligencia artificial para “clonar” las voces de conocidos. Estas estafas también utilizan otros trucos que se basan en la generación de IA. Gizchina Noticias de la semana Entre varios tipos de fraude, incluida la suplantación de identidad y el fraude financiero, las llamadas automáticas, el fraude informático, el engaño en los perfiles de citas y la suplantación de identidad, el uso de tecnología de inteligencia artificial para imitar voces se ha convertido en la estafa más destacada. En una audiencia del comité sobre estafas de IA, varios testigos dijeron que “recibían llamadas que parecían como si sus seres queridos estuvieran en peligro, heridos o retenidos como rehenes”. Entre ellos, una pareja de ancianos recibió una llamada y la voz en el teléfono sonaba como si su hija estuviera llorando “mamá” pidiendo ayuda. Gary Schildhorn, un abogado de Filadelfia, también dijo en la audiencia que casi envió $9,000 al estafador hasta que él y su nuera confirmaron que se trataba de una estafa de extorsión. ¿Cómo funciona el Proyecto Mockingbird? Según McAfee, este proyecto combinará un par de modelos para detectar audio falso. El proyecto investigará el comportamiento del hablante para comprobar si el audio del vídeo proviene de IA. La tecnología también analiza el contexto, el comportamiento y la categoría para determinar la autenticidad de los clips de audio dentro de los videos. Las primeras demostraciones públicas del Proyecto Mockingbird se mantuvieron en CES 2024 y se espera una mayor disponibilidad. Conclusión Project Mockingbird es una tecnología de detección de audio Deepfake impulsada por IA. Fue desarrollado por McAfee para proteger a los consumidores contra la creciente amenaza de estafas de audio generadas por IA. La tecnología utiliza una combinación de modelos de detección contextuales, conductuales y categóricos basados en IA. También los utiliza para identificar si es probable que un audio sea generado por IA. El uso de tecnología deepfake se ha convertido en una preocupación creciente. Por lo tanto, Project Mockingbird está diseñado para mantener a los usuarios seguros en línea contra estafas engañosas de deepfake. El autor de Bio Efe Udin es un escritor de tecnología experimentado con más de siete años de experiencia. Cubre una amplia gama de temas en la industria tecnológica, desde la política industrial hasta el rendimiento de los teléfonos móviles. Desde móviles hasta tablets, Efe también ha estado atenta a los últimos avances y tendencias. Proporciona análisis y reseñas perspicaces para informar y educar a los lectores. Efe es un apasionado de la tecnología y cubre historias interesantes, además de ofrecer soluciones cuando es posible. Descargo de responsabilidad: Es posible que algunas de las empresas de cuyos productos hablamos nos compensen, pero nuestros artículos y reseñas son siempre nuestras opiniones honestas. Para obtener más detalles, puede consultar nuestras pautas editoriales y conocer cómo utilizamos los enlaces de afiliados.

Dirige tu mente hacia adelante. Es el 8 de noviembre de 2028, el día después de otra elección presidencial. Esto transcurrió sin contratiempos (no hubo denuncias de manipulación desenfrenada, ni ninguna mancha significativa de artimaña) debido en gran parte a la derrota de los deepfakes, el nuevo enemigo de la democracia. ¿Es posible un futuro así? Hasta ahora, ni el gobierno ni la industria tecnológica han acordado medidas de seguridad efectivas contra los deepfakes. Pero estas preguntas frecuentes (de cinco años en el futuro) muestran que los acontecimientos de 2024 bien pueden forzar la cuestión y que es posible encontrar una solución. ¿Por qué llevó tanto tiempo encontrar una forma eficaz de luchar contra los deepfakes? A finales de 2022, apareció un sofisticado software de inteligencia artificial de bajo costo que facilitó la creación de audio, videos y fotografías realistas: los llamados deepfakes. A medida que estos programas de IA generativa mejoraron rápidamente, quedó claro que el contenido deepfake sería un peligro para la democracia. Pronto surgieron deepfakes políticos, tanto de audio como de vídeo: el presidente Biden anunció que los estadounidenses serían reclutados para luchar en Ucrania. Una foto de Donald Trump abrazando y besando al Dr. Anthony Fauci. La senadora Elizabeth Warren (D-Mass.) le dice a MSNBC que a los republicanos no se les debería permitir votar en 2024. Eric Adams, el alcalde monolingüe de Nueva York, habla español, yiddish y mandarín en llamadas automáticas producidas por IA. Muy rápidamente, el La Casa Blanca, la Unión Europea y las principales empresas de tecnología lanzaron propuestas de regulación de IA de amplio alcance que incluían “marcas de agua” en el contenido de IA: insertar etiquetas de identificación, un código informático permanente, en el archivo digital de cualquier contenido generado por IA para identificar su origen artificial. Pero el establecimiento de reglas de IA resultó complejo, y el etiquetado ejemplificó los dilemas: ¿Sería legalmente necesaria la marca de agua de IA? ¿Cómo se haría cumplir? Ya en 2023, algunas cámaras de teléfonos móviles utilizaban IA en el procesamiento de imágenes. ¿Qué cantidad de entrada de IA en el contenido requeriría un identificador? ¿Necesitaría una influencer de belleza de Instagram poner una marca de agua en sus selfies con rostro ajustado? Las complicaciones fueron tales que ningún sistema se adoptó ampliamente. ¿Qué cambió? El mayor ataque coordinado de deepfake de la historia tuvo lugar el día después de las elecciones de noviembre de 2024. Todos los canales de redes sociales de EE. UU. se vieron inundados de audio, videos e imágenes fijas falsas que mostraban fraude electoral en una docena de estados en disputa, contenido altamente realista que en cuestión de horas fue visto por millones. Los esfuerzos de desacreditación por parte de los medios y el gobierno se vieron obstaculizados por un flujo constante de nuevos deepfakes, en su mayoría fabricados en Rusia, Corea del Norte, China e Irán. El ataque generó un caos legal y civil que duró hasta bien entrada la primavera de 2025. ¿Sin embargo, no se adoptó ninguno de los primeros esfuerzos de autenticación? Correcto. En realidad, el gran avance se produjo a principios de 2026 de la mano de un grupo de trabajo de periodistas digitales de organizaciones de noticias estadounidenses e internacionales. Su objetivo era encontrar una manera de mantener los deepfakes fuera de las noticias, para poder proteger la credibilidad que aún conservaban los principales medios de comunicación. Era una tarea lógica: los periodistas son históricamente despiadados a la hora de castigar a sus pares por mala conducta, rompiendo el alquitrán y las plumas incluso por desviaciones menores del rigor fáctico. Las organizaciones periodísticas formaron la Alianza FAC – “Contenido autenticado por hechos” – basándose en una idea simple: Ya había demasiadas falsificaciones de IA en el mundo como para intentar imponer un sistema de marcas de agua para la desinformación y la desinformación. E incluso las normas de etiquetado más estrictas serían simplemente ignoradas por los malos actores. Pero sería posible poner marcas de agua en fragmentos de contenido que no fueran deepfakes. Y así nació el FACStamp voluntario el 1 de mayo de 2026. ¿Cómo es un FACStamp? Para los consumidores, el contenido con sello FAC muestra un pequeño ícono «FAC» en una esquina de la pantalla o incluye un aviso FAC de audio. El usuario puede apagar la señal o puede configurarla para que aparezca solo durante cinco o 10 segundos al inicio de una transmisión multimedia. Los FACStamps son completamente voluntarios. Pero todos los miembros de la Alianza FAC se comprometieron a que sus informes físicos, de transmisión y de Internet publicarían solo medios con sello FACS en sus secciones de noticias. ¿Cómo califica el contenido para un sello FACStam? Los teléfonos, tabletas, cámaras, grabadoras y computadoras de escritorio más nuevos incluyen software que inserta automáticamente el código FACStamp en cada pieza de contenido visual o de audio a medida que se captura, antes de que se pueda aplicar cualquier modificación de IA. Esto demuestra que la imagen, el sonido o el vídeo no fueron generados por IA. También puedes descargar la aplicación FAC, que hace lo mismo con equipos más antiguos. El FACStamp es lo que los tecnólogos llaman “frágil”: la primera vez que la IA falsifica una imagen, un video o un archivo de audio, el sello desaparece. Pero la IA a menudo se usa apropiadamente para hacer cosas como reducir el ruido de fondo en un archivo de audio. ¿El contenido FacStamped no se puede editar en absoluto? Ciertamente puede. Pero para conservar el FACStamp, su computadora debe estar conectada al Centro de verificación FAC sin fines de lucro. Las computadoras del centro detectan si la edición es menor (como un recorte o incluso un ajuste cosmético del rostro) y el sello permanece. Cualquier manipulación mayor, desde intercambiar caras hasta fondos falsos, y el FACStamp desaparece. ¿Cómo se extendió FACStamps más allá del periodismo? Resultó que mucha gente podía utilizar FACStamp. Los minoristas de Internet adoptaron FACStamps para vídeos e imágenes de sus productos. Pronto le siguieron los particulares, que utilizan FACStamps para vender productos en línea. Cuando los compradores potenciales juzgan una camioneta usada o un sofá de segunda mano, es reconfortante saber que la imagen no fue eliminada ni borrada por la IA. En 2027, el sello comenzó a aparecer en medios de comunicación social. Cualquier padre puede generar artificialmente una imagen perfectamente realista de su familia feliz parada frente a la Torre Eiffel y publicarla o enviarla por correo electrónico a amigos envidiosos. Un FACStamp demuestra que la familia realmente estuvo allí. Los perfiles de aplicaciones de citas sin FACStamps finalmente se están volviendo raros. Las aplicaciones de videoconferencia tienen opciones FAC para garantizar que todos los participantes en la llamada sean reales. Y para los influencers, es cada vez más difícil reclamar “autenticidad” sin al menos el FACStamp ocasional. Incluso la industria de la IA apoya el uso de FACStamps. Durante los entrenamientos en Internet, si un programa de IA absorbe cantidades excesivas de datos generados por IA en lugar de datos auténticos, puede sufrir un «colapso del modelo» y volverse tremendamente inexacto. Por eso, FACStamp ayuda a las empresas de IA a entrenar sus modelos basándose únicamente en la realidad. ¿Qué sigue? Un grupo bipartidista de senadores y miembros de la Cámara planea presentar la Ley del Derecho a la Realidad cuando se abra el próximo Congreso en enero de 2029. Exigirá el uso de FACStamps en múltiples sectores, incluidos el gobierno local, los sitios comerciales y las ofertas de inversión y bienes raíces. La falsificación de un FACStamp se convertiría en un delito penal. Las encuestas indican un amplio apoyo público a la ley, y la Alianza FAC ya ha comenzado una campaña de promoción de marca. El eslogan: “¿Es eso una FAC? “Michael Rogers es un autor y futurista cuyo libro más reciente es “Email From the Future: Notes From 2084”.

Source link