Es algo que hemos visto antes, muchas veces: cada año, una gran marca de teléfonos inteligentes toma el escenario para mostrar sus últimos teléfonos inteligentes insignia con grandes promesas de actualizaciones de software, mejor rendimiento y una experiencia de usuario más refinada. Y cada año, tiene innumerables revisiones tecnológicas en Internet que resaltan las mejores partes de estos teléfonos nuevos, al tiempo que muestra las grietas intermedias. Leer: Pixel 9 Pro vs Pixel 10 Pro (y XL): ¿Qué vale la pena la actualización? Este año (o más bien esta semana en particular), son los teléfonos Pixel 10 Series de Google los que están bajo el centro de atención. Si bien los teléfonos inteligentes de Pixel han logrado obtener una audiencia gracias a las características fuertes, como capacidades fotográficas, características de software ingeniosas y la usabilidad cotidiana simple, nunca se han destacado realmente a competir con marcas rivales en términos de rendimiento, un punto débil de los chips tensores de Google. Y es este punto débil ese año tras año sigue siendo un importante tema de conversación. «El próximo tensor será mejor», «Google lo hará justo el próximo año», «solo espere a la próxima generación», y así sucesivamente. Esta ha sido más o menos la tendencia desde el debut del Pixel 6 junto con los chips tensor de primera generación, aunque se ha hablado mucho este año del Tensor G5, que para el crédito de Google trae algunos cambios clave. Es importante tener en cuenta que, a diferencia de los procesadores de tensor anteriores, el G5 es fabricado por Taiwan Semiconductor Manufacturing Corporation (TSMC), la misma compañía responsable de los impresionantes chips de élite Snapdragon 8 gen 3 y 8. Samsung Foundry produjo modelos de tensor más antiguos, y han sufrido más o menos puntajes de referencia poco impresionantes, problemas de conectividad e incluso problemas térmicos, por lo que hay muchas esperanzas en TSMC para los insignia de píxeles de este año. … Hay mucha esperanza en TSMC para los buques insignia de Pixel de este año. Sin embargo, las primeras pruebas de referencia muestran que el Tensor G5 no ganará pronto cualquier enfrentamiento de rendimiento. El G5 registró 2,276 puntos en un solo núcleo y 6,173 en puntajes de múltiples núcleos, aunque todavía se encuentra detrás de los líderes actuales como el Snapdragon 8 Elite (3,070/9,251) y Dimensidad 9400 (2,597/8,109), con sus números más cercanos a la dimensidad más antigua 9300. Esto se dicen, los fanáticos de los píxeles no deberían ser demasiado rápidos para ser rápidos para que sean demasiado rápidos para poner todo el huevo en el Tengor en el Tensor en el Tensor de los Tensores. cesta. Ha habido muchas grandes expectativas del Pixel 10, con el que el G5 es visto por algunos como el único factor decisivo en cuanto al destino de toda la línea de píxeles. Claro que juega un papel importante, pero me gustaría pensar que Google todavía tiene su trabajo reducido, especialmente si quiere ganar más usuarios a largo plazo. No soy un experto en desarrollo de productos, pero hablando desde la perspectiva de un usuario final que ha usado varios modelos de píxeles a lo largo de los años, se podría decir que Google se ha quedado atrás de la competencia cuando se trata de ciertas características. Por ejemplo, estamos viendo grandes saltos de las marcas chinas cuando se trata de hardware de cámara, como sensores de imágenes más potentes que les permiten competir con el enfoque de fotografía basado en software de Google. Dado que los teléfonos de píxeles también se comercializan en parte para los fanáticos de Android, no es ningún secreto que también hemos visto quejas cuando se trata de cosas como la personalización de la interfaz de usuario, algo que ha sido una característica estándar en las pieles de Android de terceros como una interfaz de usuario, Oxygen OS y Hyper OS. Los widgets no removables, los problemas de aplicaciones de pantalla completa e incluso los temas de iconos uniformes son elementos con los que la línea de píxeles todavía lucha, aunque Google afortunadamente promete mejoras con el material 3 expresivo. Leer: Google confirma que el rediseño del teléfono de Pixel ocurre cada 2-3 años, por supuesto, es demasiado pronto para predecir cómo le irá a la línea Pixel de este año. Quizás el G5 sea un gran éxito y arreglará todos los problemas de teléfonos inteligentes de Google, o tal vez las cosas van a una dirección completamente diferente. Pero como el tiempo le dirá, es mejor no contar todos sus pollos antes de que eclosionen, especialmente cuando se trata de tecnología.

Etiqueta: tsmc

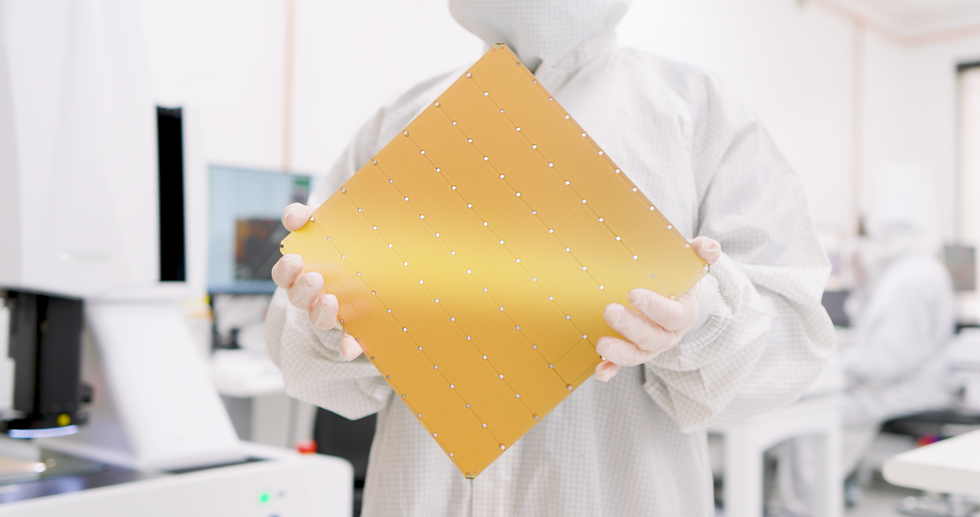

Cerebras, la empresa de supercomputadoras de inteligencia artificial de Sunnyvale, California, dice que su próxima generación de chips de inteligencia artificial en escala de oblea puede duplicar el rendimiento de la generación anterior y consumir la misma cantidad de energía. El Wafer Scale Engine 3 (WSE-3) contiene 4 billones de transistores, un aumento de más del 50 por ciento con respecto a la generación anterior gracias al uso de tecnología de fabricación de chips más nueva. La compañía dice que utilizará el WSE-3 en una nueva generación de computadoras con inteligencia artificial, que ahora se están instalando en un centro de datos en Dallas para formar una supercomputadora capaz de realizar 8 exaflops (8 mil millones de billones de operaciones de punto flotante por segundo). Por otra parte, Cerebras ha firmado un acuerdo de desarrollo conjunto con Qualcomm que tiene como objetivo aumentar diez veces una métrica de precio y rendimiento para la inferencia de IA. La compañía dice que el CS-3 puede entrenar modelos de redes neuronales con un tamaño de hasta 24 billones de parámetros, más de 10 veces el tamaño de los LLM más grandes de la actualidad. Con WSE-3, Cerebras puede mantener su pretensión de producir el chip individual más grande del mundo. De forma cuadrada y 21,5 centímetros de lado, utiliza casi una oblea entera de silicio de 300 milímetros para fabricar un chip. Los equipos de fabricación de chips suelen limitarse a producir matrices de silicio de no más de unos 800 milímetros cuadrados. Los fabricantes de chips han comenzado a escapar de ese límite mediante el uso de integración 3D y otras tecnologías de embalaje avanzadas. Integración 3D y otras tecnologías de embalaje avanzadas para combinar múltiples matrices. Pero incluso en estos sistemas, el número de transistores es de decenas de miles de millones. Como es habitual, un chip tan grande viene con algunos superlativos alucinantes. Transistores 4 billones de milímetros cuadrados de silicio 46.225 núcleos de IA 900.000 cálculos de IA 125 petaflops Memoria en el chip 44 gigabytes Ancho de banda de la memoria 21 petabytes Ancho de banda de la estructura de red 214 petabits Puede ver el efecto de la Ley de Moore en la sucesión de chips WSE. El primero, que debutó en 2019, se fabricó utilizando la tecnología de 16 nanómetros de TSMC. Para WSE-2, que llegó en 2021, Cerebras pasó al proceso de 7 nm de TSMC. WSE-3 está construido con la tecnología de 5 nm del gigante de la fundición. El número de transistores se ha más que triplicado desde el primer megachip. Mientras tanto, el uso que se les da también ha cambiado. Por ejemplo, el número de núcleos de IA en el chip se ha estabilizado significativamente, al igual que la cantidad de memoria y el ancho de banda interno. Sin embargo, la mejora del rendimiento en términos de operaciones de punto flotante por segundo (flops) ha superado todas las demás medidas. CS-3 y Condor Galaxy 3 La computadora construida alrededor del nuevo chip AI, el CS-3, está diseñada para entrenar nuevas generaciones de modelos de lenguaje gigantes, 10 veces más grandes que el GPT-4 de OpenAI y el Gemini de Google. La compañía dice que el CS-3 puede entrenar modelos de redes neuronales de hasta 24 billones de parámetros de tamaño, más de 10 veces el tamaño de los LLM más grandes de la actualidad, sin recurrir a un conjunto de trucos de software que necesitan otras computadoras. Según Cerebras, eso significa que el software necesario para entrenar un modelo de mil millones de parámetros en el CS-3 es tan sencillo como entrenar un modelo de mil millones de parámetros en GPU. Se pueden combinar hasta 2.048 sistemas, una configuración que permitiría entrenar el popular LLM Llama 70B desde cero en solo un día. Sin embargo, no se está preparando nada tan grande, dice la compañía. La primera supercomputadora basada en CS-3, Condor Galaxy 3 en Dallas, estará compuesta por 64 CS-3. Al igual que sus sistemas hermanos basados en CS-2, el G42 de Abu Dhabi es propietario del sistema. Junto con Condor Galaxy 1 y 2, esto forma una red de 16 exaflops. «La red Condor Galaxy existente ha entrenado algunos de los modelos de código abierto líderes en la industria, con decenas de miles de descargas», dijo Kiril Evtimov, CTO del grupo G42 en un comunicado de prensa. «Al duplicar la capacidad a 16 exaflops, esperamos ver la próxima ola de innovación que las supercomputadoras Condor Galaxy pueden permitir». Un acuerdo con Qualcomm Si bien las computadoras Cerebras están diseñadas para capacitación, el director ejecutivo de Cerebras, Andrew Feldman, dice que la inferencia, la ejecución de modelos de redes neuronales, es el límite real para la adopción de la IA. Según estimaciones de Cerebras, si cada persona en el planeta usara ChatGPT, costaría 1 billón de dólares al año, sin mencionar una cantidad abrumadora de energía procedente de combustibles fósiles. (Los costos operativos son proporcionales al tamaño del modelo de red neuronal y la cantidad de usuarios). Por eso, Cerebras y Qualcomm se han asociado con el objetivo de reducir el costo de la inferencia en un factor de 10. Cerebras dice que su solución implicará aplicar Técnicas de redes neuronales como la compresión de datos de peso y la escasez: la poda de conexiones innecesarias. Las redes entrenadas por Cerebras luego se ejecutarían eficientemente en el nuevo chip de inferencia de Qualcomm, el AI 100 Ultra, afirma la compañía. Artículos de su sitioArtículos relacionados en la Web

Source link