¡Hola, todo, y feliz viernes! Bienvenido de nuevo a TechCrunch Mobility, su centro de noticias, análisis y recogidas en torno al futuro del transporte. Para obtener esto en su bandeja de entrada, regístrese aquí de forma gratuita, ¡haga clic en TechCrunch Mobility! Me entristeció haber perdido la Semana del automóvil de Monterey este año, especialmente porque hubo una serie de revelaciones que me interesaba, incluida la velocidad opulenta Cadillac All-Electric; los conceptos Chevrolet Corvette CX y CX.R Vision Gran Turismo; y la gravedad lúcida X revela. Pero, por desgracia, los extensos terrenos de codorniz o el mar de los trajes de Seersucker y los sombreros de ala ancha en el campo de golf de Pebble Beach fueron paisajes subóptimos para mi pie recién fracturado y con botas. ¡Al año que viene! Mientras tanto, pensé que me comunicaría con usted, querido lector, para obtener su pronóstico sobre lo que está reservado para los fabricantes de automóviles y las ventas de EV en los Estados Unidos una vez que el crédito fiscal federal EV expire el 30 de septiembre. ¿Mi predicción? Bueno, realmente no quiero contaminar los resultados, pero diré esto: los fabricantes de automóviles tendrán que hacer algo a corto plazo para atraer a los clientes, y no solo por el crédito fiscal EV expirado. Un poco de créditos de imagen de pájaros: Bryce Durbin sirve a Robotics, la compañía de robot de entrega de la acera autónoma, anunció a principios de esta semana que adquirió Vayu Robotics, una startup que ha desarrollado modelos de base de IA y un motor de datos con simulación para robots. Las compañías no revelaron los términos del acuerdo, pero algunas matemáticas de retroceso y un poco de pájaro me ayudaron a determinar que el servicio de robótica pagó entre $ 45 millones y $ 50 millones para Vayu. ¿Tienes un consejo para nosotros? Envíe un correo electrónico a Kirsten Korosec a kirsten.korosec@techcrunch.com o mi señal en KKOROSEC.07, Sean O’Kane en sean.okane@techcrunch.com ¡OFS! Hace varias semanas, destacé un acuerdo entre Uber, la startup de tecnología de vehículos autónomos Nuro y el fabricante de EV Lucid. Puede leer sobre eso aquí, pero la pieza importante para recordar es el compromiso de Uber de hacer una inversión «multimillonaria» no revelada en Nuro. (Las fuentes me dijeron que es más de los $ 300 millones que Uber invirtió en Lucid.) Evento de TechCrunch San Francisco | 27-29 de octubre, 2025 Nuro ahora ha recaudado más dinero en una ronda de la Serie E que ha alcanzado los $ 203 millones de un grupo de nuevos inversores que incluye NVIDIA, el patrocinador existente Baillie Gifford, Icehouse Ventures, Kindred Ventures y Energed Ventures. Y una parte de la inversión de Uber se ha destinado a la ronda de la Serie E. Otros acuerdos que llamaron mi atención … Ark Invest, la firma de Cathie Wood, invirtió alrededor de $ 12.9 millones en la empresa de conducción autónoma china Pony.ai, según la compañía. Grid Aero, una startup aeroespacial, recaudó $ 6 millones en fondos de semillas de las empresas de calibración y las empresas de ubicuidad. Group14, una startup de materiales de batería, recaudó $ 463 millones en una ronda de financiación dirigida por el fabricante de la batería SK con la participación de ATL, Lightrock, Microsoft, Porsche y Omers. Junto con la ronda, el Grupo14 también anunció que había «adquirido la propiedad total» de una empresa conjunta con SK en Corea del Sur. Oway, fundado en 2023 y respaldado por Y Combinator y General Catalyst, recientemente cerró una ronda de semillas de $ 4 millones. Lea el plan de la compañía para construir un «Uber para la carga» descentralizado. Una actualización sobre las estimaciones de capital de IPO: Renaissance Via podría recaudar hasta $ 500 millones. Lecturas notables y otras cositas Hertz comenzarán a vender vehículos previos en Amazon Auto. Redwood Materials dijo que está trabajando con Caterpillar para reciclar las baterías de los cargadores subterráneos eléctricos de batería de la compañía. Tesla planea introducir funciones asistidas por voz en el automóvil impulsadas por Deepseek y la inteligencia artificial de DoBao de Bytedance. La empresa de enrutamiento, una startup que ayuda a las agencias de tránsito a coincidir con los pasajeros con vehículos de manera rápida y económica, aterrizó en Zoox como su primer cliente Robotaxi. Zoox comprará una licencia no exclusiva para la tecnología de la compañía de enrutamiento y traerá a cinco de los ingenieros de la startup a bordo para «avanzar la eficiencia y la escalabilidad» de su servicio robotaxi incipiente. Volkswagen enfrenta una demanda en el Tribunal de Distrito de los Estados Unidos de Nueva Jersey sobre los botones en el volante de sus automóviles, incluida ID.4. La demanda alega que los botones son demasiado sensibles y demasiado fáciles de activar sin querer. A Waymo se le ha otorgado un permiso para probar sus vehículos autónomos en la ciudad de Nueva York, la primera aprobación de este tipo otorgada por la ciudad. La compañía le dijo a TechCrunch que planea comenzar a probar «de inmediato». En el mundo de los drones y la comida, supongo que era inevitable que obtuviéramos Zipotle, una fusión de las palabras Zipline y Chipotle. Zipline, una startup autónoma de entrega de drones, se ha asociado con Chipotle para volar pedidos digitales a las ubicaciones de los invitados en el área metropolitana de Dallas. Una cosa más … Vanity Fair tiene una larga característica en Waymo Co-CEO Tekedra Mawakana que profundiza en su pasado, cómo se maneja y, como señala la autora, su estilo Un-Elon. Vale la pena leerlo y me da la oportunidad de recordarles a todos que Mawakana estará en nuestro escenario en Disrupt 2025, que se llevará a cabo del 27 al 29 de octubre en San Francisco.

Etiqueta: nvidia Página 1 de 3

A principios de este año, el nuevo director ejecutivo de Intel, Lip-Bu Tan, hizo comentarios sobre cómo el fabricante de chips de Silicon Valley sigue quedando corto. «Durante mucho tiempo para Intel, nos quedamos atrás en la innovación. Como resultado, hemos sido demasiado lentos para adaptarnos y satisfacer sus necesidades», dijo Tan a los clientes y socios de Intel en un evento de la compañía a fines de marzo. «Te mereces algo mejor, y necesitamos mejorar, y lo haremos». Intel, un gigante tecnológico con sede en Santa Clara que alimentó el aumento de las computadoras personales, se encuentra en una encrucijada importante en la historia de 57 años de la compañía a medida que la competencia para dominar la inteligencia artificial aumenta. Conocido por hacer los «cerebros» que encienden las computadoras, Intel solía ser el fabricante de chips estadounidense más valioso antes de que Nvidia reclamara el primer lugar. También se enfrenta a una mayor competencia de rivales como Advanced Micro Devices y Samsung. El Frenzy AI ha beneficiado enormemente a Nvidia, una compañía que creó un chip de computadora especializado que ha demostrado ser valioso no solo para los juegos sino también para la capacitación de modelos de IA, centros de datos y robótica. Mientras que el valor de Nvidia se disparó a más de $ 4 billones, Intel ha visto caer su valor de mercado a alrededor de $ 87 mil millones. «Será difícil para ellos», dijo Mario Morales, vicepresidente del grupo para habilitar tecnologías y semiconductores en la Corporación de Datos Internacionales. «Se perdieron un cambio muy grande y aún no tienen los productos en IA para competir, y ese mercado está creciendo rápidamente». En los últimos cinco años, el precio de las acciones de Intel ha cayado más del 58%. Publicó una pérdida neta de $ 18.8 mil millones en 2024 y planea cortar aproximadamente 25,000 trabajadores este año. La larga historia del Intel se ha llenado de altibajos, pero una serie de grandes oportunidades perdidas, demoras en la fabricación y errores de gestión obstaculizaron el crecimiento de una compañía sinónimo de Silicon Valley’s Rise, dicen los analistas. Tan, un líder tecnológico de 65 años que se convirtió en el director ejecutivo de Intel en marzo, está tratando de dirigir la compañía en la dirección correcta. Intel ha apostado en grande en su negocio de fundición, enfrentando a Taiwan Semiconductor Manufacturing Co., lo que hace chips para otras compañías como Apple y Nvidia. En los costos, Intel ha desechado proyectos de fabricación en Alemania y Polonia mientras disminuye la construcción de sus fábricas de Ohio. «No hay más cheques en blanco. Cada inversión debe tener sentido económico», Tan dijo a los empleados en un memorando la semana pasada. Inintel el ascenso y caída en 1968, se centró mucho en la investigación y el desarrollo de sus nuevas tecnologías en sus primeros días. Robert Noyce y Gordon Moore, ya conocidos, ya conocidos, los nuevos conocimientos, los nuevos conocimientos, los nuevos conocimientos, los nuevos conocimientos, ya los nuevos conocimientos, los nuevos conocidos, los nuevos conocimientos, los nuevos conocimientos, los nuevos conocimientos, los nuevos conocidos, los nuevos conocimientos, los Jairch Fig. Semiconductor para lanzar lo que se convertiría en Intel. Noyce co-inventó el circuito integrado, estableciendo las bases para el desarrollo de computadoras portátiles, teléfonos inteligentes y otros productos electrónicos modernos. Moore era conocido por hacer una observación que se convirtió en un principio rector para la industria de los semiconductores. La compañía creció rápidamente en sus primeros años. Los primeros ingenieros de Intel trabajaron en una sala de conferencias en Mountain View, California, antes de que la compañía se mudara a sus propias instalaciones en Santa Clara. La compañía lanzó chips de memoria antes de crear el primer microprocesador disponible comercialmente y otras innovaciones que hicieron posible que las empresas construyan computadoras más asequibles. A medida que las ventas de computadoras de Dell, Microsoft y otras compañías tecnológicas aumentaron, Intel vio su valor de mercado alcanzar un récord de $ 495 mil millones en 2000 durante el auge de las puntos-com, según Reuters. Pero la compañía también hizo una serie de errores que lo perseguirían más tarde, dijeron analistas. Intel declinó hacer comentarios. «Ha estado en una base débil durante tanto tiempo debido a esas malas decisiones históricas», dijo Jacob Bourne, analista de tecnología de EMARKeter. «Ahora es en este punto donde tiene que reducir todos estos costos para tratar de ser rentable». Una de las mayores oportunidades perdidas de Intel: suministrar chips para el primer iPhone en 2007. El ex presidente ejecutivo de Intel, Paul Otellini, dijo a The Atlantic en 2013 que Apple estaba interesado en pagar un cierto precio por un chip, pero estaba por debajo de lo que Intel pronosticó. Esa predicción resultó estar equivocada y Otellini expresó su arrepentimiento por no seguir su instinto. «Terminamos no ganarlo, o transmitiéndolo, dependiendo de cómo quieras verlo. Y el mundo hubiera sido muy diferente si lo hubiéramos hecho», dijo Otellini en esa entrevista. Pero los pasos erróneos estratégicos no eran solo los problemas. La compañía experimentó retrasos en la tecnología de procesos, abriendo la puerta a sus rivales como AMD que ofrecía chips potentes y eficientes para capturar a los clientes. Pat Gelsinger, quien se desempeñó como director de tecnología de Intel antes de regresar para liderar el fabricante de chips en 2021, centrado en un plan de giro ambicioso y costoso para la compañía. Estableció un objetivo en el que Intel desarrollaría cinco nuevos nodos de proceso de semiconductores en cuatro años. El gobierno federal otorgó a Intel miles de millones de dólares el año pasado para apoyar su expansión de fabricación de semiconductores en los Estados Unidos, pero las pérdidas netas de la compañía también se ampliaron. En 2024, el negocio de Foundry de Intel informó una pérdida operativa de $ 13.4 mil millones, casi el doble en comparación con la pérdida del año anterior, según su informe anual. «Gelsinger arrojó combustible sobre el incendio, porque comenzó a gastar dinero como loco para construir esta gran cantidad de capacidad de fabricación para negocios que no tenían», dijo Stacy Rasgon, un analista senior de los Estados Unidos. Gelsinger, quien anunció su retiro el año pasado antes de que Tan asumiera el cargo de director ejecutivo. Otro cambio ejecutivo de Turnaround PlanIntel se ha centrado en reducir los costos, incluso en torno al negocio de fundición de la compañía. Le dijo a los empleados en una nota la semana pasada que la compañía invirtió demasiado dinero sin suficiente demanda. Y Intel dijo que podría detenerse o suspender su próxima tecnología de proceso de fabricación de chips conocida como 14A si no puede conseguir un cliente «significativo». Si bien Intel ha sido eclipsado por algunos de sus rivales, la compañía sigue siendo un gran jugador en la industria de semiconductores.idc, que analizó los ingresos de semiconductores, dijo en 2024 Intel ocupó el tercer lugar detrás de Nvidia y Samsung. Se cayó al cuarto lugar detrás de SK Hynix, una compañía surcoreana que suministra chips de memoria, durante el primer trimestre de este año. Analysts no ven que Intel se va pronto. Y a medida que las compañías tecnológicas trabajan en implementar un nuevo hardware con AI, que también podría presentar otra oportunidad para Intel.alvin Nguyen, analista senior de Forrester, dijo que algunas de las preocupaciones sobre que Intel está en problemas podría «exagerarse». «Puede que no estén en la parte superior como lo fueron, pero que aún así son, finalmente, muy importantes para todas las industrias porque sus chips se usan en virtud de todos los lugares», dijo él.

El presidente Trump llegó a un acuerdo inusual con NVIDIA y micro dispositivos avanzados que permite a las compañías vender ciertas fichas a China a cambio de dar al gobierno de los Estados Unidos una reducción del 15% de esas ventas. Pero el acuerdo sin precedentes también ha planteado preocupaciones de los políticos y los expertos legales sobre si el acuerdo es legal y representaría una amenaza de seguridad nacional. Las preguntas también persisten exactamente cómo el acuerdo, que se anunció el lunes, funcionaría porque la Constitución de los Estados Unidos prohíbe los impuestos a las exportaciones, aunque algunos expertos dijeron que Trump podría encontrar una solución. El gobierno de los Estados Unidos podría recibir $ 3 mil millones de la división de ingresos si la demanda de China de NVIDIA H20 Chip, que es menos poderosa que el chip de inteligencia artificial de la compañía, alcanza $ 20 mil millones, según una nota de Bernstein Research. «Se vincula con el destino de este fabricante de chips de una manera muy particular a esta administración que es bastante rara», dijo Julia Powles, profesora y directora ejecutiva del Instituto de Tecnología de la UCLA, Law & Policy. Buscando a Curry Favor con la Administración Trump, que ha amenazado con imponer aranceles a las compañías semiconductores que no se comprometen a invertir en los Estados Unidos. Apple también enfrentó aranceles potenciales, pero se comprometió a invertir $ 100 mil millones más en fabricación de Estados Unidos después de que Trump criticó a la compañía por expandir la producción de iPhone en India. Trump también impuso restricciones en abril en torno a la exportación de ciertos chips de IA, incluidos H20 de NVIDIA y el MI308 de AMD, sobre las preocupaciones de seguridad nacional. Ha pedido la renuncia del presidente ejecutivo de Intel, Lip-Bu-Bu Tan, quien ha enfrentado un escrutinio por sus inversiones reportadas en empresas chinas, pero cambió su tono después de reunirse con el ejecutivo esta semana. Los legisladores democráticos y republicanos han criticado la idea de que las empresas tecnológicas deberían dividir sus ventas con el gobierno de los Estados Unidos a cambio de licencias de exportación que les permiten reanudar las ventas de chips en China. «Los controles de exportación son una defensa de primera línea para proteger nuestra seguridad nacional, y no debemos establecer un precedente que incentiva al gobierno para otorgar licencias para vender tecnología de China que mejorará sus capacidades de IA», dijo el representante John Moolenaar (republicano de Mich.), Dicho en un comunicado de AI. Raja Krishnamoorthi, (D-Ill.), Un miembro de clasificación de ese comité, dijo en un comunicado que el acuerdo plantea preguntas sobre su legalidad y cómo se utilizarán los fondos. «La administración no puede tratar simultáneamente las exportaciones de semiconductores como una amenaza de seguridad nacional y una oportunidad de ingresos», dijo. «Al poner un precio sobre nuestras preocupaciones de seguridad, señalamos a China y a nuestros aliados que los principios de seguridad nacional estadounidense son negociables para la tarifa correcta». La Casa Blanca no respondió preguntas sobre el acuerdo. La secretaria de prensa de la Casa Blanca, Karoline Leavitt, dijo a los periodistas el martes que «la legalidad de la misma, la mecánica de la misma, todavía está siendo solucionada por el Departamento de Comercio». El lunes, Trump defendió el acuerdo con Nvidia, afirmando que los chips H20 son «obsoletos» y menos poderosos que el chip Blackwell más alto de la compañía. En una conferencia de prensa, Trump dijo que se reunió con el CEO de NVIDIA, Jensen Huang, e inicialmente solicitó una división de ingresos del 20%, pero bajaron al 15%. «Negociamos un pequeño acuerdo», dijo Trump. «Así que está vendiendo un chip esencialmente viejo». Los comentarios de Trump se produjeron después de un informe del Financial Times durante el fin de semana de que NVIDIA y AMD pagarían el 15% de sus ingresos por chip de China al gobierno de los Estados Unidos. AMD no respondió a una solicitud de comentarios. Un portavoz de NVIDIA dijo en un comunicado que la compañía no ha enviado chips H20 a China durante meses, pero espera que la facilidad de las restricciones de exportación «permita que Estados Unidos compite en China y en todo el mundo». Estados Unidos no puede repetir 5G y perder el liderazgo de telecomunicaciones. La pila tecnológica de AI de Estados Unidos puede ser el estándar mundial si corremos «. Por lo tanto, por los Estados Unidos, los stakes son altos. Huang dijo en una entrevista de mayo con Stratechery, un boletín y podcast, que el mercado chino es de aproximadamente $ 50 mil millones al año. Restringir las ventas de chips H20 significa que la compañía se está alejando de las ganancias que podrían usarse para competir con China en la carrera para dominar la IA. Taylar Rajic, miembro asociado del Centro de Estudios Estratégicos e Internacionales, dijo que es escéptica de que las preocupaciones legales detengan el acuerdo porque no está claro quién demandaría. «No puedo identificar quién traería esa demanda hacia adelante», dijo. «No sería Nvidia porque son los que negociaron este acuerdo». Mientras tanto, los funcionarios chinos tienen sus propios temores de que los chips de Nvidia puedan tener capacidades de seguimiento de ubicación o cierre remoto, aunque la compañía ha negado esas acusaciones. «China obviamente tiene sus propias preocupaciones y sus propias consideraciones de seguridad nacional que quiere tener en cuenta», dijo Rajic. «Simplemente depende de si también quieren comprarlo o no».

El fabricante de chips Intel es la última compañía de tecnología que enfrenta la presión política del presidente Trump. El jueves, Trump pidió la renuncia inmediata del presidente ejecutivo de Intel, Lip-Bu-Bu Tan, quien tomó el timón en marzo para dar la vuelta a la asediada compañía. «El CEO de Intel está muy en conflicto y debe renunciar, de inmediato. No hay otra solución a este problema. ¡Gracias por su atención a este problema!» Trump escribió en su plataforma de redes sociales. Trump no dijo cuáles eran los conflictos en su cargo, pero sus comentarios se produjeron después de que el senador Tom Cotton (R-ARK) envió una carta a la junta de Intel, expresando preocupaciones de seguridad nacional sobre los lazos informados de Tan con las empresas chinas. Cotton citó un informe de Reuters que dijo que Tan ha invertido en más de 600 empresas chinas y algunas de ellas tienen vínculos con el ejército del país. El llamado de Trump para la renuncia de Tan se suma a una lista de problemas con los que Intel ya tiene que lidiar. La compañía de tecnología de 57 años, una vez que el fabricante de chips estadounidense más valioso, está tratando de mantenerse al día a medida que aumenta la carrera para dominar la inteligencia artificial. La compañía de Santa Clara, California, ha estado perdiendo dinero y ha visto caer el precio de sus acciones mientras se queda atrás de rivales como Nvidia y Advanced Micro Devices. El precio de las acciones del Intel se cerró a $ 19.77 el jueves, un 3%menos. La compañía dijo en un comunicado que su junta y TAN están «profundamente comprometidos con el avance de los intereses de seguridad nacionales y económicos de EE. UU. Y están haciendo importantes inversiones alineadas con la agenda de la primera primera agenda del Presidente de América». Trump dijo el miércoles durante un evento en el que Apple anunció una inversión adicional de $ 100 mil millones en los Estados Unidos que planea una tarifa sobre los tasas de los concuctores de Criticó a Intel. «Intel acaba de tomar las brasas. Fueron llevados a los limpiadores, francamente, y se mudaron a otros lugares, en particular Taiwán», dijo Trump en el evento. Intel, conocido por hacer de los «cerebros» que powernters, ha estado invirtiendo fuertemente en su negocio de fundición, enfrentando a Taiwan Semiconductor Manufacturing Co., que hace fichas para empresas como Apple y Nvidia. Durante la administración Biden, el Departamento de Comercio otorgó a Intel aproximadamente $ 8 mil millones para apoyar proyectos de fabricación y empaquetado avanzado en los Estados Unidos

Google Cloud anunció una nueva suscripción empresarial para Chrome y una serie de complementos de IA generativa para Google Workspace durante la conferencia Cloud Next ’24, celebrada en Las Vegas del 9 al 11 de abril. En general, Google Cloud está poniendo su IA generativa Gemini en coloque todo lo que pueda; por ejemplo, la empresa está apostando por proporcionar infraestructura Vertex AI para la IA y el hardware de otras empresas, como la nueva CPU Axion. Asistimos a una sesión informativa previa para echar un vistazo temprano a las nuevas funciones y herramientas, incluido un servicio de video generativo de IA para uso en marketing y comunicaciones internas. A continuación se ofrece un resumen de lo que consideramos las noticias empresariales más impactantes de Google Cloud Next. Chrome Enterprise Premium agrega controles de seguridad Los navegadores empresariales pueden ser una tendencia creciente. El año pasado, Gartner predijo que los navegadores creados específicamente teniendo en cuenta la seguridad y el soporte a nivel empresarial alcanzarían una adopción generalizada para 2030. Google está contribuyendo con Chrome Enterprise Premium. Este nivel empresarial agrega un nivel adicional de seguridad a Chrome, mejorándolo con: Controles empresariales para la aplicación de políticas y administración de actualizaciones y extensiones de software. Informes de eventos y dispositivos. Informes de seguridad forense. Controles de acceso contextuales. Amenazas y protección de datos. Chrome Enterprise Premium está disponible hoy, 9 de abril, en cualquier lugar donde se ofrezca Chrome. Cuesta $6 por usuario por mes. Axion es la primera CPU basada en Arm de Google Algunos servicios de Google Cloud, como BigQuery, pronto se ejecutarán en los procesadores Google Axion, la primera CPU basada en Arm personalizada de Google para centros de datos (Figura A). Google Cloud dijo que Axion muestra un rendimiento un 50% mejor que las máquinas virtuales comparables basadas en x86 de la generación actual. Las instancias de Google Compute Engine, Google Kubernetes Engine, Dataproc, Dataflow, Cloud Batch y más estarán disponibles más adelante en 2024. Figura A Los procesadores Google Axion están destinados a ejecutar cargas de trabajo en la nube en centros de datos. Imagen: Google Cloud Vertex AI se basará en la Búsqueda de Google A partir del 9 de abril, los modelos entrenados en Vertex AI se basarán en la Búsqueda de Google. Esto podría resultar controvertido dependiendo exactamente de qué datos se utilicen para la capacitación. La conexión a tierra de la IA es parte de la tendencia de recuperación de generación aumentada, que evita las «alucinaciones» al comparar la IA con información genuina. Google Cloud dice que la conexión a tierra proporcionará a los modelos creados en Vertex AI «información nueva y de alta calidad». Más noticias y consejos de Google Una gran cantidad de adiciones de IA para los productos de seguridad de Google Otros anuncios de Google Cloud se centraron en agregar Gemini a los productos de seguridad, una medida posiblemente destinada a competir con la integración completa de Copilot por parte de Microsoft en sus suites de seguridad. Gemini AI ahora estará disponible en Google Security Operations (Figura B) y Threat Intelligence. En particular, Gemini podrá ayudar con las investigaciones en Chronicle Enterprise y Chronicle Enterprise Plus a partir de finales de abril. A partir del 9 de abril, los analistas de seguridad pueden utilizar Gemini para hablar en lenguaje natural con el software de inteligencia de amenazas de Mandiant. Figura B Un ejemplo del uso de Gemini en Operaciones de seguridad para investigar incidentes y alertas con chat conversacional en Chronicle Enterprise o Enterprise Plus. Imagen: Google Cloud Gemini en Security Command Center recibió un impulso de Gemini; A partir del 9 de abril, las funciones de IA en la vista previa pueden buscar amenazas basándose en indicaciones de lenguaje natural y resumir alertas y rutas de ataque. «Los ingenieros de detección pueden crear detecciones y guías con menos esfuerzo, y los analistas de seguridad pueden encontrar respuestas rápidamente con resúmenes inteligentes y búsquedas en lenguaje natural», dijo Ronald Smalley, vicepresidente senior de Operaciones de Ciberseguridad de Fiserv, en un comunicado de prensa de Google Cloud. «Esto es fundamental ya que los equipos de SOC continúan administrando volúmenes de datos cada vez mayores y necesitan detectar, validar y responder a eventos más rápido». Gemini Cloud Assist en los servicios de seguridad de Google Cloud ahora incluirá las siguientes capacidades impulsadas por IA en versión preliminar: Identidad y acceso recomendaciones de manejo para mejorar la postura IAM. Asistencia con la creación de claves de cifrado. Sugerencias sobre cómo implementar la protección informática confidencial. Cree videos con IA y más en las nuevas ofertas de Google Workspace Google presentó una nueva plataforma Workspace llamada Google Vids (Figura C), con la cual la IA generativa puede ayudar a los empleados a crear videos promocionales o informativos. Figura C Un usuario proporciona un guión como mensaje para darle a Google Vids una idea de lo que quiere que diga su video. Imagen: Google Cloud Primero, Google Vids creará un guión gráfico que el usuario podrá personalizar. Desde allí, Google Vids puede crear el video y agregar voz en off con voces AI preestablecidas o audio personalizado. Google Vids será una plataforma completamente nueva que convivirá junto con Docs Sheets y Slides. Se podrá acceder a los vídeos a través de Workspace Labs en junio. Más anuncios de Google Workspace Una herramienta de inteligencia artificial para resumir y traducir reuniones, que costará 10 dólares por usuario al mes. Clasificación y protección de archivos del complemento AI Security, que costará 10 dólares por usuario al mes. En Gmail, la IA habilitará las herramientas «Pulir mi borrador» y «Ayúdame a escribir», la última de las cuales se puede utilizar mediante comandos de voz en el móvil. Google Gemini llega a Chat y Docs para crear imágenes de portada. Vertex AI se integrará en Google Workspace. Extensión de HubSpot para Gemini para Google Workspace. Gemini 1.5 Pro llega a Vertex AI y Data Cloud Google anunció muchos cambios en el portafolio de Data Cloud en bases de datos y análisis de datos. La más importante fue la disponibilidad de Gemini 1.5 Pro en Vertex AI, que permite una ventana de contexto de un millón de tokens. VER: Todo lo que necesitas saber sobre Google Cloud Platform. (TechRepublic) Google continúa ampliando las integraciones y capacidades de Gemini: en la vista previa de hoy están Gemini en Looker y Gemini en BigQuery. Las nuevas características adicionales de BigQuery disponibles hoy en vista previa o vista previa privada incluyen información sobre documentos y audio de Vertex AI, incrustaciones y coincidencias de vectores, y más. Otros anuncios (en vista previa a menos que se indique lo contrario) incluyen: Google Gemini en bases de datos. Soporte vectorial e integración de LangChain en Bases de Datos. Soporte de vectores, soporte de lenguaje natural y gestión de puntos finales de modelos para AlloyDB. Acceso aislado a cargas de trabajo desde motores de análisis en Bigtable Data Boost. Capacidades ampliadas de recuperación ante desastres y mantenimiento en menos de dos segundos (en disponibilidad general) en Cloud SQL. Nuevo tamaño de instancia para Memorystore (en disponibilidad general) y compatibilidad con dos nuevas opciones de persistencia en Memorystore (en versión preliminar). Claves de cifrado administradas por el cliente en Cloud Firestore. TPU v5p entra en disponibilidad general El acelerador de IA TPU v5p de Google ahora está en disponibilidad general, lo que permite a las organizaciones usarlo para inferencia y capacitación de IA. Además, Google Kubernetes Engine ahora es compatible con TPU v5p. Avanzando en la hipercomputación y la computación en la nube, Google Cloud trabajará con el hardware de NVIDIA para impulsar la infraestructura de capacitación en inteligencia artificial de Google. Los anuncios del grupo de infraestructura en la nube incluyeron: A3 Mega VM con tecnología de GPU NVIDIA H100 Tensor Core para entrenamiento de IA a gran escala, disponibles de forma generalizada en mayo. Hyperdisk ML, un nuevo servicio de almacenamiento en bloque para cargas de trabajo de inferencia/servicio de IA, ya está disponible en versión preliminar. JetStream, un motor de inferencia de rendimiento y memoria optimizado para la formación LLM, está disponible hoy en GitHub. Dynamic Workload Scheduler, un servicio para administrar recursos en Google Cloud para optimizar las cargas de trabajo de IA según la capacidad informática, ahora está en versión preliminar. Duet AI para desarrolladores ahora es Gemini Code Assist. Competidores de Google Cloud El amplio catálogo de productos de Google significa que tiene muchos competidores en diferentes sectores. En el ecosistema de IA generativa y en el soporte empresarial en particular, compite y a menudo interopera con Copilot AI, AWS, IBM y SAP de Microsoft. El chip Axion en particular podría ayudar a Google a ingresar al espacio de chips para centros de datos dominado por Amazon y NVIDIA. TechRepublic cubre Google Cloud Next ’24 de forma remota.

Después de anunciar por primera vez la existencia del acelerador de IA Gaudi 3 el año pasado, Intel está listo para poner el chip en manos de los OEM en el segundo trimestre de 2024. Intel anunció esta y otras noticias, incluida una nueva marca Xeon 6 y un estándar Ethernet abierto para IA. cargas de trabajo, en una sesión informativa previa celebrada el 1 de abril antes de la conferencia Intel Vision, que se llevará a cabo del 8 al 9 de abril en Phoenix, Arizona. El acelerador de IA Gaudi 3 se enviará a Dell, Hewlett Packard Enterprise, Lenovo y Supermicro. El Gaudi 3 se lanzará con Dell, Hewlett Packard Enterprise, Lenovo y Supermicro como socios OEM. Intel Gaudi 3 estará disponible a través de proveedores en tres factores de forma: tarjeta intermedia, placa base universal o PCle CEM. Gaudi 3 tiene un tiempo de entrenamiento de modelos de lenguajes grandes un 40% más rápido en comparación con el chip H100 AI de NVIDIA y una inferencia en LLM un 50% más rápida en comparación con el NVIDIA H100, dijo Intel. Gaudi 3 puede enfrentarse cara a cara con el chip acelerador de IA recientemente anunciado por NVIDIA, Blackwell. Gaudi 3 es «altamente competitivo», afirmó Jeff McVeigh, vicepresidente corporativo y director general del Grupo de Ingeniería de Software de Intel. McVeigh señaló que aún no ha sido posible realizar pruebas en el mundo real para los dos productos. La nueva marca Xeon 6 llegará en el segundo trimestre. Los procesadores Xeon 6, que vienen en las dos variantes de Performance-core y Efficient-core, se enviarán pronto. Los procesadores E-core se enviarán en el segundo trimestre de 2024, y poco después los procesadores P-core. Las dos variantes de los procesadores Xeon 6 comparten la misma base de plataforma y pila de software. El núcleo Performance está optimizado para cargas de trabajo de IA y de computación intensiva, mientras que el núcleo Efficient está optimizado para la eficiencia en las mismas cargas de trabajo. El procesador Intel Xeon 6 con E-core muestra una mejora de rendimiento por vatio de 2,4 veces en comparación con las generaciones anteriores y una mejora de rendimiento por bastidor de 2,7 veces en comparación con las generaciones anteriores. El procesador Xeon 6 muestra un marcado ahorro de energía en comparación con el procesador Intel Xeon de segunda generación debido a que necesita menos bastidores de servidores, lo que supone una reducción de energía de hasta 1 megavatio. La tarjeta de interfaz de red admite el estándar abierto de Internet para cargas de trabajo de IA. Como parte del esfuerzo de Intel para proporcionar una amplia gama de infraestructura de IA, la compañía anunció una tarjeta de interfaz de red de IA para adaptadores de red Intel Ethernet y IPU Intel. Las tarjetas de interfaz de red de IA, que ya utiliza Google Cloud, proporcionarán una forma segura de descargar funciones como almacenamiento, redes y gestión de contenedores y gestionar la infraestructura de IA, dijo Intel. La intención es poder entrenar y ejecutar inferencias sobre los modelos de IA generativa cada vez más grandes que Intel predice que las organizaciones querrán implementar en todo Ethernet. Intel está trabajando con el Consorcio Ultra Ethernet para crear un estándar abierto para redes de IA a través de Ethernet. Se espera que las tarjetas de interfaz de red de IA estén disponibles en 2026. Una estrategia de sistemas escalables de amplio alcance tiene como objetivo facilitar la adopción de la IA. Para prepararse para lo que la compañía predice que será el futuro de la IA, Intel planea implementar una estrategia de sistemas escalables. para empresas. «Queremos que sea abierto y que las empresas tengan opciones en hardware, software y aplicaciones», dijo Sachin Katti, vicepresidente senior y gerente general de Network and Edge Group de Intel, en la sesión informativa previa. Para lograrlo, la estrategia de sistemas escalables proporciona productos Intel para todos los segmentos de IA dentro de la empresa: hardware, software, marcos y herramientas. Intel está trabajando con una variedad de socios para hacer realidad esta estrategia, incluido: Google Cloud. Tales. Cohesidad. NAVER. Bosco. Ola/Kutrim. NielsenIQ. Buscador. FIB. Grupo CtrlS. Aterrizando IA. Roboflujo. Intel predice un futuro de agentes y funciones de IA. Katti dijo en el informe previo que las empresas se encuentran en una era de copilotos de IA. Luego podría venir una era de agentes de IA, que puedan coordinar otras IA para realizar tareas de forma autónoma, seguida de una era de funciones de IA. El aumento de las funciones de IA podría significar que grupos de agentes asuman el trabajo de un departamento completo, dijo Sachin. VER: Articul8, creadores de una plataforma de software de inteligencia artificial generativa, se separó de Intel en enero. (TechRepublic) Competidores de Intel Intel está tratando de diferenciarse de sus competidores centrándose en la interoperabilidad en el ecosistema abierto. Intel compite en el espacio de los chips de IA con: NVIDIA, que anunció el chip Blackwell de próxima generación en marzo de 2024. AMD, que en febrero de 2024 anunció una nueva solución arquitectónica para la inferencia de IA basada en procesadores AMD Ryzen Embedded. Intel compite por el dominio en la fabricación de chips con Taiwan Semiconductor Manufacturing Co., Samsung, IBM, Micron Technologies, Qualcomm y otros. TechRepublic cubre Intel Vision de forma remota.

El término «copiloto» para los asistentes de IA parece estar en todas partes en el software empresarial actual. Como muchas cosas en la industria de la IA generativa, la forma en que se usa la palabra está cambiando. A veces se escribe con mayúscula y otras no. La elección de Copilot por parte de GitHub como marca fue el primer uso importante, seguido de que Microsoft nombrara a su asistente insignia de IA Copilot. Luego, el término copiloto rápidamente se volvió genérico. En el uso común, un copiloto de IA es un asistente de IA generativa, generalmente un modelo de lenguaje grande entrenado para una tarea específica. La confusión sobre un término podría llevar a que algunos clientes no sepan si lo que están adquiriendo es un producto de Microsoft, por ejemplo. Pero Microsoft no parece estar buscando apropiarse de la palabra copiloto, como la usan muchas otras compañías. El término copiloto se originó en el vuelo e implica una mano derecha competente para un profesional altamente calificado. Esto es lo que necesita saber sobre algunas de las muchas variedades de copiloto de IA. ¿Qué es el copiloto de Microsoft? Microsoft Copilot es un término general para una variedad de productos de IA generativa y chatbot que ahora están disponibles en todo el software de productividad de Microsoft. Para los usuarios empresariales, tenemos una guía para diferenciar las diversas iteraciones de Microsoft Copilot y las nuevas funciones e integraciones de Copilot. Microsoft utiliza dos construcciones para los nombres de productos Copilot: «en» o «para». En la hoja de trucos de TechRepublic sobre Microsoft Copilot, tenga en cuenta Copilot para seguridad y Copilots para finanzas, ventas y servicios, que probablemente se compren por separado para usos o departamentos específicos. Este es un caso interesante en el que Microsoft usa su propia marca de dos maneras a la vez (incluso después de todo el cambio de nombre de Copilot): los Copilots ofrecen capacidades muy similares, pero más específicas de la industria, en comparación con los Copilots en, por ejemplo. Por ejemplo, Copilot en Word puede ayudar con cualquier tarea de escritura, mientras que Copilot for Security se integra con productos de seguridad específicos. VER: Copilot en Bing solía llamarse Bing Chat antes de que Microsoft unificara un poco sus marcas. (TechRepublic) ¿Qué es GitHub Copilot? GitHub lanzó su producto Copilot en 2021 (GitHub ya había sido adquirido por Microsoft en ese momento). GitHub Copilot genera código basado en el código existente de un desarrollador; Está pensado como una versión AI de la programación en pareja. El GitHub Copilot original se construyó sobre OpenAI Codex, una variante del entonces actual GPT-3. GitHub cerró el círculo de la IA generativa con la incorporación de un chatbot a su versión más reciente, GitHub Copilot X. Más cobertura de IA de lectura obligada Microsoft Copilot vs GitHub Copilot Microsoft Copilot y GitHub Copilot tienen diferentes casos de uso principales. GitHub Copilot es específicamente para codificar, mientras que Microsoft Copilot se integra con una gran cantidad de software empresarial diferente. GitHub Copilot lee código, no lenguaje natural, y lo integra en un editor de código; Microsoft Copilot utiliza lenguaje natural y se integra con una variedad de productos de Microsoft. Por otro lado, Microsoft Copilot se puede utilizar para escribir código en algunos casos, como en Power Pages cuando se integra con Visual Studio Code. Microsoft Copilot para empresas comienza en $30,00 por usuario por mes con una licencia de Microsoft 365 Business Standard o Microsoft 365 Business Premium. GitHub Copilot comienza en $10 por usuario por mes. ¿Cuáles son otros productos Copilot? Salesforce no es un defensor de Microsoft de Copilot como marca. Einstein Copilot, lanzado en febrero de 2024, funciona en las ofertas de software como servicio de gestión de relaciones con clientes, inteligencia artificial y nube de datos de Salesforce. La empresa de software de automatización de procesos empresariales Appian llama Copilot a su compañero de IA generativa. Una empresa de software de prospección de ventas se llamó Copilot AI, pero no vende un robot de IA generativa; en cambio, ofrece respuestas predictivas a las conversaciones y campañas de LinkedIn. Hay muchas más empresas que utilizan Copilot para indicar un impulso generativo de IA para sus servicios. VER: Hay varias razones por las que las empresas o los usuarios individuales podrían querer desactivar las funciones de Microsoft Copilot que vienen con Windows 11. (TechRepublic) ¿Se puede utilizar copiloto como término genérico? Por ahora, “copilot” es una palabra flexible para productos de chatbot de IA genéricos y específicos de marca para usos comerciales específicos. Por ejemplo, Microsoft Copilot es un copiloto. A qué se refiere «copiloto» o cómo se denomina un chatbot de IA puede ser diferente según la organización. Los usos comunes del término indican el período del Salvaje Oeste de la IA en el que nos encontramos, y muestran que los profesionales todavía están trabajando en formas de utilizar la IA generativa para los negocios y que la IA generativa se está asentando en un papel de «asistente» en forma de chatbots personalizados. a productos y aplicaciones específicos. Probablemente verá la palabra copiloto escrita en minúsculas para indicar la versión genérica de los asistentes de IA. Las personas que crean la infraestructura Copilot en mayúsculas también han adoptado la versión genérica del término: el CEO de NVIDIA, Jensen Huang, utilizó copiloto como término genérico en NVIDIA GTC, al igual que muchas empresas en la sala de exposiciones de la conferencia. Otras empresas parecen mantenerse alejadas del término: IBM llama Asistente a su compañero de IA watsonx, al igual que Databricks con su Asistente Databricks.

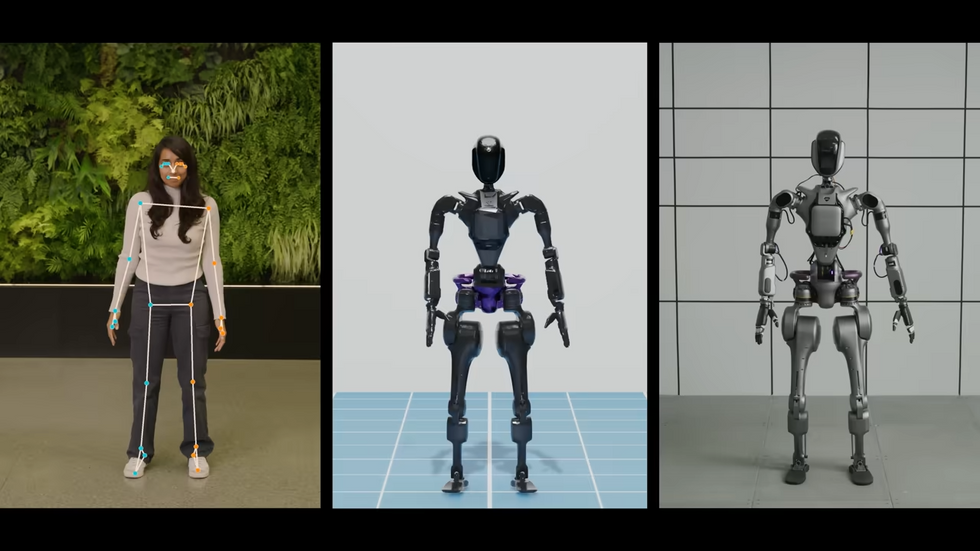

Video Friday es tu selección semanal de increíbles videos de robótica, recopilados por tus amigos de IEEE Spectrum Robotics. También publicamos un calendario semanal de los próximos eventos de robótica para los próximos meses. Envíenos sus eventos para su inclusión.Eurobot Open 2024: 8–11 de mayo de 2024, LA ROCHE-SUR-YON, FRANCIAICRA 2024: 13–17 de mayo de 2024, YOKOHAMA, JAPÓNRoboCup 2024: 17–22 de julio de 2024, EINDHOVEN, PAÍSES BAJOSDisfrute de los videos de hoy !Vea el viaje de NVIDIA desde ser pionero en hardware avanzado para vehículos autónomos y herramientas de simulación hasta percepción y manipulación aceleradas para robots móviles autónomos y brazos industriales, culminando en la próxima ola de IA de vanguardia para robots humanoides.[ NVIDIA ]En la versión 4.0, mejoramos las habilidades de locomoción de Spot gracias al poder del aprendizaje por refuerzo. Paul Domanico, ingeniero en robótica de Boston Dynamics, habla de cómo el enfoque híbrido de Spot de combinar el aprendizaje por refuerzo con el control predictivo del modelo crea un robot aún más estable en los entornos más antagónicos.[ Boston Dynamics ]Estamos entusiasmados de compartir nuestro último progreso en la enseñanza de habilidades de propósito general a los EVE. Todo en el video es autónomo, todo a velocidad 1X, todo controlado con un único conjunto de pesos de red neuronal.[ 1X ]Lo que encuentro interesante acerca de que el Unitree H1 haga un giro de pie es dónde decide poner sus piernas.[ Unitree ]En la Exposición MODEX de marzo de 2024, Pickle Robot demostró cómo recoger carga de una pila aleatoria similar a lo que se ve en un remolque de camión desordenado después de haber rebotado durante muchos kilómetros de carretera. Las pilas de cajas nunca volvieron a ser las mismas y la manifestación se realizó en vivo frente a una multitud de espectadores 25 veces durante 4 días. Ningún otro sistema robótico de descarga de contenedores o remolques ha demostrado todavía esta capacidad de recoger pilas no estructuradas.[ Pickle ]RunRu es un robot parecido a un coche, un coche parecido a un robot, con autonomía, sociabilidad y operatividad. Se trata de un nuevo tipo de vehículo personal que pretende crear una relación “Jinba-Ittai” con sus pasajeros, que no sólo son siempre asertivos, sino que a veces también se quejan.[ ICD-LAB ]Verdie fue al GTC este año y se ganó el corazón de la gente, pero tal vez no el de los otros robots.[ Electric Sheep ]“DEEPRobotics AI+” combina capacidades de IA con sistemas de software robóticos para impulsar continuamente la inteligencia incorporada. El logro mostrado es el resultado del entrenamiento de un nuevo sistema de software e inteligencia artificial.[ DEEP Robotics ]Si desea recopilar datos para el agarre del robot, usar Stretch y un par de pinzas es lo más asequible posible.[ Hello Robot ]La verdadera razón por la que las piernas de Digit miran hacia atrás es para que no se golpee las espinillas al sacar las GPU del horno. Mientras tanto, algunos de nosotros podemos hornear nuestras GPU sin siquiera necesitar un horno.[ Agility ]P1 es el innovador robot bípedo de pie puntiagudo de LimX Dynamics, que sirve como una plataforma importante para el desarrollo sistemático y las pruebas modulares del aprendizaje por refuerzo. Se utiliza para avanzar en la investigación y la iteración de las habilidades básicas de locomoción bípeda. El éxito de P1 en la conquista del terreno forestal es un testimonio de la investigación y el desarrollo sistemático de LimX Dynamics en el aprendizaje por refuerzo.[ LimX ]Y ahora, esto.[ Suzumori Endo Lab ]Cocinar en las cocinas es divertido. ¡PERO hacerlo en colaboración con dos robots es aún más satisfactorio! Presentamos MOSAIC, un marco modular que coordina múltiples robots para colaborar estrechamente y cocinar con los humanos a través de la interacción del lenguaje natural y un depósito de habilidades.[ Cornell ]neoDavid es un humanoide robusto con diestras habilidades de manipulación, desarrollado en DLR. El objetivo principal en el desarrollo de neoDavid es acercarse lo más posible a las capacidades humanas, especialmente en términos de dinámica, destreza y robustez.[ DLR ]Bienvenido a nuestra serie de videos destacados para clientes donde mostramos algunos de los robots notables en los que nuestros clientes han estado trabajando. En este episodio, mostramos tres UGV de Clearpath Robotics que nuestros clientes utilizan para crear asistentes robóticos para tres aplicaciones diferentes.[ Clearpath ]Este vídeo presenta la nueva mano robótica de tres dedos de KIMLAB, que cuenta con sensores táctiles suaves para mejorar las capacidades de agarre. Aprovechando materiales de impresión 3D rentables, garantiza robustez y eficiencia operativa.[ KIMLAB ]Varios enfoques de planificación conscientes de la percepción han intentado mejorar la precisión de la estimación del estado durante las maniobras, mientras que a menudo se ha pasado por alto la compatibilidad de características entre marcos, un factor crucial que influye en la precisión de la estimación. En este artículo, presentamos APACE, un marco de generación de trayectorias ágil y consciente de la percepción para vuelos agresivos con quadrotores, que tiene en cuenta la compatibilidad de características durante la planificación de trayectorias.[ Paper ] a través de [ HKUST ]En este vídeo, vemos a Samuel Kunz, el piloto del equipo RSL Assistance Robot Race de ETH Zurich, mientras participa en los CYBATHLON Challenges 2024. Samuel completó las cuatro tareas designadas: recuperar un paquete de un buzón, usar un cepillo de dientes, colgar una bufanda en un tendedero y vaciar un lavavajillas, con la ayuda de un robot asistente. Logró una puntuación perfecta de 40 sobre 40 puntos y consiguió el primer puesto en la carrera, completando las tareas en 6,34 minutos.[ CYBATHLON ]Florian Ledoux es un fotógrafo de vida silvestre con un profundo amor por el Ártico y su vida silvestre. Usando el Mavic 3 Pro, pisa el hielo listo para capturar la belleza pura y las historias de este lugar frío y remoto.[ DJI ]

Source link

Con el anuncio de NVIDIA de AI Enterprise 5.0 y NVIDIA Inference Microservices en la conferencia GTC, el CEO Jensen Huang planea comenzar una era para hacer que la implementación de AI empresarial sea más fácil y más aplicable que nunca, posiblemente mientras cambia la forma principal en que las personas interactúan con las computadoras. La idea de controlar y programar computadoras solo con indicaciones es similar a lo que Humane ha propuesto con su Ai Pin basado en indicaciones, pero Huang la extiende a los desarrolladores y TI, así como a los consumidores: “El trabajo de la computadora es no requerir C++ para será útil”, afirmó Huang durante la sesión de preguntas y respuestas de prensa de NVIDIA GTC celebrada el 19 de marzo en San José, California (Figura A). Figura A El director ejecutivo de NVIDIA, Jensen Huang, habla durante una sesión de preguntas y respuestas con la prensa durante el NVIDIA GTC en San José, California, el 19 de marzo. Imagen: Megan Crouse/TechRepublic El director ejecutivo de NVIDIA, Jensen Huang, habla durante una sesión de preguntas y respuestas con la prensa durante el NVIDIA GTC en San José, California, el 19 de marzo. Imagen: Megan Crouse/TechRepublic Huang: La ingeniería rápida está transformando la programación Cuando se le preguntó si la programación seguirá siendo una habilidad útil en la era de las indicaciones generativas de IA, Huang dijo: «Creo que la gente debería aprender todo tipo de habilidades» y comparó el código. hasta hacer malabares, tocar el piano o aprender cálculo. Sin embargo, Huang dijo: «La programación no será esencial para que usted sea una persona exitosa». VER: Huang anunció una amplia gama de productos NVIDIA para centros de datos, inteligencia artificial empresarial, criptografía y más durante el discurso de apertura de la conferencia GTC. (TechRepublic) La IA generativa, dijo Huang, está “cerrando la brecha tecnológica. No es necesario ser programador de C++ para tener éxito”, afirmó. “Solo hay que ser un ingeniero rápido. ¿Y quién no puede ser un ingeniero puntual? Cuando mi esposa me habla, rápidamente me manipula. … Todos necesitamos aprender a incitar a las IA, pero eso no es diferente a aprender a incitar a los compañeros de equipo”. Huang continuó diciendo: «Pero si alguien quiere aprender a hacerlo (programar), que lo haga porque estamos contratando programadores». PREMIUM: aprenda cómo convertirse en un ingeniero rápido en esta descarga Premium de TechRepublic La ingeniería rápida es una habilidad que cambia rápidamente. ¿La ingeniería rápida reemplazará la programación tradicional cuando se trata de crear IA generativa a partir de IA generativa como sugirió Huang? «No dejaría mi trabajo diario todavía para convertirme en un ingeniero rápido», dijo Chirag Dekate, analista de Gartner, en una llamada a TechRepublic el 19 de marzo. «Desafortunadamente, el mercado se está corrigiendo excesivamente». Y el mercado se está sobrecorregindo ante un aumento en la demanda de lo que solía ser la ingeniería rápida. En una industria que cambia rápidamente, optimizar las indicaciones para lograr que una IA genere el texto correcto puede que ya no sea la forma en que se realiza la ingeniería de indicaciones de IA; en cambio, las indicaciones pueden ser multimodales. Los NIM son notables, dijo Dekate, porque encajan perfectamente la IA generativa en el contexto de multinube híbrida en el que operan muchas empresas. «Lo que NVIDIA está construyendo ahora es una base para las empresas nativas de IA de próxima generación, donde donde quiera que vayan las empresas experimentarán NIM», dijo. Sin embargo, es posible que NVIDIA no sea la empresa que haga realidad la transformación. Dekate señaló a Cognition AI, que la semana pasada presentó a Devin, su “ingeniero de software de IA”, como una señal de que la forma en que se realiza la ingeniería de software puede cambiar en el futuro. Más cobertura de IA de lectura obligada No importa qué nombre termine en el software más común, Dekate dijo que la forma en que los desarrolladores interactúan con la IA generativa cambiará rápidamente. «El ritmo de innovación de la IA generativa continúa acelerándose», afirmó Dekate. “Lo más probable es que no interactuemos con ninguno de estos modelos utilizando nuestras percepciones heredadas. Me refiero a tecnología de hace tres o seis meses como legado. La IA generativa cambia así de rápido”. David Nicholson, director de investigación de The Futurum Group, dijo a TechRepublic por correo electrónico que en un futuro de IA generativa «una instalación con lenguaje humano se convierte en una habilidad informática importante». “Tu título en inglés (o) historia o derecho de repente te ayuda a convertirte en un ingeniero rápido, pero una especialización en ciencias de la computación nunca estará de más”, escribió Nicholson. “No es una exageración de NVIDIA. Es verdaderamente una revolución”. Descargo de responsabilidad: NVIDIA pagó mi pasaje aéreo, alojamiento y algunas comidas para el evento NVIDIA GTC que se llevó a cabo del 18 al 21 de marzo en San José, California.

La plataforma GPU más nueva de NVIDIA es Blackwell (Figura A), que empresas como AWS, Microsoft y Google planean adoptar para la IA generativa y otras tareas informáticas modernas, anunció el CEO de NVIDIA, Jensen Huang, durante el discurso de apertura en la conferencia NVIDIA GTC el 18 de marzo en San José, California. Figura A La arquitectura NVIDIA Blackwell. Imagen: Los productos basados en NVIDIA Blackwell ingresarán al mercado de los socios de NVIDIA en todo el mundo a fines de 2024. Huang anunció una larga lista de tecnologías y servicios adicionales de NVIDIA y sus socios, hablando de la IA generativa como solo una faceta de la computación acelerada. «Cuando te aceleras, tu infraestructura son las GPU CUDA», dijo Huang, refiriéndose a CUDA, la plataforma informática paralela y el modelo de programación de NVIDIA. «Y cuando eso sucede, es la misma infraestructura que para la IA generativa». Blackwell permite el entrenamiento y la inferencia de modelos de lenguaje grandes. La plataforma Blackwell GPU contiene dos matrices conectadas por una interconexión de chip a chip de 10 terabytes por segundo, lo que significa que cada lado puede funcionar esencialmente como si «las dos matrices pensaran que es un solo chip», dijo Huang. Tiene 208 mil millones de transistores y se fabrica utilizando el proceso TSMC 4NP de 208 mil millones de NVIDIA. Cuenta con un ancho de banda de memoria de 8 TB/S y 20 pentaFLOPS de rendimiento de IA. Para las empresas, esto significa que Blackwell puede realizar entrenamiento e inferencia para modelos de IA escalando hasta 10 billones de parámetros, dijo NVIDIA. Blackwell se ve reforzado por las siguientes tecnologías: La segunda generación de TensorRT-LLM y NeMo Megatron, ambas de NVIDIA. Marcos para duplicar el tamaño de cálculo y modelo en comparación con el motor transformador de primera generación. Computación confidencial con protocolos de cifrado de interfaz nativos para privacidad y seguridad. Un motor de descompresión dedicado para acelerar consultas de bases de datos en análisis de datos y ciencia de datos. En cuanto a la seguridad, Huang dijo que el motor de confiabilidad “realiza una autoprueba, una prueba dentro del sistema, de cada bit de memoria en el chip Blackwell y de toda la memoria conectada a él. Es como si enviáramos el chip Blackwell con su propio probador”. Los productos basados en Blackwell estarán disponibles a través de proveedores de servicios de nube asociados, empresas del programa NVIDIA Cloud Partner y nubes soberanas seleccionadas. La línea de GPU Blackwell sigue a la línea de GPU Grace Hopper, que debutó en 2022 (Figura B). NVIDIA dice que Blackwell ejecutará IA generativa en tiempo real en LLM de billones de parámetros a un costo 25 veces menor y un consumo de energía menor que la línea Hopper. Figura B El director ejecutivo de NVIDIA, Jensen Huang, muestra las GPU Blackwell (izquierda) y Hopper (derecha) en NVIDIA GTC 2024 en San José, California, el 18 de marzo. Imagen: Megan Crouse/TechRepublic El superchip NVIDIA GB200 Grace Blackwell conecta varias GPU Blackwell junto con el Blackwell GPUs, la compañía anunció el superchip NVIDIA GB200 Grace Blackwell, que vincula dos GPU NVIDIA B200 Tensor Core a la CPU NVIDIA Grace, proporcionando una nueva plataforma combinada para la inferencia LLM. El Superchip NVIDIA GB200 Grace Blackwell se puede vincular con las plataformas Ethernet NVIDIA Quantum-X800 InfiniBand y Spectrum-X800 recientemente anunciadas por la compañía para velocidades de hasta 800 GB/S. El GB200 estará disponible en NVIDIA DGX Cloud y a través de instancias de AWS, Google Cloud y Oracle Cloud Infrastructure a finales de este año. El nuevo diseño de servidor mira hacia modelos de IA de billones de parámetros El GB200 es un componente del recientemente anunciado GB200 NVL72, un diseño de servidor a escala de rack que incluye 36 CPU Grace y 72 GPU Blackwell para 1,8 exaFLOP de rendimiento de IA. NVIDIA espera posibles casos de uso para LLM masivos de billones de parámetros, incluida la memoria persistente de conversaciones, aplicaciones científicas complejas y modelos multimodales. El GB200 NVL72 combina la quinta generación de conectores NVLink (5000 cables NVLink) y el superchip GB200 Grace Blackwell para obtener una enorme cantidad de potencia informática que Huang llama «un sistema de IA exoflops en un solo bastidor». «Eso es más que el ancho de banda promedio de Internet… básicamente podríamos enviar todo a todo el mundo», dijo Huang. «Nuestro objetivo es reducir continuamente el coste y la energía (están directamente relacionados entre sí) de la informática», afirmó Huang. Para enfriar el GB200 NVL72 se necesitan dos litros de agua por segundo. La próxima generación de NVLink ofrece una arquitectura de centro de datos acelerada. La quinta generación de NVLink proporciona un rendimiento bidireccional de 1,8 TB/s por comunicación GPU entre hasta 576 GPU. Esta iteración de NVLink está pensada para utilizarse en los LLM complejos más potentes disponibles en la actualidad. «En el futuro, los centros de datos serán considerados como una fábrica de inteligencia artificial», dijo Huang. Presentación de los microservicios de inferencia de NVIDIA Otro elemento de la posible «fábrica de IA» es el microservicio de inferencia de NVIDIA, o NIM, que Huang describió como «una nueva forma de recibir y empaquetar software». Los NIM de NVIDIA son microservicios que contienen API, código específico de dominio, motores de inferencia optimizados y tiempo de ejecución empresarial necesarios para ejecutar IA generativa. Estos microservicios nativos de la nube se pueden optimizar según la cantidad de GPU que utiliza el cliente y se pueden ejecutar en la nube o en un centro de datos propio. Los NIM permiten a los desarrolladores utilizar API, NVIDIA CUDA y Kubernetes en un solo paquete. VER: Python sigue siendo el lenguaje de programación más popular según el índice TIOBE. (TechRepublic) Los NIM aprovechan la IA para crear IA, simplificando parte del trabajo pesado, como la inferencia y la capacitación, necesarios para crear chatbots. A través de bibliotecas CUDA de dominio específico, los NIM se pueden personalizar para industrias muy específicas, como la atención médica. En lugar de escribir código para programar una IA, dijo Huang, los desarrolladores pueden “reunir un equipo de IA” que trabajen en el proceso dentro del NIM. «Queremos construir chatbots (copilotos de IA) que funcionen junto con nuestros diseñadores», dijo Huang. Los NIM estarán disponibles a partir del 18 de marzo. Los desarrolladores pueden experimentar con los NIM sin costo alguno y ejecutarlos a través de una suscripción a NVIDIA AI Enterprise 5.0. Los NIM están disponibles en Amazon SageMaker, Google Kubernetes Engine y Microsoft Azure AI, y pueden interoperar con los marcos de IA Deepset, LangChain y LlamaIndex. Nuevas herramientas lanzadas para NVIDIA AI Enterprise en la versión 5.0 NVIDIA lanzó la versión 5.0 de AI Enterprise, su plataforma de implementación de IA destinada a ayudar a las organizaciones a implementar productos de IA generativa para sus clientes. 5.0 de NVIDIA AI Enterprise agrega lo siguiente: NIM. Microservicios CUDA-X para una amplia variedad de casos de uso de IA acelerada por GPU. AI Workbench, un conjunto de herramientas para desarrolladores. Soporte para la plataforma Red Hat OpenStack. Soporte ampliado para nuevas GPU NVIDIA, hardware de red y software de virtualización. El operador de modelo de lenguaje grande de generación aumentada de recuperación de NVIDIA se encuentra ahora en acceso temprano para AI Enterprise 5.0. AI Enterprise 5.0 está disponible a través de Cisco, Dell Technologies, HP, HPE, Lenovo, Supermicro y otros proveedores. Otros anuncios importantes de NVIDIA en GTC 2024 Huang anunció una amplia gama de nuevos productos y servicios en computación acelerada e inteligencia artificial generativa durante el discurso de apertura de NVIDIA GTC 2024. NVIDIA anunció cuPQC, una biblioteca utilizada para acelerar la criptografía poscuántica. Los desarrolladores que trabajan en criptografía poscuántica pueden comunicarse con NVIDIA para obtener actualizaciones sobre la disponibilidad. La serie X800 de conmutadores de red de NVIDIA acelera la infraestructura de IA. En concreto, la serie X800 contiene los conmutadores Ethernet NVIDIA Quantum-X800 InfiniBand o NVIDIA Spectrum-X800, el conmutador NVIDIA Quantum Q3400 y el NVIDIA ConnectXR-8 SuperNIC. Los conmutadores X800 estarán disponibles en 2025. Las principales asociaciones detalladas durante la conferencia magistral de NVIDIA incluyen: La plataforma de IA de pila completa de NVIDIA estará en Enterprise AI de Oracle a partir del 18 de marzo. AWS brindará acceso a las instancias Amazon EC2 basadas en GPU NVIDIA Grace Blackwell y a NVIDIA DGX Cloud con seguridad Blackwell. NVIDIA acelerará Google Cloud con la plataforma informática NVIDIA Grace Blackwell AI y el servicio NVIDIA DGX Cloud, que llegarán a Google Cloud. Google aún no ha confirmado una fecha de disponibilidad, aunque es probable que sea a finales de 2024. Además, la plataforma DGX Cloud con tecnología NVIDIA H100 estará disponible de forma general en Google Cloud a partir del 18 de marzo. Oracle utilizará NVIDIA Grace Blackwell en su OCI Supercluster, OCI Compute y NVIDIA DGX Cloud en Oracle Cloud Infrastructure. Algunos servicios soberanos de IA combinados de Oracle y NVIDIA estarán disponibles a partir del 18 de marzo. Microsoft adoptará el Superchip NVIDIA Grace Blackwell para acelerar Azure. Se puede esperar la disponibilidad más adelante en 2024. Dell utilizará la infraestructura de inteligencia artificial y el paquete de software de NVIDIA para crear Dell AI Factory, una solución empresarial de inteligencia artificial de extremo a extremo, disponible a partir del 18 de marzo a través de canales tradicionales y Dell APEX. En un momento futuro no revelado, Dell utilizará el superchip NVIDIA Grace Blackwell como base para una arquitectura de refrigeración líquida, de alta densidad y a escala de rack. El Superchip será compatible con los servidores PowerEdge de Dell. SAP agregará capacidades de generación aumentada de recuperación de NVIDIA a su copiloto Joule. Además, SAP utilizará NIM de NVIDIA y otros servicios conjuntos. «Toda la industria se está preparando para Blackwell», dijo Huang. Competidores de los chips de IA de NVIDIA NVIDIA compite principalmente con AMD e Intel en lo que respecta al suministro de IA empresarial. Qualcomm, SambaNova, Groq y una amplia variedad de proveedores de servicios en la nube juegan en el mismo espacio en lo que respecta a la inferencia y el entrenamiento de IA generativa. AWS tiene sus propias plataformas de inferencia y formación: Inferentia y Trainium. Además de asociarse con NVIDIA en una amplia variedad de productos, Microsoft tiene su propio chip de inferencia y entrenamiento de IA: el Maia 100 AI Accelerator en Azure. Descargo de responsabilidad: NVIDIA pagó mi pasaje aéreo, alojamiento y algunas comidas para el evento NVIDIA GTC que se llevó a cabo del 18 al 21 de marzo en San José, California.