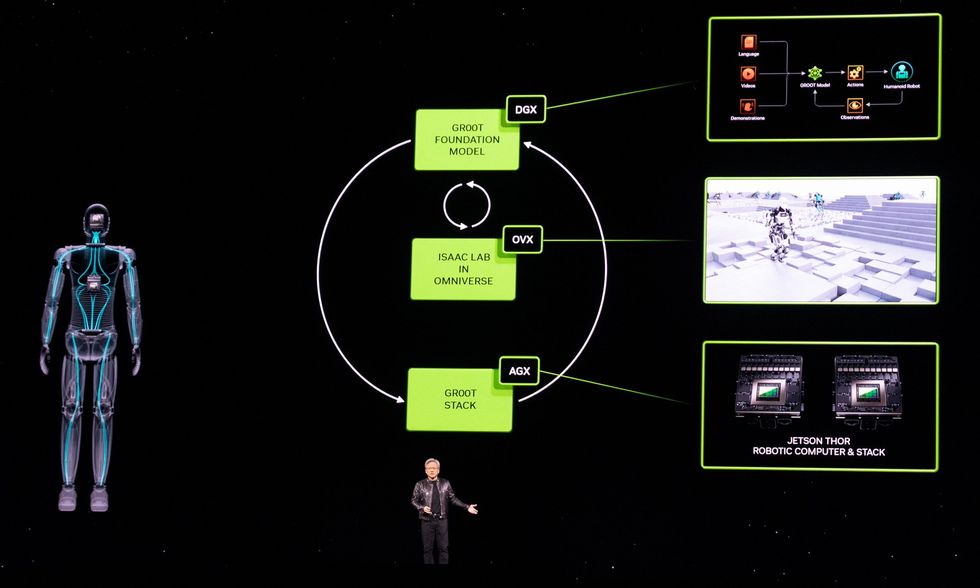

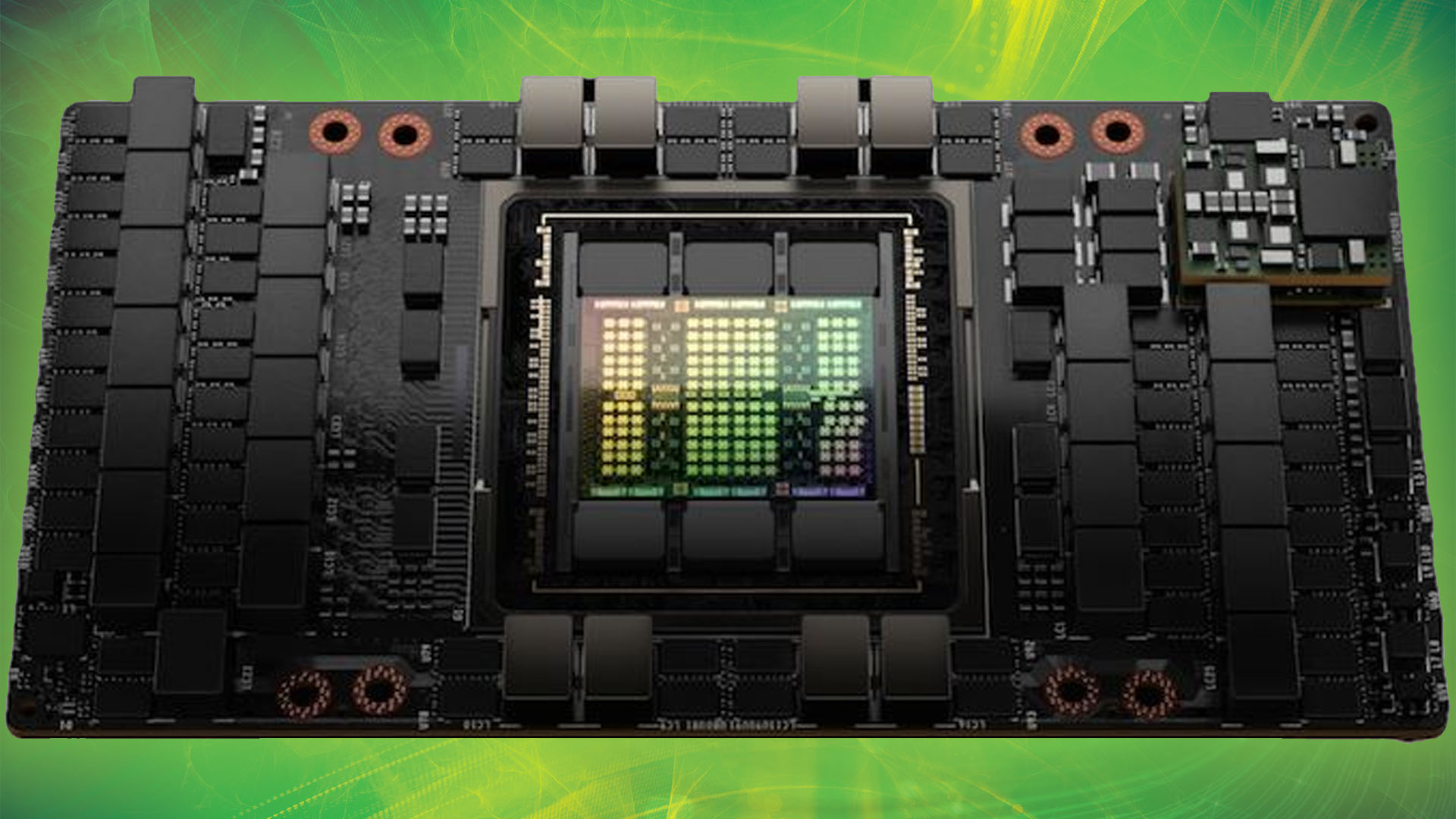

Como era de esperar, la actual conferencia de desarrolladores GTC de Nvidia en San José trata casi exclusivamente sobre IA este año. Pero entre los desarrollos de IA, Nvidia también ha hecho un par de anuncios importantes sobre robótica. Primero, está el Proyecto GR00T (con cada letra y número pronunciados individualmente para no provocar la ira de Disney), un modelo básico para robots humanoides. Y en segundo lugar, Nvidia se ha comprometido a ser el miembro fundador platino de Open Source Robotics Alliance, una nueva iniciativa de la Open Source Robotics Foundation destinada a garantizar que el sistema operativo de robot (ROS), una colección de bibliotecas de software de código abierto y herramientas, tiene el apoyo que necesita para prosperar.GR00TPrimero, hablemos de GR00T (abreviatura de “Tecnología Generalista Robot 00”). La forma en que los presentadores de Nvidia lo enunciaron letra por letra durante sus charlas sugiere claramente que en privado simplemente dicen «Groot». Así que, en lo que a mí respecta, el resto de nosotros también podemos decir simplemente «Groot». Como «modelo básico de propósito general para robots humanoides», el GR00T pretende proporcionar un punto de partida para que robots humanoides específicos realicen tareas específicas. Como es de esperar de algo que se presenta por primera vez en una conferencia magistral de Nvidia, es terriblemente vago en este momento y tendremos que profundizar en ello más adelante. Aquí encontrará prácticamente todo lo útil que Nvidia nos ha contado hasta ahora: “La construcción de modelos básicos para robots humanoides generales es uno de los problemas más interesantes de resolver en la IA hoy en día”, dijo Jensen Huang, fundador y director ejecutivo de NVIDIA. «Las tecnologías habilitadoras se están uniendo para que los principales especialistas en robótica de todo el mundo den pasos de gigante hacia la robótica general artificial». Los robots impulsados por GR00T… serán diseñados para comprender el lenguaje natural y emular movimientos mediante la observación de acciones humanas, aprendiendo rápidamente coordinación y destreza. y otras habilidades para navegar, adaptarse e interactuar con el mundo real. Esto suena bien, pero ese “será” supone mucho trabajo pesado. Aquí falta un “cómo” muy significativo. Más específicamente, necesitaremos una mejor comprensión de lo que subyace a este modelo básico: ¿hay datos reales de robots en alguna parte o se basan en una enorme cantidad de simulación? ¿Las empresas de robótica humanoide implicadas están aportando datos para mejorar GR00T o, por el contrario, entrenando sus propios modelos basándose en ellos? Es ciertamente notable que Nvidia mencione a la mayoría de los pesos pesados en humanoides comerciales, incluidos 1X Technologies, Agility Robotics, Apptronik, Boston Dynamics, Figure AI, Fourier Intelligence, Sanctuary AI, Unitree Robotics y XPENG Robotics. Podremos comunicarnos con algunas de esas personas directamente esta semana para, con suerte, obtener más información. En cuanto al hardware, Nvidia también anuncia una nueva plataforma informática llamada Jetson Thor:Jetson Thor fue creado como una nueva plataforma informática capaz de realizar tareas complejas e interactuar de forma segura y natural con personas y máquinas. Tiene una arquitectura modular optimizada en cuanto a rendimiento, potencia y tamaño. El SoC incluye una GPU de próxima generación basada en la arquitectura NVIDIA Blackwell con un motor transformador que ofrece 800 teraflops de rendimiento de IA de punto flotante de 8 bits para ejecutar modelos de IA generativa multimodal como GR00T. Con un procesador de seguridad funcional integrado, un grupo de CPU de alto rendimiento y 100 GB de ancho de banda Ethernet, simplifica significativamente los esfuerzos de diseño e integración. Hablando de la arquitectura Blackwell de Nvidia, hoy la compañía también presentó su GPU B200 Blackwell. Y para completar los anuncios, la fundición de chips TSMC y Synopsys, una empresa de automatización de diseño electrónico, dijeron que pondrán en producción la herramienta de litografía inversa de Nvidia, cuLitho. La Open Source Robotics AllianceEl otro gran anuncio es en realidad de Open Source Robotics Foundation, que está lanzando Open Source Robotics Alliance (OSRA), una “nueva iniciativa para fortalecer la gobernanza de nuestros proyectos de software de robótica de código abierto y garantizar la salud de la comunidad de Robot Operating System (ROS) Suite durante muchos años por venir. .” Nvidia es el miembro platino inaugural de OSRA, pero no está solo: otros miembros platino incluyen Intrinsic y Qualcomm. Otros miembros importantes incluyen Apex, Clearpath Robotics, Ekumen, eProsima, PickNik, Silicon Valley Robotics y Zettascale. [Open Source Robotics Foundation] Había planeado reestructurar sus operaciones ampliando la participación de la comunidad y expandiendo su impacto en el ecosistema ROS más amplio”, explica Vanessa Yamzon Orsi, directora ejecutiva de la Open Source Robotics Foundation. “La venta de [Open Source Robotics Corporation] fue el primer paso hacia esa visión, y el lanzamiento de OSRA es el siguiente gran paso hacia ese cambio”. Tuvimos tiempo para una breve sesión de preguntas y respuestas con Orsi para comprender mejor cómo afectará esto a la comunidad ROS en el futuro. Usted estructuró la OSRA para que tuviera una membresía mixta y un modelo meritocrático como la Fundación Linux. ¿Qué significa eso exactamente? Vanessa Yamzon Orsi: Hemos modelado la OSRA para permitir caminos hacia la participación en sus actividades a través de membresías pagas (para organizaciones y sus representantes) y los miembros de la comunidad que apoyan los proyectos a través de sus aportes. El modelo mixto permite la participación de la forma más adecuada para cada organización o individuo: contribuyendo con financiación como miembro pagador, contribuyendo directamente al desarrollo del proyecto, o ambos. ¿Cuáles son algunos de los beneficios para el ecosistema ROS que podemos esperar a través de OSRA?Orsi : Esperamos que OSRA beneficie los proyectos de OSRF de tres maneras significativas: proporcionando un flujo estable de financiación para cubrir el mantenimiento y el desarrollo del ecosistema ROS. Fomentando una mayor participación de la comunidad en el desarrollo a través de procesos abiertos y el logro de un estatus meritocrático y abierto. Al lograr una mayor participación de la comunidad en la gobernanza y garantizar que todas las partes interesadas tengan voz en la toma de decisiones. ¿Por qué será esto algo bueno para los usuarios de ROS? Orsi: La OSRA garantizará que ROS y el conjunto de proyectos de código abierto bajo la dirección de Open Robotics seguirá recibiendo apoyo y fortaleciéndose en los años venideros. Al proporcionar gobernanza y supervisión organizadas, caminos más claros hacia la participación comunitaria y apoyo financiero, proporcionará estabilidad y estructura a los proyectos y al mismo tiempo permitirá el desarrollo continuo. De los artículos de su sitio Artículos relacionados en la Web

Source link

Etiqueta: nvidia Página 2 de 3

Las capacidades de memoria están a punto de aumentar nuevamente… Pero en el lado de los portátiles. Micron ha anunciado que está trabajando en kits de memoria DDR5 SO-DIMM con 12 GB por módulo. DDR5 SO-DIMM: ¡capacidades de 12 GB por módulo de Micron! Desde la llegada de DDR5, las cosas se han vuelto locas rápidamente en lo que respecta a las capacidades de los módulos RAM. Hasta ahora, podíamos elegir entre 4 GB, 8 GB, 16 GB, etc. Sin embargo, recientemente hemos podido elegir módulos de 24 GB y 48 GB, las llamadas configuraciones «no binarias». Por supuesto, la ventaja reside en las capacidades de memoria mejoradas en comparación con los kits tradicionales. ¡Con una placa base con dos ranuras para RAM, por ejemplo, puedes obtener una configuración de 96 GB! En resumen, nos enteramos de que Micron también está planeando kits de memoria de este tipo en formato SO-DIMM, un formato comúnmente utilizado en portátiles en particular. Sin embargo, tendremos que conformarnos con kits de matriz de 12 GB. En términos de frecuencias, la memoria funcionaría a 5600 MT/s en su punto más rápido. También se ofrecerán versiones más lentas: 5200 MT/s y 4800 MT/s. En cuanto a los precios, se pueden encontrar varios kits en Amazon.co.uk, con un módulo de 12 GB a 5200 MT/s por 44,99 £ (52,64 €). El kit de 24 GB 5600 MT/s tiene un precio de 87,99 £ (102,94 €).

La GeForce RTX 4090 es una tarjeta gráfica innegablemente potente para juegos e incluso para algunas cargas de trabajo profesionales, y esta última fortaleza atrae ahora los intereses del mercado de la IA en China. De hecho, tanto es así que innumerables GPU de Nvidia se están enfrentando a destinos grises en granjas de servidores de IA, con consecuencias frustrantes para los jugadores. Recientemente, el gobierno federal de EE. UU. implementó una prohibición de exportación de chips de IA a China, lo que a su vez afectó a las tarjetas gráficas Nvidia como la GeForce RTX 4090. Esto ha tenido efectos dramáticos en ambos lados del mundo, con los precios de RTX 4090 disparándose en América del Norte y innumerables tarjetas de IA chinas que utilizan piezas del RTX 4090. Las consecuencias de este último son cada día más evidentes, con imágenes compartidas por I_Leak_VN, a través de X, que pintan un panorama terrible. Su publicación pretende mostrar un “almacén RTX 4090 AI Blower”, en el que se pueden ver cajas de tarjetas gráficas apiladas una encima de otra. Peor aún, estos comerciantes aparentemente cobran alrededor del doble de lo que normalmente se espera pagar por una GeForce RTX 4090 en China. Para el contexto, si esto fuera usando el MSRP de EE. UU., estaría desembolsando más de $ 3,000 por la tarjeta gráfica. De alguna manera, eso es incluso más de lo que era el RTX Titan en 2018. Si bien esto es desafortunado para los jugadores chinos, aquellos en las regiones occidentales no deberían preocuparse demasiado de que esto afecte las existencias de GeForce RTX 4090 a largo plazo. A diferencia del auge de las criptomonedas de hace unos años, esta demanda es, en última instancia, específica de cada región, y deberíamos ver que los precios de la tarjeta gráfica insignia se normalicen en los próximos meses, si no semanas. ¿Están sus planes de construcción de RTX 4090 en suspenso debido a los efectos de la prohibición de exportación? Háganos saber su opinión en la página de Facebook de PC personalizada, a través de Twitter, o únase a nuestro grupo de Facebook de Configuración de juegos y PC personalizada y aproveche el conocimiento de nuestros más de 400 000 miembros.

Los informes sobre el enorme éxito financiero de Nvidia debido a la adopción de sus chips específicos de IA han sido generalizados, pero hoy se ha revelado cuál ha sido la escala de ese éxito. Según un nuevo informe, Nvidia vendió medio millón de tarjetas con inteligencia artificial solo en el tercer trimestre de 2023. Ayer mismo vimos que TSMC predijo que Nvidia será la empresa de chips más grande del mundo, mientras que la semana pasada vimos que los ingresos por IA de la empresa aumentaron un 279% año tras año. Entonces, que Nvidia aparentemente esté pasando de ser una empresa de GPU a una empresa de inteligencia artificial, no es una novedad, pero la gran cantidad de chips que la empresa está vendiendo ciertamente sí lo es. Para ponerlo en contexto, en los últimos años Nvidia ha vendido generalmente entre 7 y 10 millones de tarjetas gráficas por trimestre, por lo que estas cifras de chips de IA no parecen tan grandes. Sin embargo, la gran mayoría de esas ventas de GPU son para tarjetas de gama baja con GPU pequeñas que se pueden producir a miles por oblea y venderse con márgenes relativamente pequeños. Estos chips de IA, sin embargo, son enormes y solo se producen cientos por oblea, pero se venden con márgenes enormes, con un costo de compra de alrededor de $ 10 000 para el Ampere A100 y alrededor de $ 33 000 para el Hopper H100. El informe procede de la empresa de investigación Omdia, cuyo análisis también muestra el desglose de los compradores de estos chips, con Microsoft y Meta a la cabeza con pedidos de alrededor de 150.000 chips cada uno. Google, Amazon y Oracle completan los cinco principales compradores de estos chips. Curiosamente, los resultados también muestran cómo los ingresos por servidores de Nvidia han cambiado y cambiarán, y si bien han aumentado significativamente en los últimos años, no se han disparado al mismo ritmo en general que las ventas de chips de IA, aunque, por supuesto, los saltos siguen siendo muy grandes. , midiendo decenas de miles de millones año tras año. Todo esto también se produce en el contexto de una prohibición de exportación de estos chips a China, lo que ha impulsado la conversión masiva de miles de tarjetas RTX 4090 en nuevas tarjetas de IA listas para servidores que se venden con un alto margen de beneficio. Cuando puedes conseguir una tarjeta muy potente como la 4090 con un precio de hasta 3.000 dólares, el precio de las tarjetas de IA dedicadas se pone en perspectiva. ¿Qué significa todo esto para las tarjetas gráficas para jugadores y para uso en estaciones de trabajo? Bueno, si Nvidia pudiera, estamos seguros de que felizmente continuaría produciendo muchos de ellos también. La pregunta más importante será la capacidad de producción, ya que la tan publicitada escasez de producción de los últimos años aparentemente continuará, a pesar de que se están construyendo varias nuevas fábricas de chips en todo el mundo. No esperaríamos que la disponibilidad se agote inmediatamente o que los precios aumenten aún más, pero tampoco es probable que veamos una caída de los precios en el mercado a tiempo para la llegada de productos como la serie RTX 5000, y mucho menos la próxima Serie RTX 4000 Súper. ¿Le preocupa hacia dónde se dirige el mercado de las tarjetas gráficas? Háganos saber su opinión en la página de Facebook de PC personalizada, a través de Twitter, o únase a nuestro grupo de Facebook de Configuración de juegos y PC personalizada y aproveche el conocimiento de nuestros más de 400 000 miembros.

Las instituciones militares, los institutos de investigación de IA y las universidades de China todavía pueden obtener y comprar chips de IA de NVIDIA, ¡aunque en pequeñas cantidades! ¡A AMD + NVIDIA se les prohíbe vender chips de IA a China! El gobierno de EE. UU. ordenó tanto a AMD como a NVIDIA que dejaran de vender chips de IA de alto rendimiento a China y Rusia el 26 de agosto de 2022. Esta prohibición se introdujo para evitar que ambos países utilizaran esos chips de IA de alto rendimiento con fines militares. Con efecto inmediato, el gobierno de EE. UU. prohibió la exportación de todos los chips de IA que sean iguales o más rápidos que los chips NVIDIA A100 (y H100) o AMD Instinct MI250. Luego, NVIDIA creó chips de IA A800 y H800 más lentos para el mercado chino, pero incluso ellos también fueron prohibidos en octubre de 2023. Recomendado: ¡AMD y NVIDIA tienen prohibido vender chips de IA a China! ¡China todavía tiene acceso a los chips de IA NVIDIA de alta velocidad! A pesar de la actual prohibición de la venta de chips de IA de alto rendimiento a China y Rusia, parece que los institutos de investigación chinos vinculados al ejército todavía pueden obtener y comprar chips de IA de NVIDIA, ¡aunque en pequeñas cantidades! Según un informe de Reuters del 14 de enero de 2024, los documentos de licitación pública muestran que docenas de instituciones militares, institutos de investigación de inteligencia artificial y universidades en China con vínculos con el ejército han comprado y recibido chips de inteligencia artificial de NVIDIA de alto rendimiento como el A100 y el H100. así como los chips AI A800 y H800 más lentos. El Instituto de Tecnología de Harbin compró seis chips NVIDIA A100 en mayo de 2023 para entrenar un modelo de aprendizaje profundo que la Universidad de Ciencia y Tecnología Electrónica de China compró en NVIDIA A100 en diciembre de 2022, para un propósito no especificado. Ambas universidades están sujetas a las restricciones de exportación de Estados Unidos, aunque la venta de esos chips de IA no es ilegal en China. Se identificaron más de 100 licitaciones en las que entidades estatales chinas compraron con éxito chips NVIDIA A100 y H100, y docenas de licitaciones muestran compras exitosas de los chips más lentos A800. La Universidad de Tsinghua compró dos chips H100 en diciembre de 2023, así como unos ochenta chips A100 desde septiembre de 2022. Un laboratorio del Ministerio de Industria y Tecnología de la Información compró un chip H100 en diciembre de 2023. Una entidad anónima del Ejército Popular de Liberación (EPL) con sede en Wuxi buscó para comprar tres chips A100 en octubre de 2023 y un chip H100 en enero de 2024 El Instituto de Inteligencia Artificial de Shandong compró cinco chips A100 de Shandong Chengxiang Electronic Technology en diciembre de 2023 La Universidad de Chongqing compró un chip NVIDIA A100 en enero de 2024. Recomendado: Can StopNCII Remove All Nude / ¡¿Fotos falsas profundas?! Para ser claros, ni NVIDIA ni sus minoristas aprobados suministraron esos chips. NVIDIA dijo que cumple con todas las leyes de control de exportaciones aplicables y exige que sus clientes hagan lo mismo: si nos enteramos de que un cliente ha realizado una reventa ilegal a terceros, tomaremos las medidas inmediatas y apropiadas. – Portavoz de NVIDIA Aunque las entidades estatales chinas parecen poder comprar chips de IA de alto rendimiento, el informe de Reuters también muestra la eficacia de la prohibición estadounidense de chips de IA. El entrenamiento de grandes modelos de inteligencia artificial requiere miles de chips de IA de alto rendimiento, y China no parece ser capaz de adquirir más que un puñado de estos chips críticos. Eso no significa que China esté desacelerando sus iniciativas de IA. En lugar de depender de las “importaciones grises” de chips AI de AMD o NVIDIA, las entidades chinas están haciendo todo lo posible para cambiar a alternativas locales. En 2023, HUAWEI recibió pedidos de unos 5.000 de sus chips Ascent 910B. Megaempresas chinas como Baidu, Alibaba y Tencent también tienen sus propios chips de IA internos como Kunlunxin Gen 2, Hanguang 800 y Zixiao. ¡Por favor apoye mi trabajo! ¡Apoya mi trabajo a través de una transferencia bancaria/PayPal/tarjeta de crédito! Nombre: Adrian WongTransferencia bancaria: CIMB 7064555917 (Código Swift: CIBBMYKL)Tarjeta de crédito/Paypal: https://paypal.me/techarp El Dr. Adrian Wong ha estado escribiendo sobre tecnología y ciencia desde 1997, e incluso ha publicado un libro con Prentice Hall llamado Rompiendo la barrera del BIOS (ISBN 978-0131455368) mientras estaba en la escuela de medicina. Continúa dedicando innumerables horas todos los días a escribir sobre tecnología, medicina y ciencia, en su búsqueda de hechos en un mundo de posverdad.

[/su_note]

Lectura recomendada Volver a > Negocios | Computadora | Soporte técnico ARP ¡ARP técnico! Apóyenos visitando a nuestros patrocinadores, participando en los foros Tech ARP o haciendo una donación a nuestro fondo. ¡Gracias! Así: Me gusta Cargando…

NVIDIA ha presentado recientemente un innovador chatbot con IA, Chat with RTX. Está diseñado para ejecutarse localmente en PC con Windows equipadas con GPU NVIDIA RTX series 30 o 40. Esta innovadora herramienta permite a los usuarios personalizar un chatbot con su contenido. Mantiene datos confidenciales en sus dispositivos y evita la necesidad de servicios basados en la nube. El chatbot “Chat with RTX” está diseñado como un sistema localizado que los usuarios pueden utilizar sin acceso a Internet. Todas las GPU GeForce RTX 30 y 40 con al menos 8 GB de memoria de video son compatibles con la aplicación. Chat with RTX admite múltiples formatos de archivos, incluidos texto, pdf, doc/docx y XML. Simplemente apunte la aplicación a la carpeta que contiene los archivos y los cargará en la biblioteca en segundos. Además, los usuarios pueden proporcionar la URL de una lista de reproducción de YouTube y la aplicación cargará las transcripciones de los vídeos de la lista de reproducción. Esto permite al usuario consultar el contenido que cubre. A juzgar por la descripción oficial, los usuarios pueden utilizar Chat With RTX de la misma forma que utilizan ChatGPT a través de diferentes consultas. Sin embargo, los resultados generados se basarán completamente en conjuntos de datos específicos. Esto parece ser más adecuado para operaciones como generar resúmenes y buscar documentos rápidamente. Tener una GPU RTX con soporte TensorRT-LLM significa que los usuarios trabajarán con todos los datos y proyectos localmente. Por lo tanto, no será necesario que los usuarios guarden sus datos en la nube. Esto ahorrará tiempo y proporcionará resultados más precisos. Nvidia dijo que TensorRT-LLM v0.6.0 mejorará el rendimiento 5 veces y se lanzará a finales de este mes. Además, admitirá otros LLM como Mistral 7B y Nemotron 3 8B. Noticias de la semana de Gizchina Características clave de Chat con procesamiento local RTX: Chat con RTX se ejecuta localmente en PC y estaciones de trabajo con Windows RTX, brinda respuestas rápidas y mantiene la privacidad de los datos del usuario. Personalización: los usuarios pueden personalizar el chatbot con su contenido, incluidos archivos de texto, PDF, DOC/DOCX, XML y videos de YouTube. Generación aumentada de recuperación (RAG): el chatbot utiliza RAG, el software NVIDIA TensorRT-LLM y la aceleración NVIDIA RTX para generar contenido y proporcionar respuestas contextualmente relevantes. Modelos de lenguajes grandes (LLM) de código abierto: los usuarios pueden elegir entre dos LLM de código abierto, Mistral o Llama 2, para entrenar su chatbot. Fácil de usar para desarrolladores: Chat with RTX se creó a partir del proyecto de referencia para desarrolladores TensorRT-LLM RAG, disponible en GitHub, lo que permite a los desarrolladores crear sus aplicaciones basadas en RAG. Requisitos y limitaciones Requisitos de hardware: Chat con RTX requiere una GPU NVIDIA GeForce RTX serie 30 o superior con al menos 8 GB de VRAM, Windows 10 u 11 y los controladores de GPU NVIDIA más recientes. Tamaño: el chatbot es una descarga de 35 GB y la instancia de Python ocupa alrededor de 3 GB de RAM. El chatbot se encuentra en la etapa inicial de demostración para desarrolladores, por lo que todavía tiene una memoria de contexto limitada y una atribución de fuente inexacta. Aplicaciones y beneficios Investigación de datos: el chat con RTX puede ser una herramienta valiosa para la investigación de datos, especialmente para periodistas o cualquier persona que necesite analizar una colección de documentos. Privacidad y seguridad: al mantener los datos y las respuestas restringidos al entorno local del usuario, existe una reducción significativa en el riesgo de exponer información confidencial externamente. Educación y aprendizaje**: Chat with RTX puede proporcionar tutoriales rápidos e instrucciones basadas en los mejores recursos educativos. Conclusión Chat with RTX es un desarrollo interesante en el mundo de la IA, que ofrece un chatbot personalizado y ejecutado localmente que puede aumentar la productividad de los trabajadores y al mismo tiempo reducir los problemas de privacidad. Como demostración inicial para desarrolladores, todavía tiene algunas limitaciones, pero muestra el potencial de acelerar los LLM con GPU RTX y la promesa de lo que un chatbot de IA puede hacer localmente en su PC en el futuro. ¿Qué opinas de esta nueva característica? Háganos saber su opinión en la sección de comentarios a continuación. Descargo de responsabilidad: es posible que algunas de las empresas de cuyos productos hablamos nos compensen, pero nuestros artículos y reseñas son siempre nuestras opiniones honestas. Para obtener más detalles, puede consultar nuestras pautas editoriales y conocer cómo utilizamos los enlaces de afiliados.

TL;DR NVIDIA ha lanzado una nueva herramienta gratuita llamada «Chat with RTX» que permite a los propietarios de GeForce RTX serie 30 y superiores ejecutar un chatbot en su propio contenido desde su propia PC. Los usuarios pueden alimentar sus propios archivos o dirigirlos a videos y listas de reproducción de YouTube. Luego pueden realizar consultas para obtener respuestas de estas fuentes. El chat con RTX se ejecuta sin conexión, por lo que es inherentemente más privado que los chatbots de IA en línea como ChatGPT y Gemini. La IA ha permeado todos los aspectos de nuestra vida. Entre ChatGPT y Gemini, prácticamente todos tenemos acceso a un asistente virtual inteligente de IA que puede buscarnos en Internet y brindarnos información relevante en segundos. Pero donde estos asistentes gratuitos de IA fallan es cuando necesitas acciones en tu propio conjunto de datos. Ejecutar su propio chatbot de IA localmente no es del agrado de todos, y suscribirse a niveles más altos puede que tampoco sea una opción para algunos. NVIDIA está haciendo que sea mucho más fácil para los propietarios de GPU GeForce ejecutar su propio chatbot de IA con la nueva herramienta Chat with RTX. Chat with RTX es una herramienta gratuita ofrecida por NVIDIA que permite a los usuarios personalizar un chatbot con su propio contenido. Las consultas son aceleradas por la GPU NVIDIA en su PC con Windows, con soporte restringido a GeForce RTX serie 30 y superiores con al menos 8 GB de VRAM. También necesita Windows 10 o superior y los controladores de GPU NVIDIA más recientes. NVIDIA también aclara que la herramienta es una demostración técnica, así que no espere un nivel de pulido de ChatGPT desde el principio. Chat con RTX esencialmente brinda capacidades de IA generativa a su propia PC. Puede introducir sus propios archivos como conjunto de datos y utilizar grandes modelos de lenguaje de código abierto como Mistral o Meta’s Llama 2 para permitir consultas y obtener respuestas rápidas y contextualmente relevantes. Puede alimentar Chat con RTX en varios formatos de archivo, incluidos .txt, .pdf, .doc/.docx y .xml. También puedes alimentarlo con información de vídeos y listas de reproducción de YouTube. Dado que Chat with RTX se ejecuta localmente, sus datos permanecen en su dispositivo, lo cual es perfecto si desea procesar datos confidenciales sin conexión. NVIDIA observa algunas limitaciones para Chat with RTX. El chat con RTX no puede recordar el contexto, por lo que no puede hacer preguntas de seguimiento. La herramienta también funciona mejor si busca datos distribuidos en unos pocos documentos en lugar de solicitar un resumen de unos pocos documentos. NVIDIA se contenta con llamar a esto una demostración técnica, pero sigue siendo una gran herramienta para empezar. ¿Tienes un consejo? ¡Háblanos! Envíe un correo electrónico a nuestro personal a news@androidauthority.com. Puedes permanecer en el anonimato u obtener crédito por la información, es tu elección.Comentarios

Source link

Aunque CES se centra en el consumidor, muchas de las herramientas y tecnologías de la gran feria comercial de Las Vegas pueden ayudar a las empresas. Aquí están nuestras selecciones de los productos y tendencias más destacados en CES 2024, incluidas computadoras portátiles versátiles, un asistente portátil de IA generativa, televisores elegantes y realidad mixta para reuniones o capacitaciones inmersivas. 1. La IA generativa se integra con computadoras portátiles y aplicaciones La IA generativa como ChatGPT se ha convertido en lo más popular en tecnología durante el último año, por lo que no sorprende que la IA generativa esté presente a lo grande en CES. Las computadoras portátiles con Windows 11 de Dell y otros fabricantes tendrán un botón Windows para Copilot dedicado para el asistente de inteligencia artificial en lenguaje natural de Microsoft. Intel, Qualcomm, AMD y NVIDIA están trabajando para desarrollar la capacidad de ejecutar IA generativa directamente en su hardware. NVIDIA presentó Chat with RTX, que es una aplicación de demostración para personalizar un modelo de IA generativa para buscar contenido que incluye chats, documentos y videos en una PC o estación de trabajo con Windows RTX. IA generativa en el comercio minorista en CES 2024 Además, la IA generativa apareció en aplicaciones minoristas en CES 2024, y Walmart la estrenó en una “plataforma de comercio social” llamada Shop With Friends. Volkswagen pone ChatGPT en los automóviles Volkswagen está colocando ChatGPT en sus automóviles, lo que permite a un profesional ocupado pedirle a la IA generativa que realice tareas mientras está en movimiento. Es difícil decir si estos casos de uso resultarán tan o más deseables que los asistentes de IA existentes basados en voz (pero no generativos) a largo plazo. 2. Los dispositivos de productividad enfatizan la velocidad y la facilidad El dispositivo más popular en CES 2024 fue el Rabbit R1 (Figura A), un dispositivo portátil basado en IA generativa que no solo podría revolucionar la forma en que las personas interactúan con las aplicaciones, sino que posiblemente reemplazaría al teléfono inteligente como medio de uso personal. pantalla principal. Figura A: Rabbit R1 utiliza IA generativa para automatizar tareas que de otro modo se realizarían a través de una aplicación. Imagen: Rabbit El R1, que actualmente está disponible para pedidos anticipados por $199, se ejecuta en lo que Rabbit llama un modelo de acción grande, a diferencia de un modelo de lenguaje grande. El usuario puede pronunciar un comando (por ejemplo, «Reservar un vuelo») y el R1 simplemente lo hará sin que el usuario necesite abrir una aplicación o que el dispositivo necesite conectarse a una aplicación mediante una API. El Rabbit R1 es el ejemplo más dramático de la principal tendencia de productividad en CES 2024 de permitir que la IA generativa sea la interfaz entre el usuario y sus tareas, haciendo que los servicios en línea y las decisiones intermedias sean esencialmente invisibles. VER: Si bien ChatGPT se integró con otra tecnología en CES 2024, OpenAI abrió la Tienda GPT. (TechRepublic) Los monitores 3D e inalámbricos brindan más opciones de pantalla Lenovo presentó su monitor 3D Lenovo ThinkVision 27, que permite a los usuarios transformar imágenes 2D en contenido 3D rápidamente; Esto podría suponer un aumento de la productividad para los profesionales creativos. Mientras tanto, Samsung presentó una nueva configuración de monitores múltiples sin cables que ganó el premio CES 2024 Best of Innovation en periféricos y accesorios de computadora. Wi-Fi 7 está proliferando La Wi-Fi Alliance está comenzando a implementar certificaciones para Wi-Fi 7, lo que significa que más dispositivos podrán ejecutar los mayores rendimientos de datos de Wi-Fi 7 para aplicaciones como la realidad virtual. TP-Link, UniFi, MSI y Acer lanzaron enrutadores Wi-Fi 7 en la feria. Más sobre innovación 3. Las computadoras portátiles múltiples en 1 brindan opciones a los profesionales Varias computadoras portátiles que también funcionan como tabletas fueron lo más destacado de CES 2024. Por ejemplo, se exhibieron la computadora portátil 2 en 1 Spectre x360 de HP y la nueva línea XPS de Dell. ASUS presentó el Zenbook DUO (2024) UX8406 (Figura B), que viene con dos pantallas y un teclado y se puede convertir en cinco modos en total: una computadora portátil con teclado, dos pantallas táctiles, pantalla dual, modo de escritorio (dependiendo de si las pantallas están orientados al teclado de forma horizontal o vertical) o modo compartir (usar ambas pantallas para mostrar datos o presentaciones). Figura B: Las presentaciones y los datos se pueden compartir fácilmente utilizando el modo para compartir dos pantallas del ASUS Zenbook DUO. Imagen: ASUS 4. Qualcomm, fabricantes de automóviles y otros promueven productos de realidad virtual y mixta. Se espera que el chip Snapdragon XR2+ Gen 2 de Qualcomm aparezca en un casco de realidad virtual o mixta de Samsung a finales de este mes. Qualcomm ya ha lanzado un dispositivo de referencia que podría competir con el Apple Vision Pro. La realidad mixta y virtual también estuvo presente en el CES, con BMW investigando gafas de realidad mixta para conducir. 5. Las pantallas de TV curvas y transparentes llaman la atención Una pantalla de TV transparente podría ser una pieza impresionante para una oficina en casa, convirtiéndose en un objeto de arte en lugar de solo un rectángulo negro cuando no la esté usando. El Samsung Transparent MICRO LED y el LG Signature OLED T (Figura C) son espectaculares. Figura C: El televisor transparente LG Signature OLED T podría ser una parte llamativa de una oficina en casa. Imagen: LG En CES 2024 se mostró una amplia variedad de monitores curvos grandes para juegos. Otra tendencia fue reducir el deslumbramiento en los televisores, como con el revestimiento antideslumbrante del televisor OLED Samsung S95D. Nota del editor: TechRepublic cubre CES 2024 de forma remota.

En CES 2024 en Las Vegas, Qualcomm reveló las capacidades de IA en el dispositivo del chip Snapdragon XR2+ Gen 2 para auriculares de realidad virtual y mixta. Durante un discurso de apertura el 10 de enero, el presidente y director ejecutivo de Qualcomm, Cristiano Amon, habló sobre los casos de uso empresarial de la realidad virtual, incluido el suministro de entornos digitales para la capacitación. Sugirió tres preguntas que la realidad virtual y la resonancia magnética podrían responder para las empresas: “¿Cómo se capacita a las personas? ¿Cómo te sumerges de lleno en ese entorno digital? ¿Cómo se desarrollan las comunicaciones? Además, Amon habló sobre sus predicciones para el futuro de los teléfonos mejorados con IA. Nota: Este artículo se actualizó para reflejar el discurso de apertura de Qualcomm del 10 de enero. TechRepublic cubre CES 2024 de forma remota. Los chips Snapdragon XR2+ Gen 2 mejoran las reuniones de realidad virtual y mixta. El Snapdragon XR2+ Gen 2 es la continuación de la plataforma Snapdragon XR2 Gen 2 para IA, realidad virtual y realidad mixta. El Snapdragon XR2+ Gen 2 ofrece lo siguiente: resolución de 4,3K por 4,3K por ojo. 90 fotogramas por segundo. Admite 12 o más cámaras simultáneas para seguimiento de movimiento Conectividad Wi-Fi 7, Wi-Fi 6E, Bluetooth 5.3 y Bluetooth 5.2. El Snapdragon XR2+ Gen 2 tiene una frecuencia de GPU más alta en un 15 % y una frecuencia de CPU en un 20 % en comparación con el Snapdragon XR2 Gen 2. Eso ayuda al Snapdragon XR2+ Gen 2 a proporcionar “pantallas a escala de habitación, superposiciones de tamaño real y escritorios virtuales” más fluidos. dijo Hugo Swart, vicepresidente y director general de XR, Qualcomm Technologies, Inc., en un comunicado de prensa. VER: En más noticias de CES 2024, HP presentó sus computadoras portátiles Spectre x360 16 2 en 1 y Spectre x360 14 2 en 1 capaces de ejecutar cargas de trabajo de IA locales. (TechRepublic) «Nuestro trabajo era crear un motor informático que pudiera hacer que esa tecnología (IA) se ejecutara de manera generalizada», dijo Amon durante el discurso de apertura de Qualcomm en CES. “Estamos en un punto en el que esas capacidades (de IA) en los procesadores y semiconductores están disponibles. El siguiente paso es desarrollar esos casos de uso y aplicaciones”. Para las empresas y los empleados, eso significa escritorios virtuales, reuniones virtuales y demostraciones virtuales más eficientes. Tenga en cuenta que esto no significa necesariamente que la IA generativa se ejecute en unos auriculares; en cambio, el rendimiento de la IA de un solo chip ayuda a realizar un seguimiento de todos los datos necesarios para fusionar imágenes digitales y físicas. «La computación espacial será otra plataforma informática que eventualmente alcanzará una gran escala», dijo Amon durante la conferencia magistral. Qualcomm, que compite con Apple, Intel y NVIDIA, Samsung y Google utilizarán el Snapdragon XR2+ Gen 2 en sus ofertas planificadas de realidad virtual (Figura A) que se ejecutan en Android, que eventualmente podría competir con el Apple Vision Pro. El Snapdragon XR2+ Gen 2 compite actualmente con la tecnología AI PC de Intel para dispositivos livianos y automotrices, así como con los semiconductores de NVIDIA. Figura A La plataforma de referencia para los auriculares VR y MR de Qualcomm. Una plataforma de referencia es una prueba de concepto para posibles aplicaciones de hardware. Imagen: Qualcomm Technologies, Inc. Qualcomm mira hacia el futuro con teléfonos mejorados con IA Durante su discurso de apertura, Amon analizó la historia de Qualcomm en el espacio de la telefonía móvil. El desarrollo de chips en los que ejecutar IA representa una evolución de la tecnología de dispositivos móviles, dijo, pero no predice que los dispositivos impulsados por IA reemplazarán a los teléfonos actuales. En cambio, Amon dijo: «Lo que va a pasar ahora es que el teléfono tendrá una función diferente, que no es sólo la que solía hacer, donde el teléfono era bueno para todas las aplicaciones que tienes, sino que también el teléfono va a funcionar». comunicarse con la nube. El teléfono no irá a ninguna parte, pero será mejorado por la IA”. Por ejemplo, dijo Amon, una persona podría pedirle a un asistente de IA generativa que llame a un Uber. En lugar de utilizar la aplicación Uber en el teléfono, el asistente de IA generativa puede conectarse directamente a Uber a través de la nube. Noticias de tecnología automotriz de Qualcomm en CES 2024 Qualcomm continuó la tendencia clásica de CES de mostrar la última tecnología automotriz con su plataforma Snapdragon Digital Chassis, que permite servicios de automóviles conectados para el trabajo en movimiento y la eficiencia de la vida. Otras ofertas de automóviles conectados de Qualcomm que se mostrarán en CES 2024 incluyen: Snapdragon Ride Platform, que ayuda a los fabricantes de automóviles globales y a los proveedores de nivel 1 a crear soluciones de conducción automatizada con funciones de asistencia a la conducción de nivel 3, como mantenerse en el carril y mantener automáticamente la velocidad. Snapdragon Ride Flex SoC, informática centralizada para cabina digital, asistencia al conductor y determinadas funciones de conducción autónoma en un único sistema en chip. Los servicios Snapdragon Car-to-Cloud brindan una manera para que las organizaciones impulsen actualizaciones a los servicios de automóviles conectados. Un entorno nativo de la nube altamente eficiente para el desarrollo y la implementación de aplicaciones automotrices proporcionado en colaboración con AWS. SoC Snapdragon Digital Chassis para vehículos de dos ruedas para vehículos pequeños y vehículos agrícolas o ganaderos. Una de las actualizaciones son las “cabinas digitales habilitadas para IA de próxima generación” de Qualcomm para IA generativa en el borde (en este caso, sobre la marcha). Eso significa que los automóviles, dependiendo de la marca individual y de las ofertas de aplicaciones, pueden ejecutar aplicaciones de inteligencia artificial generativa para actualizaciones dinámicas de información relevante para los conductores en la carretera. Los servicios y recomendaciones se pueden personalizar y las aplicaciones pueden anticipar las preferencias y necesidades del conductor. «Nuestro compromiso con el avance de la tecnología automotriz en apoyo de los fabricantes de automóviles globales, los proveedores de primer nivel y nuestros socios del ecosistema está ayudando a dar forma al futuro de los vehículos definidos por software y nos está acelerando hacia una nueva era para la industria automotriz», dijo Nakul Duggal, senior vicepresidente y director general de automoción y computación en la nube de Qualcomm Technologies, Inc., en un comunicado de prensa.